2. 中移信息系统集成有限公司, 北京 100032;

3. 中国人民大学 新闻学院, 北京 100872

2. China Mobile Information System Integration Co., Ltd., Beijing 100032, China;

3. School of Journalism and Communication, Renmin University of China, Beijing 100872, China

21世纪以来,人工智能技术取得了长足进展。深度学习技术极大提升了包括自然语言处理(natural language processing,NLP)等在内的各人工智能方向的发展水平,而语言模型是NLP的重要研究方向之一。语言模型最初是指用于计算一个句子概率的统计模型。随着人工智能技术快速发展,基于神经网络的词向量语言模型和大规模预训练语言模型已逐渐成为解决各种NLP问题的主流方法,大幅提高了NLP的智能化水平。需要特别说明的是,预训练语言模型的无监督训练属性使其极易获取海量训练样本,并且完成训练的预训练语言模型包含大量语义、语法知识,能显著提升下游任务的输出效果。

近年来大规模预训练语言模型发展迅速[1-2],国外的生成式预训练模型(generative pre-trained transformer,GPT)系列等产品(GPT1、GPT2、GPT3、ChatGPT/InstructGPT、GPT4)[3-7]快速迭代更新,在带动整个行业快速发展的同时掀起了大语言模型研发浪潮。在此背景下,国内科技企业也纷纷布局大语言模型研究,华为的“盘古”系列、百度的“文心一言”、商汤科技的“商量”、阿里的“通义千问”等先后发布。随着训练数据量越来越大,训练方法不断更新,大语言模型结构越来越复杂,许多大语言模型已在语言翻译、文摘构建、命名实体识别、文本分类和关系抽取等多种场景,以及政务、金融和生物医药等多个行业得到广泛应用。

中国在国家层面明确并持续推动人工智能技术的发展和应用。2015年印发的《关于积极推进“互联网+”行动的指导意见》[8]首次将人工智能纳入重点任务之一,推动中国人工智能步入新阶段。2017年印发的《新一代人工智能发展规划》[9]确立了新一代人工智能发展“三步走”战略目标,将人工智能提升至国家战略层面。2020年印发的《国家新一代人工智能标准体系建设指南》[10]指出,要加强人工智能领域标准化顶层设计,推动人工智能产业技术研发和标准制定。《中华人民共和国国民经济和社会发展第十四个五年规划和2035年远景目标纲要》[11]指出,要“培育壮大人工智能、大数据、区块链、云计算、网络安全等新兴数字产业”。

政务领域始终是人工智能技术的主战场之一。2021年印发的《“十四五”数字经济发展规划》[12]要求,“推动智能计算中心有序发展,打造智能算力、通用算法和开发平台一体化的新型智能基础设施,面向政务服务、智慧城市、智能制造、自动驾驶、语言智能等重点新兴领域,提供体系化的人工智能服务”“高效布局人工智能基础设施,提升支撑‘智能+’发展的行业赋能能力”。2023年发布的《生成式人工智能服务管理暂行办法》[13]指出,国家“支持行业组织、企业、教育和科研机构、公共文化机构、有关专业机构等在生成式人工智能技术创新、数据资源建设、转化应用、风险防范等方面开展协作”。大语言模型能够辅助提高政务治理效能,推动“服务型”政府转型。基于此,本文首先综述了语言模型的研究进展,其次重点综述了大语言模型的研究进展,最后介绍了大语言模型在政务领域的应用,并讨论了政务大语言模型研究需要解决的若干问题,以期指导大语言模型的研究,推动大语言模型在政务领域的广泛应用。

1 大语言模型发展历程语言模型应用于NLP的时间较早,主要功能如下:1) 判断自然语言生成类任务生成的语句是否符合人类语言学规律,进而辅助自然语言理解。2) 通过统计方法分析大量语料,进而为自然语言理解模型提供语言学知识。早期的语言模型主要包括统计语言模型和神经网络语言模型2类。大规模预训练语言模型是在神经网络语言模型基础上发展而来的主流语言模型。

1.1 统计语言模型统计语言模型致力于将句子转化为概率分布。根据链式法则和条件概率公式,一个句子出现的概率表示如下:

| $\begin{gathered}P(S)=P\left(w_1, w_2, \cdots, w_n\right)= \\ P\left(w_1\right) P\left(w_2 \mid w_1\right) P\left(w_3 \mid w_1, w_2\right) \cdots \\ P\left(w_n \mid w_1, w_2, \cdots, w_{n-1}\right)= \\ \prod\limits_{i=1}^n P\left(w_i \mid w_1^{i-1}\right) .\end{gathered}$ | (1) |

其中:S为句子,n为S的词数,wi为S的第i个词。由于P(S)明显存在参数规模过大的问题,因此,N-1阶Markov假设提出:当前词的出现概率仅与前N-1个词有关。这使统计语言模型进一步简化为N-gram模型,表示如下:

| $P(S)=\prod\limits_{i=1}^n P\left(w_i \mid w_{i-N+1}^{i-1}\right).$ | (2) |

当N取1、2、3时,N-gram模型可分别称为unigram、bigram、trigram。在N-gram模型中,模型参数为XN,其中X为词表的大小。XN决定模型精确度,虽然N越大,理论上模型精确度越高,但模型复杂度也随之增大,需要匹配的计算资源和训练语料数据量也越大。因此,N>4的情况极少。这一时期语言模型研究关注的重点是实现数据平滑,即如何在算力有限的情况下,尽可能使用较少的数据拟合人类语言。受数据和算力限制,统计语言模型未能发挥通过海量数据将语言知识整合到模型中的能力。

1.2 神经网络语言模型随着数据量不断增长,统计模型的劣势在解决语言建模的问题时逐渐显露。深度学习技术出现之后,借助神经网络,语言模型研究再次取得新的发展。2003年,Bengio等[14]将神经网络引入语言模型,用一个3层神经网络构建了训练任务与N-gram相同的语言模型,从而提出神经网络语言模型(neural network language model,NNLM),这对语言模型发展具有划时代意义。NNLM优化的目标函数T表示如下:

| $T=\sum\limits_D P\left(w_i \mid w_{i-(n-1)}, w_{i-(n-2)}, \cdots, w_{i-1}\right).$ | (3) |

其中:D为S的1组文本集合,D中每个元素均为长度为n的文本序列wi-(n-1), wi-(n-2), …, wi。

为更好地将文本之前的信息应用于当前输出的计算中,循环神经网络(recurrent neural network,RNN)被引入语言模型,从而诞生了循环神经网络语言模型[15]。然而,RNN也存在训练时梯度消失或爆炸、无法并行训练等问题。此外,RNN存在“长期依赖”问题,即神经网络节点经反复计算后,之前时间片的特征被覆盖。为解决RNN存在的“长期依赖”问题,长短期记忆网络(long short-term memory, LSTM)引入了“门”机制,用于控制特征的流通和损失,可在预测时捕捉之前的远端信息,避免远端信息的特征被覆盖。在NNLM中,词向量作为副产物首次出现。此后,用于训练词向量的语言模型陆续出现,并且相比随机初始化词向量性能更佳。具有代表性的方法包括Word2vec[16-17]、Glove[18]等。Word2vec使用唯一的特征向量表示每个词,其基本原理是2个词的上下文相似,则词向量也相似。由于同一个词在不同句子中可能具有不同含义,因此Word2vec不能解决一词多义问题。基于此,2018年提出的ELMo[19]选择以句子为单位生成词向量,进一步让每个词在不同句子中具有不同的向量表示,使词向量在下游任务中拥有更好的表现。实际上,ELMo已融入了“预训练+微调”的思想,这也预示大语言模型的繁荣时代即将开启。

1.3 大规模预训练语言模型2017年,Google提出基于自注意力机制的特征提取器Transformer[20],取代了语言模型研究之前常用的卷积神经网络(convolutional neural networks,CNN)、RNN等结构。自注意力机制核心原理的公式化表示如下:

| $\operatorname{Attention}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})=\operatorname{softmax}\left(\frac{\boldsymbol{Q} \boldsymbol{K}^{\mathrm{T}}}{\sqrt{d_k}}\right) \boldsymbol{V}.$ | (4) |

其中:Q、K、V这3个矩阵均来自输入的同一线性变换;QKT是一个方阵,保存每个向量与所有向量内积运算的结果,即一个向量在另一个向量上的投影;dk为计算机语言k_dim的公式化表述,表示Q、K、V这3个矩阵的维度,

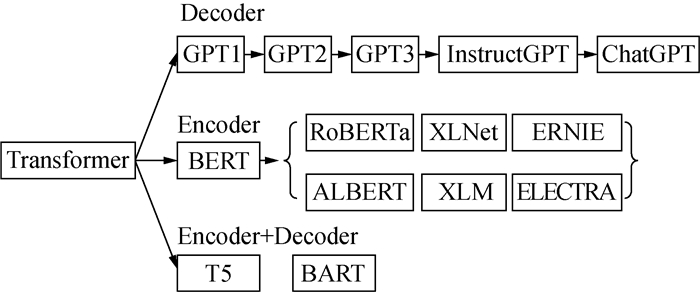

Transformer模型包括Encoder和Decoder,Encoder用于编码输入层,Decoder用于将编码后的信息解码并获得输出结果。Transformer模型能够同时关注上下文信息,训练时间更短。Transformer模型衍生了“Transformer系列”方法,如双向和自回归Transformers(bidirectional and auto-regressive transformers, BART)[21]、文本到文本迁移的Transformer(text-to-text transfer transformer, T5)[22]等。其中,BART引入噪声分解原始训练文本,使训练的模型能够扩大文本长度的推理空间。T5同样使用了基于完整Transformer结构的预训练语言模型,将各种问题统一为文本到文本的格式。同时,一系列仅使用Transformer模型部分结构的新模型陆续出现,使大规模预训练语言模型领域迎来了蓬勃发展的时机,主要包括基于Encoder的模型和基于Decoder的模型。Transformer模型衍生模型关系如图 1所示。

|

| 图 1 Transformer模型衍生模型关系 |

基于Encoder的模型以基于Transformers模型的双向编码器表示(bidirectional encoder representations from transformers, BERT)[23]为代表,因此也可称之为“BERT系列”方法,主要包括BERT、鲁棒优化的BERT方法(robustly optimized bert approach, RoBERTa)[24]、XLNet[25]、使用信息实体增强语言表示(enhanced language represen-tation with informative entities, ERNIE)模型[26]、跨语言模型(cross-lingual language models, XLM)[27]、轻量级BERT(a lite BERT, ALBERT)[28]、有效学习的准确分类Tokens替换的编码器(efficiently learning an encoder that classifies token replace-ments accurately, ELECTRA)[29]等。其中,BERT通过掩码语言模型(masked language model, MLM)和下一句话预测(next sentence prediction, NSP)构建,构建过程需要对大量语料进行无监督预训练。MLM先将训练语料中的词掩盖,再使用其他词预测出被掩盖词,类似于“完形填空”。NSP将训练语料中的不同句子重新组合,预测是否为前后句关系,类似于“句子重排序”。RoBERTa为改进版BERT,主要从训练数据、模型规模和算力等方面进行了改进。XLNet吸收了自编码语言模型的优点,能解决由掩盖策略引起的预训练和微调不一致等问题。ALBERT引入了词嵌入参数因式分解技术,在性能损失较小的前提下,可大幅度压缩参数数量。ELECTRA引入了生成对抗网络的对抗训练思想,对输入文本进行随机掩蔽,使用生成器模型计算新的序列,并将该序列作为判别器模型的输入,进而可判断句子中哪些单词曾被替换。

基于Decoder的模型以GPT为代表,因此也可称之为“GPT系列”方法,主要包括GPT1[3]、GPT2[4]、GPT3[5]、InstructGPT/ChatGPT[6]、GPT4[7]等。2018年提出的GPT1不再需要提取模型中的词向量,仅需直接在下游微调已完成预训练的模型,即面对不同的任务时采用不同的输入或输出层。而GPT1的优化方向则是扩大训练集数量和增加模型参数。InstructGPT使用指示学习[30]和人工反馈的强化学习[31]指导模型训练。InstructGPT基本沿用了GPT3结构,由人工训练了1年,并且参数个数为13亿的InstructGPT的输出效果优于参数个数为1 750亿的GPT3。ChatGPT在InstructGPT基础上优化了收集标注数据的方法,GPT4则进一步支持多模态数据。基于Decoder的模型除GPT系列之外,还包括其他模型,如通路语言模型(pathways language model, PaLM)[32]、LLaMA[33]等。

1.4 中文大语言模型大语言模型领域正蓬勃发展,中国也在加速追赶和引领大语言模型研究,并取得诸多突破。2021年3月,超大规模智能模型“悟道1.0”发布。其中,“悟道·文源”是以中文为核心构建的预训练语言模型,模型参数个数达26亿。“悟道·文汇”为面向认知的超大规模预训练模型,模型参数个数达113亿。2021年6月,超大规模智能模型“悟道2.0”发布,参数个数达1.75万亿。随着GPT系列产品不断发布,大语言模型领域的研究热度逐渐上升。在此背景下,国内的科技企业纷纷布局大模型研究,如“盘古”系列大模型、“文心一言”大模型、“通义千问”大模型等。

1.5 大语言模型的发展趋势纵观大语言模型的发展历程,其未来研究逐渐呈现以下趋势:1) 多模态化。大语言模型由最初的语言模型逐渐向融合文本、语音、视频和图片等多种类型数据的复杂模型方向发展,因而也表现出更高级别的智能。2) 模型规模逐渐“理性化”。大语言模型由最初的快速增加模型规模以提高模型性能,逐渐转向兼顾模型规模和经济成本。3) 关注方向逐渐由模型研究转向模型应用。大语言模型由一定阶段的基础模型研究逐渐转向模型生态发展,并积极拓展大语言模型在政务领域等场景的应用。

2 大语言模型在政务领域的应用大数据时代,提升政府治理效能是政府核心任务之一。随着政务数据持续增长,传统的依赖专家经验及领域特征的统计语言模型逐渐逊色。大语言模型以其所具有的灵活性高、表达能力强和效果好等优点,在政务服务领域得到广泛应用,并推动了政务领域智能化水平快速提升。

使用检索式在中国知网(China National Knowledge Infrastructure,CNKI)网站中检索,获得了语言模型在不同政务领域的研究文献。以下为本文使用的检索式:(主题=语言模型) AND (主题=(政务文本分类) OR (主题=政府文本分类) OR (主题=政府公文分类) OR (主题=政务公文分类) OR (主题=政府文件分类) OR (主题=政务文件分类))、(主题=语言模型) AND (主题=(政务问答) OR (主题=政府问答) OR (主题=政务对话) OR (主题=政府对话))、(主题=语言模型) AND (主题=(政务命名实体识别) OR (主题=政府命名实体识别) OR (主题=政务实体识别) OR (主题=政府实体识别))、(主题=语言模型) AND (主题=(舆情风险识别) OR (主题=舆情风险发现) OR (主题=舆情风险提示) OR (主题=舆情风险识别) OR (主题=舆情风险发现) OR (主题=舆情风险提示))、(主题=语言模型) AND (主题=(政务关系抽取) OR (主题=政府关系抽取) OR (主题=政务关系挖掘) OR (主题=政府关系挖掘) OR (主题=政务关系发现) OR (主题=政府关系发现))。可以看出,截至2023年6月12日,语言模型在政务文本分类、政务问答、政务命名实体识别、舆情风险识别、政务关系抽取的文献数量分别为529、411、278、92、25。下一步本文将详细综述语言模型在各类政务领域的应用研究进展,以期为语言模型进一步推动政务领域智能化水平提升指明方向。

2.1 政务文本分类对政务文本如政府公文、政务平台留言进行分类,既能提高政务工作效率、辅助决策,也能帮助政府了解民意、汇聚民智、凝聚民气。随着各类政务文本数量不断增加,建立基于大语言模型的政务文本分类方法成为普遍需求。陈钢[34]首先使用RoBERTa模型提取政务热线工单文本中的特征向量,其次分别使用CNN和双向门控循环单元(bidirectional gating recurrent unit,BiGRU)提取特征向量的局部特征和全局特征,并使用自注意力机制处理BiGRU提取的全局特征以凸显重要性高的语义特征,最后融合CNN提取的局部特征和自注意力机制处理后的全局特征进行工单分类,取得了良好的工单分类效果。朱娜娜等[35]使用多层Transformer编码器获取政策文本的特征,实现了政策文本分类。施国良等[36]对比了多种BERT系列模型与文本增强技术结合的网络问政留言分类效果,并探究其差异原因,发现基于RoBERTa与SimBERT文本增强的网络问政留言分类效果最佳。文[36]的研究还证明,基于RoBERTa与SimBERT文本增强的模型能够有效提升多类别文本的分类效果,有望指导并解决同类问题。卢小宾等[37]提出了一套政府开放公文自动化主题分类方法。该方法以CNN-LSTM模型为基础,融合BERT提取的语义特征,对主题分类的整体准确度为63.52%,为解决政务公文主题分类标注缺失问题提供了可行方案。

2.2 政务问答大语言模型最初基于文本翻译、问答等场景而设计,因而其在政务问答领域具有极佳的应用优势。华斌等[38]设计了一种关联政策智能问答方法,该方法的设计过程如下:首先,建立知识模型,使用政策文本表达政策知识;其次,引入疑问词注意力机制,结合改进的ERNIE+CNN模型对政策问题进行分类;再次,使用IDCNN(iterated dilated CNN)+条件随机场(conditional random field,CRF)模型与认知计算方法获取问题的语义和语用层面知识;最后,使用知识聚合技术生成关联答案,采用BERT语义相似度计算与知识单元计量方法对答案进行双重质量评价。文[38]的方法可以获得不同政策问题的答案,具有较好的知识检验结果。

2.3 政务命名实体识别政务文本中,批量、自动识别命名实体是分析和管理政务实体系统的基础。因此,研究政务命名实体识别具有重要意义。杨春明等[39]构建了包含25 176个句子的政务领域命名实体识别数据集,先使用BERT预训练模型提取词的特征向量,再采用BiLSTM进行语义编码,最后采用CRF识别实体。实验结果表明,该研究方法的识别效果优于CRF、BiLSTM-CRF、CNN-BiLSTM-CRF,F1值(F1-score)达92.23%。徐绪堪等[40]以从上海市“互联网+政务”网络平台爬取的29 074条群众留言为研究对象,对比了BERT、LSTM、FastText这3个模型的分类效果。该研究首先基于增量训练后的BERT模型构建群众留言热点追踪框架;其次使用Affinity Propagation聚类算法对群众留言聚类、使用BERT对群众留言进行命名实体识别,并根据命名实体筛选聚类结果;最后通过计算热度得出群众反馈的热点问题。

2.4 舆情风险识别随着政务信息化建设的快速推进以及信息获取方式多样化,舆情风险识别的必要性愈发凸显。在此背景下,将大语言模型应用于舆情风险识别不仅能够提前防范和化解舆情风险、提升政府形象,还能拓展大语言模型的应用场景,推动大语言模型在政务领域的繁荣发展。曾慧玲等[41]在BERT基础上引入提示学习的思想,设计了新闻舆情风险提示模型。该模型将预测标签映射至已有风险标签,从而实现新闻舆情风险提示。该模型的实验结果表明,采用提示学习思想的训练方法优于采用微调思想的训练方法,这也是提示学习思想在政务领域的新应用。

2.5 政务关系抽取建立政务领域不同实体之间的关系,对发掘潜在政务实体关联、建立政务领域知识库具有重要意义。因此,大语言模型成为政务关系抽取自动化的更好选择。如,适用于自然语言理解任务的“BERT系列”模型能为政务关系抽取提供更深层次的推理支持。崔从敏等[42]提出了一种结合ALBERT模型和胶囊网络的政府公文“人名-职务”关系抽取方法。其中,ALBERT负责提取政府公文的深层语义信息,胶囊网络负责通过传输低层到高层的特征提高关系分类效果。研究结果表明,模型的准确率、召回率、F1值均高于基线方法,能够有效解决政府公文领域标注数据集较少的问题。

综上所述,政务领域的大语言模型应用研究主要以规模较小的模型为主,缺乏大型模型的应用实例。相比于规模较小的模型,大型模型具有诸多优点,包括高效性、应用场景更丰富、使用更便利等。对高效性而言,大型模型通常由大量且异构的数据训练而来,因而具有更好的性能;对应用场景而言,大型模型逐渐支持多模态数据,因而应用场景更丰富;对使用便利性而言,大型模型普遍采用的“预训练+微调”研发模式和接口调用方式,使研发和实际应用更便利。

3 政务大语言模型需解决的问题大语言模型在政务领域应用呈现以下特点:1) 以直接应用或升级改造现有较成熟的大语言模型为主。2) 以处理政务文本为主要应用场景。3) 以辅助使用或分析现有数据为主,缺乏直接支持政府决策的能力。未来,政务大语言模型的研究需要解决数据多模态化、正确面对“模型即服务”的趋势、满足数据高安全性要求、明确责任边界。

3.1 丰富多模态数据多模态大语言模型逐渐成为主流的发展趋势。GPT4[7]、KOSMOS-1[43]等国外产品与“文心一言”“通义千问”等国内产品均支持多模态数据。政务领域数据除文本类型数据外,还包括视频、图片和语音等多种其他类型数据。目前,大语言模型在政务领域的应用主要以政务文本分类、政务命名实体识别和舆情风险识别等政务文本相关的应用场景为主。未来,政务大语言模型需要在视频、图片和语音等类型数据相关应用场景开展深入研究和应用。需要指出的是,政务数据普遍具有较高的质量要求和相对规范的数据格式,因而多模态数据集及多模态政务大语言模型的构建也具备更坚实的基础。

3.2 正确面对“模型即服务”趋势大语言模型具有所需训练数据多、训练周期长、训练成本高的特点。如,GPT3的训练数据增加至45 TB,模型参数个数达1 750亿,预估训练一次的成本高达1 200万美元。随着大语言模型对数据、算力和成本的要求越来越高,该领域逐渐形成“模型即服务”(model as a service,MaaS)的商业模式,即先由科技巨头构建具备通识能力的基础模型,再由细分领域公司将基础模型转变为该领域的专业模型。实现MaaS的常见形式是科技巨头对外开放基础模型的服务接口,满足细分领域公司的需求,将模型转变为真正满足行业需求的应用。从MaaS的原理可以看出,若政务大语言模型采用MaaS模式,则难以避免受限于创造基础模型的上游科技巨头,由此带来管理、业务和技术等方面的一系列问题。因此,政务大语言模型需要正确面对MaaS模式发展的趋势。

3.3 满足数据高安全性要求政务数据一般具有涉及公民隐私、国家机密等特点,这要求政务数据必须具有完善的高安全性,因而构建和使用政务大语言模型的过程必须要考虑安全性问题。如新加坡政府与OpenAI联合开发类似ChatGPT的“Pair”系统,用于政务公文辅助写作,并与OpenAI达成了保密协议,保证数据安全[44]。鉴于政务数据的高安全性要求,政务数据在供不同群体使用时也应具有不同的要求。以政务数据向社会开放为例,细分为全部可对社会开放、不可对社会开放、部分可对社会开放3种类型。即便是政务部门间的数据共享,也划分为有条件共享、无条件共享、不予共享3种类型。政务大语言模型在数据收集和处理、模型训练和使用等阶段都需要严格落实高安全性要求。需要特别指出的是,大语言模型目前存在生成内容不可控等问题,可以通过过滤训练数据、审核生成内容等方式使大语言模型满足高安全性要求。

3.4 明确责任边界在政府治理中,政府往往以人类为主体做出相应决策,并需要对该决策负责。然而,当大语言模型应用至政务领域时,做出的决策可能会出现责任难以界定的情况[45]。首先,大语言模型的输出不可预测,导致政务部门较难根据大语言模型的输出做出合理决策。其次,大语言模型基于现有数据训练,本质上是学习已有知识并基于已有知识进行推理,对政务领域中常见突发情况处置、未来趋势预判等业务场景难以作出理性判断。最后,政府决策的依据是“公共利益最大化”,大语言模型代表机器意志,其能否体现行政主体意志尚待验证。《生成式人工智能服务管理暂行办法》[13]指出,“基于服务类型特点,采取有效措施,提升生成式人工智能服务的透明度,提高生成内容的准确性和可靠性”。在大语言模型的实际使用中,需要明确责任边界,合理界定大语言模型所做决策与人为决策的符合度,正确区分机器意志、人类意志和公共意志,尽最大努力使大语言模型能够做出符合公共意志的决策。

4 结论语言模型经历了统计语言模型和神经网络语言模型2个阶段的积累和发展,正处于大语言模型时代。基于Transformer模型的大语言模型在训练语料的丰富度、模型的复杂度等方面均不断取得新的里程碑。此外,Transformer模型演化出适用自然语言理解任务的“BERT系列”模型和适用自然语言生成任务的“GPT系列”模型。实际上,由于Transformer模型的结构新颖、效果好,自然影响力大,因此每种模型因不同的工作原理和适用场景而产生较多变种。如BERT模型有RoBERTa、ALBERT等变种。这也在一定程度上丰富了NLP生态。大语言模型在政务文本分类、政务关系抽取、舆情风险识别和政务领域命名实体识别等方面取得了良好的应用效果。

政务大语言模型研究的技术路线值得关注。从当前基础研究和行业发展情况看,有2种技术路线可供参考。一种是微调通用大模型,使模型输出更符合政务领域文本范式,避免输出无意义文本、不符合政务领域规定文本等。另一种是收集政务语料,重新训练政务大模型,该过程涉及政务语料构建和基线模型搭建。不管采用哪种技术路线,政务服务模式都面临从“信息即服务”到“平台即服务”再到MaaS的转变。

大语言模型引发的问题同样值得关注,其带来的科技伦理问题已经在一定范围内引发恐慌。如ChatGPT引发了诸多争议,包括生成文件的新颖性、使用ChatGPT带来的潜在抄袭风险,以及生成文件产权等。正因如此,ChatGPT已被许多互联网公司、高校、学术期刊等机构或组织禁用。政务领域因其特殊性,对模型的安全性、可靠性和稳定性等提出更高要求,因而大语言模型在政务领域的应用将面临更大挑战。这也表明,大语言模型带来的弊端应受到足够重视。未来,大语言模型的发展还需要考虑模型规模与经济成本间的平衡、科技伦理等问题,不断提高模型的性能和可用性。同时,大语言模型在政务领域的应用场景也将不断丰富,应用范围也将不断扩大,这也将为大语言模型的迭代更新提供更多思路。

| [1] |

LIN T Y, WANG Y X, LIU X Y, et al. A survey of transformers[J]. AI Open, 2022, 3: 111-132. DOI:10.1016/j.aiopen.2022.10.001 |

| [2] |

TAY Y, DEHGHANI M, BAHRI D, et al. Efficient transformers: A survey[J]. ACM Computing Surveys, 2022, 55(6): 109. |

| [3] |

RADFORD A, NARASIMHAN K, SALIMANS T, et al. Improving language understanding by generative pre-training[J/OL]. Openai. (2023-01-06)[2023-06-12]. https://www.semanticscholar.org/paper/Improving-Language-Understanding-by-Generative-Radford-Narasimhan/cd18800a0fe0b668a1cc19f2ec95b5003d0a5035.

|

| [4] |

RADFORD A, WU J, CHILD R, et al. Language models are unsupervised multitask learners[J/OL]. Openai. (2019-02-14)[2023-06-12]. https://paperswithcode.com/paper/language-models-are-unsupervised-multitask.

|

| [5] |

BROWN T B, MANN B, RYDER N, et al. Language models are few-shot learners[C]//Proceedings of the 34th International Conference on Neural Information Processing Systems. Vancouver, Canada: ACM, 2020: 1877-1901.

|

| [6] |

LONG O Y, WU J, SLAMA K, et al. Training language models to follow instructions with human feedback[J/OL]. Computation and Language. (2022-03-04)[2023-06-12]. https://arxiv.org/abs/2203.02155.

|

| [7] |

Openai. GPT-4 technical report[R/OL]. (2023-03-27)[2023-06-12]. https://arxiv.org/abs/2303.08774.2023.

|

| [8] |

国务院. 国务院关于积极推进"互联网+"行动的指导意见[EB/OL]. (2015-07-04)[2023-06-12]. http://www.gov.cn/zhengce/content/2015-07/04/content_10002.htm. The State Council. Guiding opinions of the State Council on actively promoting the "Internet Plus" action[EB/OL]. (2015-07-04)[2023-06-12]. http://www.gov.cn/zhengce/content/2015-07/04/content_10002.htm. (in Chinese) |

| [9] |

国务院. 国务院关于印发新一代人工智能发展规划的通知[EB/OL]. (2017-07-20)[2023-06-12]. http://www.gov.cn/zhengce/content/2017-07/20/content_5211996.htm. The State Council. Circular of the State Council on printing and issuing the plan for development of the new generation of artificial intelligence[EB/OL]. (2017-07-20)[2023-06-12]. http://www.gov.cn/zhengce/content/2017-07/20/content_5211996.htm. (in Chinese) |

| [10] |

中国国家标准化管理委员会, 中央网信办, 国家发展改革委, 等. 国家标准化管理委员会中央网信办国家发展改革委科技部工业和信息化部关于印发《国家新一代人工智能标准体系建设指南》的通知[EB/OL]. (2020-07-27)[2023-06-12]. http://www.gov.cn/zhengce/zhengceku/2020-08/09/content_5533454.htm. Standardization Administration of the People's Republic of China, Office of the Central Cyberspace Affairs Commission, National Development and Reform Commission, et al. Standardization Administration, Office of the Central Cyberspace Affairs Commission, National Development and Reform Commission, Ministry of Science and Technology of the People's Republic of China, Ministry of Industry and Information Technology of the People's Republic of China notice on issuing the "Guidelines for the construction of the national new generation artificial intelligence standards system"[EB/OL]. (2020-07-27)[2023-06-12]. http://www.gov.cn/zhengce/zhengceku/2020-08/09/content_5533454.htm. (in Chinese) |

| [11] |

中华人民共和国国民经济和社会发展第十四个五年规划和2035年远景目标纲要[EB/OL]. (2021-03-13)[2023-06-12]. http://www.gov.cn/xinwen/2021-03/13/content_5592681.htm. The outline of the 14th Five-Year Plan (2021—2025) for national economic and social development of the People's Republic of China and the long-range objectives through the year 2035[EB/OL]. (2021-03-13)[2023-06-12]. http://www.gov.cn/xinwen/2021-03/13/content_5592681.htm. (in Chinese) |

| [12] |

国务院. 国务院关于印发"十四五"数字经济发展规划的通知[EB/OL]. (2022-01-12)[2023-06-12]. http://www.gov.cn/zhengce/content/2022-01/12/content_5667817.htm. The State Council. Circular of the State Council on printing and issuing the development plan for digital economy during the 14th Five-Year Plan period[EB/OL]. (2022-01-12)[2023-06-12]. http://www.gov.cn/zhengce/content/2022-01/12/content_5667817.htm. (in Chinese) |

| [13] |

国家互联网信息办公室, 中华人民共和国国家发展和改革委员会, 中华人民共和国教育部, 等. 生成式人工智能服务管理暂行办法[EB/OL]. (2023-07-13)[2023-07-25]. http://www.cac.gov.cn/2023-07/13/c_1690898327029107.htm. Cyberspace Administration of China, National Development and Reform Commission, Ministry of Education of the People's Republic of China, et al. Interim measures for administration of generative artificial intelligence services[EB/OL]. (2023-07-13)[2023-07-25]. http://www.cac.gov.cn/2023-07/13/c_1690898327029107.htm. (in Chinese) |

| [14] |

BENGIO Y, DUCHARME R, VINCENT P, et al. A neural probabilistic language model[J]. The Journal of Machine Learning Research, 2003, 3: 1137-1155. |

| [15] |

MIKOLOV T, KARAFIÁT M, BURGET L, et al. Recurrent neural network based language model[C]//11th Annual Conference of the International Speech Communication Association. Makuhari, Japan: International Conference on Spoken Language Processing 2010, 2010: 1045-1048.

|

| [16] |

MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems. Sydney, Australia: ACM, 2013: 3111-3119.

|

| [17] |

MIKOLOV T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in vector space[J/OL]. Computer Science. (2013-01-16)[2023-06-12]. https://arxiv.org/abs/1301.3781.

|

| [18] |

PENNINGTON J, SOCHER R, MANNING C D. GloVe: Global vectors for word representation[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP). Doha, Qatar: Association for Computational Linguistics, 2014: 1532-1543.

|

| [19] |

PETERS M E, NEUMANN M, IYYER M, et al. Deep contextualized word representations[C]//Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. New Orleans, USA: Association for Computational Linguistics, 2018: 2227-2237.

|

| [20] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Proceedings of the 31st Conference on Neural Information Processing Systems (NIPS 2017). Long Beach, USA: ACM, 2017: 6000-6010.

|

| [21] |

LEWIS M, LIU Y H, GOYAL N, et al. BART: Denoising sequence-to-sequence pre-training for natural language generation, translation, and comprehension[J/OL]. arXiv. (2019-10-29)[2023-06-12]. https://arxiv.org/abs/1910.13461.

|

| [22] |

RAFFEL C, SHAZEER N, ROBERTS A, et al. Exploring the limits of transfer learning with a unified text-to-text transformer[J]. The Journal of Machine Learning Research, 2020, 21(1): 140. |

| [23] |

DEVLIN J, CHANG M W, LEE K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Minneapolis, USA: Association for Computational Linguistics, 2018: 4171-4186.

|

| [24] |

LIU Y H, OTT M, GOYAL N, et al. RoBERTa: A robustly optimized BERT pretraining approach[J/OL]. arXiv. (2019-07-26)[2023-06-12]. https://arxiv.org/abs/1907.11692.

|

| [25] |

YANG Z L, DAI Z H, YANG Y M, et al. XLNet: Generalized autoregressive pretraining for language understanding[C]//Proceedings of the 33rd International Conference on Neural Information Processing Systems (NeurIPS 2019). Vancouver, Canada: ACM, 2019: 5753-5763.

|

| [26] |

ZHANG Z Y, HAN X, LIU Z Y, et al. ERNIE: Enhanced language representation with informative entities[C]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence, Italy: Association for Computational Linguistics, 2019: 1441-1451.

|

| [27] |

CONNEAU A, LAMPLE G. Cross-lingual language model pretraining[C]//Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver, Canada: ACM, 2019: 7056-7069.

|

| [28] |

LAN Z Z, CHEN M D, GOODMAN S, et al. ALBERT: A lite BERT for self-supervised learning of language representations[J/OL]. arXiv. (2019-09-26)[2023-06-12]. https://arxiv.org/abs/1909.11942.

|

| [29] |

CLARK K, LUONG M T, LE Q V, et al. ELECTRA: Pre-training text encoders as discriminators rather than generators[J/OL]. arXiv. (2020-03-23)[2023-06-12]. https://arxiv.org/abs/2003.10555v1.

|

| [30] |

WEI J, MAARTEN B, ZHAO V Y, et al. Finetuned language models are zero-shot learners[J/OL]. arXiv. (2021-09-03)[2023-06-12]. https://arxiv.org/abs/2109.01652.

|

| [31] |

CHRISTIANO P F, LEIKE J, BROWN T B, et al. Deep reinforcement learning from human preferences[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach, USA: ACM, 2017: 4302-4310.

|

| [32] |

CHOWDHERY A, NARANG S, DEVLIN J, et al. PaLM: Scaling language modeling with pathways[J/OL]. arXiv. (2022-04-05)[2023-06-12]. https://arxiv.org/abs/2204.02311.

|

| [33] |

TOUVRON H, LAVRIL T, IZACARD G, et al. LLaMA: Open and efficient foundation language models [J/OL]. arXiv. (2023-02-27)[2023-06-12]. https://arxiv.org/abs/2302.13971.

|

| [34] |

陈钢. 融合RoBERTa和特征提取的政务热线工单分类[J]. 计算机与现代化, 2022(6): 21-26, 31. CHEN G. Government hotline work-order classification fusing RoBERTa and feature extraction[J]. Computer and Modernization, 2022(6): 21-26, 31. (in Chinese) |

| [35] |

朱娜娜, 王航, 张家乐, 等. 基于预训练语言模型的政策识别研究[J]. 中文信息学报, 2022, 36(2): 104-110. ZHU N N, WANG H, ZHANG J L, et al. Policy identification based on pretrained language model[J]. Journal of Chinese Information Processing, 2022, 36(2): 104-110. (in Chinese) |

| [36] |

施国良, 陈宇奇. 文本增强与预训练语言模型在网络问政留言分类中的集成对比研究[J]. 图书情报工作, 2021, 65(13): 96-107. SHI G L, CHEN Y Q. A comparative study on the integration of text enhanced and pre-trained language models in the classification of internet political messages[J]. Library and Information Service, 2021, 65(13): 96-107. (in Chinese) |

| [37] |

卢小宾, 鲁国轩, 杨冠灿, 等. 政府网站开放公文主题分类自动标注方法[J]. 档案学通讯, 2022(5): 19-27. LU X B, LU G X, YANG G C, et al. Automatic annotation method for subject classification of policy texts on government official websites[J]. Archives Science Bulletin, 2022(5): 19-27. (in Chinese) |

| [38] |

华斌, 康月, 范林昊. 政策文本的知识建模与关联问答研究[J]. 数据分析与知识发现, 2022, 6(11): 79-92. HUA B, KANG Y, FAN L H. Knowledge modeling and association Q & A for policy texts[J]. Data Analysis and Knowledge Discovery, 2022, 6(11): 79-92. (in Chinese) |

| [39] |

杨春明, 魏成志, 张晖, 等. 基于BERT-BLSTM-CRF的政务领域命名实体识别方法[J]. 西南科技大学学报, 2020, 35(3): 86-91. YANG C M, WEI C Z, ZHANG H, et al. A method of named entity recognition in government affairs based on BERT-BLSTM-CRF[J]. Journal of Southwest University of Science and Technology, 2020, 35(3): 86-91. (in Chinese) |

| [40] |

徐绪堪, 印家伟, 王晓娇. 基于BERT模型的"互联网+政务"群众留言文本热点追踪研究[J]. 情报杂志, 2022, 41(9): 136-142, 78. XU X K, YIN J W, WANG X J. Research on Hotspot tracking of "Internet + Government Affairs" mass message text based on BERT model[J]. Journal of Intelligence, 2022, 41(9): 136-142, 78. (in Chinese) |

| [41] |

曾慧玲, 李琳, 吕思洋, 等. 提示学习驱动的新闻舆情风险识别方法研究[J/OL]. 计算机工程与应用. (2022-11-30)[2023-06-12]. http://kns.cnki.net/kcms/detail/11.2127.TP.20221129.1143.002.html. ZENG H L, LI L, LÜ S Y, et al. A risk identificaiton method for news public opinion driven by prompt learning[J/OL]. Computer Engineering and Applications. (2022-11-30)[2023-06-12]. http://kns.cnki.net/kcms/detail/11.2127.TP.20221129.1143.002.html. (in Chinese) |

| [42] |

崔从敏, 施运梅, 袁博, 等. 面向政府公文的关系抽取方法研究[J]. 计算机技术与发展, 2021, 31(12): 26-32. CUI C M, SHI Y M, YUAN B, et al. Research on relation extraction method for government documents[J]. Computer Technology and Development, 2021, 31(12): 26-32. (in Chinese) |

| [43] |

HUANG S H, DONG L, WANG W H, et al. Language is not all you need: Aligning perception with language models[J/OL]. arXiv. (2023-02-27)[2023-06-12]. https://arxiv.org/abs/2302.14045.

|

| [44] |

界面快报. 新加坡政府开发ChatGPT类似系统, 助公务员写报告[N/OL]. (2023-02-28)[2023-06-12]. https://www.jiemian.com/article/8982146.html. Interface Quick Report. The Singapore government has developed a ChatGPT similar system to assist civil servants in writing reports[N/OL]. (2023-02-28)[2023-06-12]. https://www.jiemian.com/article/8982146.html. (in Chinese) |

| [45] |

陈潭, 刘璇. 智能政务ChatGPT化的前景与隐忧[J]. 电子政务, 2023(4): 36-44. CHEN T, LIU X. The prospects and hidden worries of ChatGPT in intelligent government[J]. E-Government, 2023(4): 36-44. (in Chinese) |