2. 长江设计集团有限公司, 武汉 430010;

3. 武汉大学 水资源工程与调度全国重点实验室, 武汉 430072;

4. 湖北工业大学 土木建筑与环境学院, 武汉 430068

2. CISPDR Corporation, Wuhan 430010, China;

3. State Key Laboratory of Water Resources Engineering and Management, Wuhan University, Wuhan 430072, China;

4. School of Civil Engineering Architecture and Environment, Hubei University of Technology, Wuhan 430068, China

大型建筑工程的施工监测是分析施工效率、合理匹配资源以及支持精细化管理的基础。在混凝土拱坝浇筑过程中,缆机是主要的混凝土吊运入仓设备,监测其吊运过程对分析混凝土浇筑效率、合理规划缆机调度以及现场指导施工至关重要,直接关系到大坝建设的进度、成本和质量[1-3]。然而,大坝工程一般位于高山峡谷中,规模庞大、施工工序复杂、空间交叉作业繁多[4],这为缆机吊运活动的监测带来了极大挑战。因此,研发可靠有效的监测技术,掌握缆机实际运行状态和效率,一直是本领域的关键技术难题。

传统方法依靠人工跟踪缆机吊运过程,判断吊运状态和估计缆机运行效率,主观性强,精度低。随着机器视觉、互联网以及人工智能等信息技术的快速发展,应用新型感知技术实现对缆机吊运过程的自动精确监测是当前及未来的研究热点。现有缆机吊运过程的监测技术主要有全球导航卫星系统(global navigation satellite system,GNSS)、行程编码器和加速度等传感器、视觉跟踪等[5]。其中基于GNSS的监测方法是通过定位缆机吊罐的位置捕捉其移动轨迹[6, 7]。但大坝地处高山峡谷,GNSS信号不稳定、定位精度较低,无法完整、精确地获取轨迹数据。基于行程编码器和加速度等传感器的方法是在缆机的缆索和吊罐上布设感知器的接触式监测方法[5, 8],但易受施工机械振动干扰,且在缆索检修后需要重新率定,维护成本高。除此之外,上述非视觉监测方法都不能直观地确定缆机吊运施工机械、吊运混凝土或者停工等工作状态,需要使用复杂的识别方法进行间接判断。

视觉跟踪技术作为一种非接触的监测方法,能够直接识别缆机工作状态,避免上述问题[9-11]。传统的视觉跟踪方法需要人为设计目标特征,难以适应复杂的施工场景。近年来,融合了深度学习的视觉跟踪方法可以自主学习目标特征,有效改善了上述不利影响,具有较高的跟踪准确性且对复杂场景具有更强的鲁棒性,在视频监控、城市交通、自动驾驶、人机交互等众多领域得到广泛应用[12, 13]。因此,基于深度学习的视觉跟踪方法是解决大规模、复杂施工场景下施工机械的高效精准监测难题的最有潜力的手段。应用视觉跟踪技术监测缆机吊运混凝土效率是通过多目标跟踪技术追踪缆机吊罐的运输过程,提取其移动轨迹,分析缆机吊运效率指标[5],但在复杂的大坝施工场景中应用多目标视觉跟踪技术,需要解决以下关键问题:1) 大坝施工中一般采用统一型号的缆机吊罐,它们形状相同、颜色类似、外观相近,当2个吊罐发生相互遮挡而竞争同一个检测框时,现有多目标追踪算法仅依靠外观信息难以有效区分,导致吊罐移动轨迹与检测框匹配存在很大随机性,容易出现数据关联错误[14, 15];2) 大坝施工中缆机数量是已知且固定不变的,缆机吊运过程中,吊罐常被其他建筑物暂时遮挡而后重现,需要进行长时监测以保证轨迹的完整性,而现有多目标追踪算法(如DeepSORT算法)多是针对行人、车辆等短时监控目标设计的,当目标较长时间失踪,其历史轨迹会被删除,导致目标重现之后的ID跳变问题[16-18];3) 大坝施工场景庞大且背景繁杂,一般缆机跨度可达1 km,吊深300 m左右,而缆机吊罐仅有3~4 m高,直径不足2 m。这样的场景中还存在移动的车辆、推土机、吊车等动态目标,以及浇筑仓模板、坝肩开挖面、交通洞等静态目标,即使采用高分辨率的视频,也难免出现误检和漏检的情况。

本研究提出一种基于视觉跟踪和模式识别的缆机吊运混凝土施工效率智能分析方法,通过引入轨迹片段特征改进DeepSORT算法,增加重匹配机制,解决目标外观相似、遮挡以及误检漏检等问题,实现对缆机吊运全过程的多目标视觉跟踪,并完整精准地提取缆机吊罐的移动轨迹;然后分析轨迹数据的时序特征,基于模式识别方法建立缆机吊运混凝土工作状态识别模型,实现从海量轨迹数据中快速精准地识别缆机吊运状态,并统计分析缆机的吊运效率指标。本研究旨在为现场施工管理和决策提供技术支持。

1 研究框架基于视觉跟踪和模式识别的缆机吊运混凝土效率智能分析方法的技术框架如图 1所示,主要包括以下部分:

|

| 图 1 研究框架 |

1) 数据采集。通过在坝肩合适位置架设相机设备,固定拍摄缆机群的吊运过程。要求相机视角能覆盖整个缆机群的完整吊运过程,包括在供料平台的装料、重载吊运、浇筑仓卸料以及空载返回。为提高后续目标识别精度,相机分辨率为384 0×216 0,帧率为每秒30帧;为保证数据多样性,视频从早上8点采集到下午6点,共采集3天,且每次视频拍摄时长应超过一个完整的吊运循环时长。

2) 基于深度学习的视觉跟踪。以采集到的缆机吊运视频序列为输入,采用YOLO(you only look once)模型对视频中的缆机吊罐进行识别;然后采用本文提出的改进DeepSORT算法对吊罐进行多目标跟踪,提取其移动轨迹;该改进的DeepSORT算法在依据外观特征和运动特征的级联匹配以及IOU(intersection over union)匹配的基础上增加了基于轨迹片段的重匹配机制,提高了数据关联的准确度和ID保持能力。

3) 基于模式识别的缆机吊运效率分析。分析吊罐运输轨迹的时序特征,建立缆机吊运混凝土工作状态识别模型,统计分析缆机的单次吊运循环时长,吊运循环次数,状态持续时长以及浇筑强度等关键施工效率指标。

2 基于视觉的缆机吊罐轨迹跟踪 2.1 吊罐的目标识别本文所采用的多目标跟踪方法遵循TBD(tracking-by-detection)范式是目前多目标跟踪领域常用的跟踪范式[19],它是一种基于目标检测的跟踪技术,其跟踪性能与目标检测器的性能密切相关。同时,考虑到本研究采集的视频分辨率较大,对检测速度要求较高,而YOLO模型是一阶段检测模型,在检测速度上明显优于其他模型,且能够保证较高的检测精度[20-22]。因此,本文选用YOLOv5模型作为目标检测器,以缆机吊运视频为输入,识别视频中的吊罐目标,输出目标识别框信息。

针对YOLOv5模型进行训练,从不同时段采集的吊运视频中提取了6 500张图像,每张图像中都包含多个吊罐,并且这些图像涵盖了不同的吊罐尺寸、光照条件、吊罐间相互遮挡以及被其他建筑物遮挡的情况、运动或静止状态、吊运混凝土或零件等条件,保证了数据多样性。模型的训练集和验证集依据8∶2进行划分。模型的参数设置为:初始学习率为0.01,动量为0.9,权重衰减为0.000 5,批量大小为16,训练回合数为300,每训练10个回合进行1个测试回合。

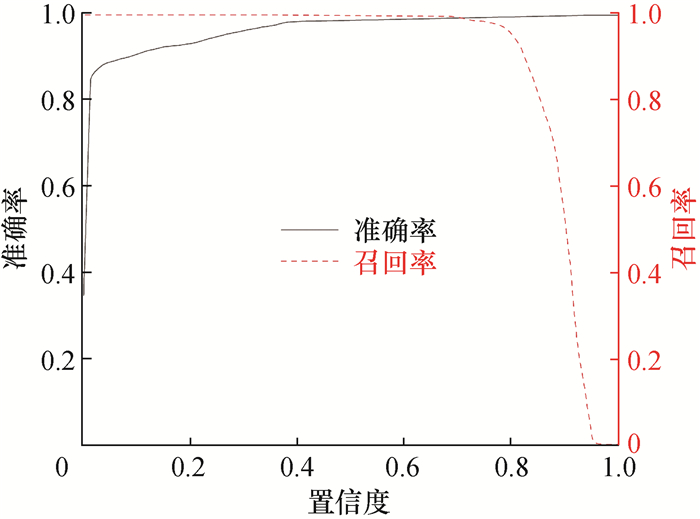

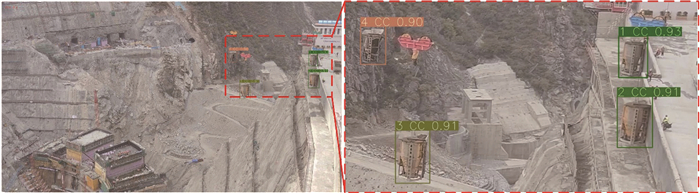

本研究的YOLOv5模型经过训练后,目标识别精度、召回率、F1分数(F1-score)、平均识别精度(mAP)和每秒帧数(FPS)分别为0.971、0.973、0.972、0.982和30.559。模型训练的准确率、召回率与置信度的关系如图 2所示,当置信度取0.6时,准确率和召回率高达0.9以上。采用该训练后的YOLOv5模型对缆机吊罐进行识别,结果如图 3所示,图中所有吊罐目标均被识别出来(局部放大区域中各吊罐上方的标签由“ID缆机标识符号置信度”组成)。因此,训练后的模型可实现对缆机吊罐的高精度快速检测,完全满足工程需要。

|

| 图 2 模型训练中准确率、召回率与置信度的关系 |

|

| 图 3 缆机吊罐的识别结果 |

2.2 缆机吊罐的多目标跟踪

基于视觉的多目标跟踪方法是从视频或图像序列中定位和跟踪多个目标,并维持各目标的身份信息。而常用的TBD范式是先通过目标检测算法识别出视频或图像序列中的目标物体,然后采用目标追踪算法依据外观、运动等特征信息实现检测框与轨迹的准确关联,输出所有目标的移动轨迹。

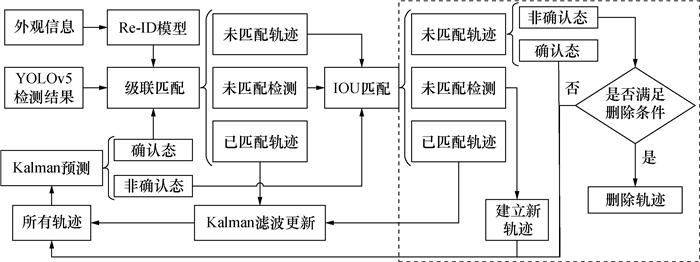

2.2.1 传统DeepSORT算法传统DeepSORT算法的数据关联框架如图 4所示,先基于运动特征和外观特征对确认态轨迹进行级联匹配,然后对非确认态轨迹进行IOU匹配[16, 23]。其中级联匹配是算法核心部分,采用Kalman滤波法预测目标的运动特征,并计算预测值和检测值之间的马氏距离,如式(1)所示,以实现运动特征匹配;采用Re-ID模型提取外观特征,引入余弦距离度量,如式(2)所示,衡量不同目标间外观差异,实现外观信息匹配;使用加权法综合马氏距离和余弦距离进行数据关联的最终度量,如式(3)所示。为提高数据关联的准确性,本文将对图中虚线框内的算法结构进行改进,详见2.2.2节。

| $ d^{(1)}(i, j)=\left(\boldsymbol{d}_j-\boldsymbol{y}_i\right)^{\mathrm{T}} \boldsymbol{S}_i^{-1}\left(\boldsymbol{d}_j-\boldsymbol{y}_i\right). $ | (1) |

|

| 图 4 传统DeepSORT算法的数据关联框架 |

其中:d(1)(i, j)为第j个检测框和第i个轨迹的预测框在运动特征上的马氏距离,dj是第j个检测框的位置信息,yi是应用Kalman滤波法对第i个轨迹位置信息的预测值,Si是轨迹的预测值与检测值之间的协方差矩阵。

| $ d^{(2)}(i, j)=\min \left\{1-\boldsymbol{r}_j^{\mathrm{T}} \boldsymbol{r}_k^{(i)} \mid \boldsymbol{r}_k^{(i)} \in \boldsymbol{R}_i\right\}. $ | (2) |

其中:d(2)(i, j)为第j个检测框和第i个轨迹在外观特征上的最小余弦距离,rj是第j个检测框对应目标的外观特征向量,Ri是第i个轨迹的外观特征向量库,rk(i)是在Ri中第k个外观特征向量。

| $ c_{i, j}=\lambda d^{(1)}(i, j)+(1-\lambda) d^{(2)}(i, j). $ | (3) |

其中:ci, j是对第j个检测框与第i个轨迹间关联程度的最终度量;λ是超参数,控制2种度量特征在级联匹配中的权重占比。

2.2.2 改进DeepSORT算法本文引入轨迹片段信息解决吊罐间的相互遮挡问题。轨迹片段是指视频序列中连续数帧同一目标的检测结果形成的一小段轨迹。在缆机吊运过程中,同一目标的运动特征在较短时间内几乎保持不变,不存在突变的情况。因此,吊罐发生相互遮挡时,同一目标的前后2段轨迹片段具有高度相似性,运动特征也非常相似。这说明根据轨迹片段信息可以有效解决外观相似目标的相互遮挡问题[24, 25]。

2个吊罐发生遮挡前后的轨迹变化如图 5a所示,Q1(蓝色线段)和Q2(绿色线段)为2个吊罐相互遮挡前的移动轨迹,Q3(红色线段)为遮挡中单检测框形成的一小段轨迹。可以明显看出Q3轨迹与Q1轨迹来源于同一吊罐的移动。因此在相互遮挡状况下根据轨迹片段的变化特征可以有效区分吊罐的ID。

|

| 图 5 吊罐间相互遮挡的轨迹和运动向量示意图 |

为描述轨迹片段的特征,本文引入了运动向量,其描述方法如图 5b所示。假设2个目标在第t帧发生相互遮挡,取遮挡前从第t-n帧至第t帧中2个目标形成的历史轨迹片段(Q1和Q2),分别计算相应的运动向量,记为αi(t-n, t)(i=1, 2),计算方法如式(4)所示。

| $ \left\{\begin{array}{l} \boldsymbol{\alpha}_i^{(t-n, t)}=\left(x_i^t-x_i^{t-n}, y_i^t-y_i^{t-n}\right), i=1, 2 ; \\ \boldsymbol{\alpha}_3^{(t+1, t+n+1)}=\left(x_3^{t+n+1}-x_3^{t+1}, y_3^{t+n+1}-y_3^{t+1}\right). \end{array}\right. $ | (4) |

其中:(xtt, yit)为轨迹Qi在第t帧中检测框的中心点坐标;n一般取值为5~10。

取遮挡发生后从第t+1帧至第t+n+1帧中单检测框形成的新轨迹片段(Q3),相应的运动向量为α3(t+1, t+n+1)。然后依据式(5)和(6)计算运动向量αi(t-n, t)与α3(t+1, t+n+1)之间的余弦相似度和欧氏距离。

| $ \begin{gathered} S_i=\frac{1}{2}+\frac{1}{2} \frac{\boldsymbol{\alpha}_i^{(t-n, t)} \cdot \boldsymbol{\alpha}_3^{(t+1, t+n+1)}}{\left\|\boldsymbol{\alpha}_i^{(t-n, t)}\right\|_2 \times\left\|\boldsymbol{\alpha}_3^{(t+1, t+n+1)}\right\|_2}, \\ i=1, 2. \end{gathered} $ | (5) |

其中Si为第i个轨迹的运动向量αi(t-n, t)与α3(t+1, t+n+1)之间的余弦相似度,取值范围为(0, 1)。Si的值越大,则运动向量间的余弦相似度越高,说明轨迹之间的运动方向越相近。

| $ \begin{gathered} d_i^{(3)}=\frac{1}{1+\left\|\boldsymbol{\alpha}_i^{(t-n, t)}-\boldsymbol{\alpha}_3^{(t+1, t+n+1)}\right\|_2} ; \\ i=1, 2 . \end{gathered} $ | (6) |

其中:‖αi(t-n, t)-α3(t+1, t+n+1)‖2为运动向量αi(t-n, t)与α3(t+1, t+n+1)之间的欧氏距离;di(3)是对欧式距离进行区间值变换后的结果,取值范围为(0, 1)。di(3)的值越大,则运动向量间的欧氏距离越小,说明轨迹之间的运动速度越相近。

依据式(7)综合考虑余弦相似度和欧氏距离选择Q3与Qi(i=1, 2)之间的最佳匹配。

| $ \max \left(\eta_i\right)=\max \left(S_i \times d_i^{(3)}\right), i=1, 2. $ | (7) |

其中ηi为衡量运动向量αi(t-n, t)与α3(t+1, t+n+1)之间相似程度的最终度量,该值越大,则相似程度越高。

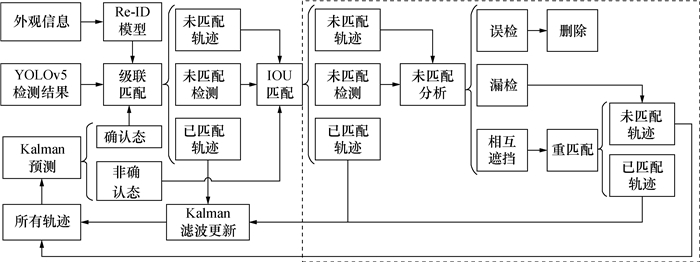

除了吊罐间的相互遮挡问题,还需要解决吊罐被其他建筑物遮挡、施工场景复杂等造成的漏检误检问题,本文在传统DeepSORT算法框架的基础上增加了基于轨迹片段特征的重匹配机制,建立了一种适用于目标数量预知的数据关联方法,如图 6所示。主要改进内容包括:

|

| 图 6 改进DeepSORT算法的数据关联框架 |

1) 未匹配原因分析。针对未匹配的检测框,如果在其一定阈值范围内不存在轨迹,则认为该检测框为误检,否则就是目标消失后又重现;针对未匹配的轨迹,将历史轨迹记录的最后一帧检测框与当前帧的所有检测框进行IOU匹配,如果所有匹配的IOU均为0,则认为该轨迹可能由于其他物体遮挡等原因造成漏检;如果存在检测框使IOU非零,且在该轨迹一定阈值范围内存在其他轨迹,则认为这2个轨迹之间存在相互遮挡。根据预实验,本研究中阈值范围取检测框的2倍有较好的匹配结果。

2) 基于轨迹片段特征的重匹配。针对目标相互遮挡的情况,依据式(4)—(7)计算ηi值,选择ηi值最大的匹配作为最终的数据关联结果。图 5a中Q1和Q3的关联就是采用该方法在相似外观目标发生相互遮挡情况下得到了正确的匹配结果。

3 基于模式识别的缆机吊运效率分析 3.1 缆机吊运混凝土模式识别应用视觉跟踪技术监测缆机吊运过程会产生海量轨迹数据,如何从中快速、准确识别缆机吊运混凝土的工作模式,是计算缆机吊运效率的关键。为此,分析了吊罐移动轨迹的时序特征,建立了缆机吊运混凝土模式识别模型。

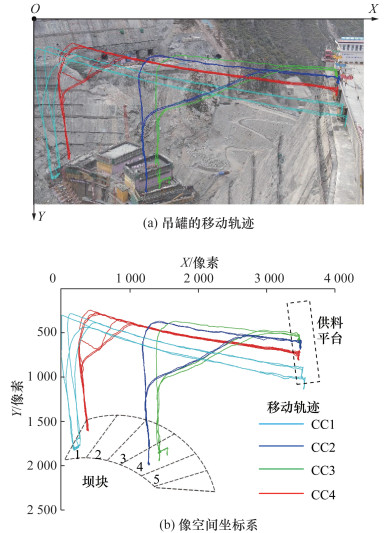

在混凝土坝施工过程中,缆机的工作模式包括3种,分别为:1) 吊运混凝土,2) 零星作业(吊运施工机械、钢筋、模板等物体),3) 停工与检修[8]。后2种模式下,吊罐一直被放置在供料平台上,位置坐标保持不变,所以只有在吊运混凝土模式下吊罐的位置坐标会随时间发生变化。因此,可以依据吊罐位置变化识别缆机吊运混凝土模式。图 7给出了应用上述视觉跟踪技术获取到的吊罐移动轨迹,采用4台缆机(CC1—CC4)同时浇筑坝块,其中CC1和CC4负责浇筑1号坝块,CC2和CC3负责浇筑4号坝块。缆机吊运混凝土的循环过程为:吊罐在供料平台装载混凝土,然后运输至目标坝块,卸载混凝土,再将空罐返回至供料平台,等待装载混凝土。重复该循环,直至目标坝块浇筑完成。进一步将吊罐的移动轨迹数据绘制到图像空间坐标系中,如图 7b所示,不同吊罐的移动轨迹采用不同颜色进行区分,可直观地记录缆机吊运混凝土过程中吊罐位置的变化。

|

| 图 7 缆机吊罐移动轨迹及其像空间坐标系 |

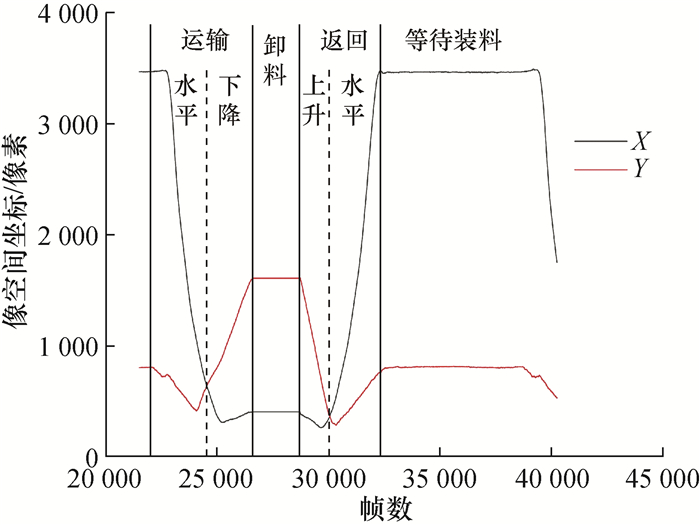

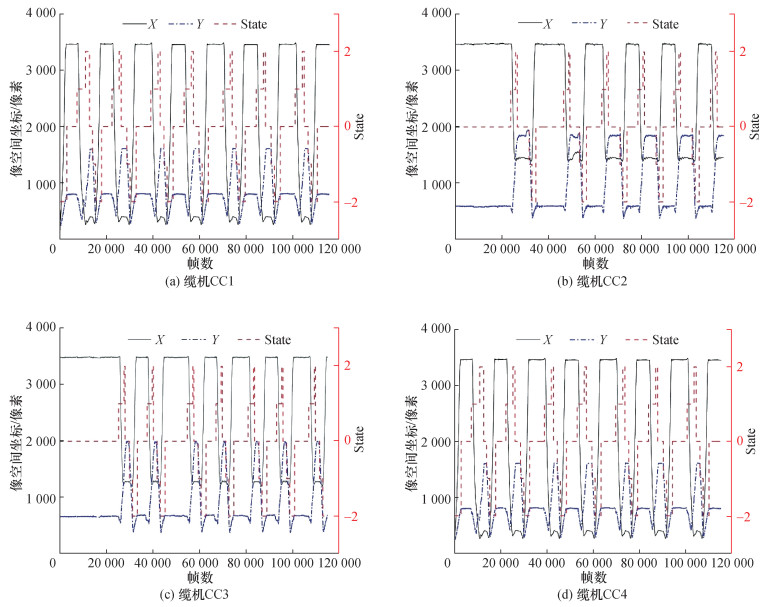

依据吊罐在图像空间坐标系中X和Y方向的位置随视频的时间帧数的变化情况绘制图 8,用以分析吊罐轨迹的时序特征。由图可知,与物理空间中缆机吊运混凝土过程相对应的,吊罐轨迹的时序特征也可明显分为运输、卸料、返回和等待装料4个工作状态,其中运输状态又可分为以水平或下降为主的运输过程,返回状态又可分为以上升或水平为主的返回过程。可见,吊罐轨迹的时序特征是从海量轨迹数据中识别缆机吊运混凝土模式和工作状态的可靠依据。

|

| 图 8 缆机吊运混凝土模式下轨迹的时序特征 |

3.2 吊罐轨迹数据的预处理

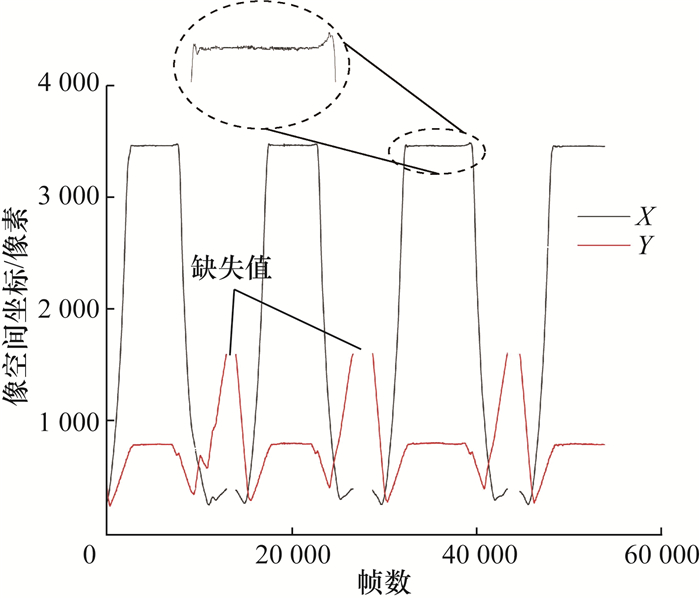

由于数据采集中存在吊罐被遮挡的情况,YOLO检测中可能存在漏检误检等问题,采用视觉跟踪方法获取的吊罐轨迹可能会在某些连续帧出现目标缺失。并且目标识别框的大小是不稳定、不连续的,即使同一目标在连续视频帧中也会存在抖动,对轨迹数据造成复杂的噪声干扰。因此采用视觉跟踪方法获取的轨迹是一种存在缺失值和噪声问题的时序数据,如图 9所示。为此,本文采用二阶B样条曲线插值方法,插补轨迹数据的缺失值。相对于线性插值、阶梯插值等方法,样条插值方法补充的时序数据较平滑[26, 27]。采用Savitzky-Golay滤波算法对轨迹数据进行降噪[28],如式(8)所示,对一定长度窗口内的数据点进行多项式拟合,可以确保轨迹数据的形状、宽度不变,不改变其变化特征。

| $ \hat{y}_j=\frac{\sum\limits_{i=-m}^m a_i x_{j+i}+a_0}{l}. $ | (8) |

|

| 图 9 吊罐轨迹数据的缺失和噪声问题 |

其中:

为从海量吊罐轨迹数据中快速识别缆机吊运混凝土循环,利用差分法计算不同吊运状态下轨迹的时序特征。将预处理后的轨迹数据间隔1秒(30帧)进行一阶差分,依据式(9)计算轨迹坐标对时间的变化率。

| $ \left\{\begin{array}{l} K_X=\frac{X_t-X_{t-\Delta t}}{\Delta t}, \\ K_Y=\frac{Y_t-Y_{t-\Delta t}}{\Delta t}. \end{array}\right. $ | (9) |

其中:KX、KY分别为X、Y坐标的变化率;(Xt,Yt)为轨迹在第t帧的位置坐标;Δt指间隔帧数,取30帧。

实际上,经过降噪处理后的轨迹数据仍存在一定的波动,根据对轨迹数据波动幅度的分析,设定当轨迹坐标一阶差分值(包括KX和KY)的绝对值小于0.1像素/s时,吊罐坐标保持不变,并对轨迹的时序变化状态(命名为State)赋值为0;当KX≤-0.1像素/s时,认为吊罐处于以水平运输为主的吊运状态,State赋值为1;当KY≥0.1像素/s时,认为吊罐处于以竖直下降为主的吊运状态,State赋值为2;当KY≤-0.1像素/s时,认为吊罐处于以竖直上升为主的返回状态,State赋值为-1;当KX≥0.1像素/s时,认为吊罐处于以水平返回为主的返程状态,State赋值为-2。表 1总结了缆机吊运混凝土的不同工作状态与轨迹坐标的时序特征的关系。由表可知,在吊运混凝土模式的一个单循环中,State值为0时对应的工作状态存在2个(卸料和等待装料)。所以仅凭轨迹坐标的时序特征无法准确判定缆机的工作状态。实际上,供料平台是缆机吊罐装载混凝土的固定位置,当缆机吊罐返回至供料平台区域即表明缆机处于等待装料状态(见图 7)。因此,依据缆机吊罐是否位于供料平台区域可以有效区分卸料和等待装料这2种工作状态。

| 工作状态 | KX/(像素·s-1) | KY/(像素·s-1) | State | ||

| 赋值 | 说明 | ||||

| 运输 | 水平 | ≤-0.1 | — | 1 | 水平运输为主 |

| 下降 | — | ≥0.1 | 2 | 竖直下降为主 | |

| 卸料 | (-0.1,0.1) | (-0.1,0.1) | 0 | 坐标不变 | |

| 返回 | 上升 | — | ≤-0.1 | -1 | 竖直上升为主 |

| 水平 | ≥0.1 | — | -2 | 水平返回为主 | |

| 等待装料 | (-0.1,0.1) | (-0.1,0.1) | 0 | 坐标不变 | |

缆机吊运混凝土的工作状态识别标准模板如表 2所示,包括水平运输、竖直下降、卸料、竖直上升、水平返回和等待装料6个状态,依次编号为SN1—SN6。

| 编号 | 是否在供料平台区域内 | State | |

| 赋值 | 说明 | ||

| SN1 | — | 1 | 吊罐以水平运输为主 |

| SN2 | — | 2 | 吊罐以竖直下降为主 |

| SN3 | 否 | 0 | 吊罐坐标不变 |

| SN4 | — | -1 | 吊罐以竖直上升为主 |

| SN5 | — | -2 | 吊罐以水平返回为主 |

| SN6 | 是 | 0 | 吊罐坐标不变 |

3.4 混凝土吊运效率分析

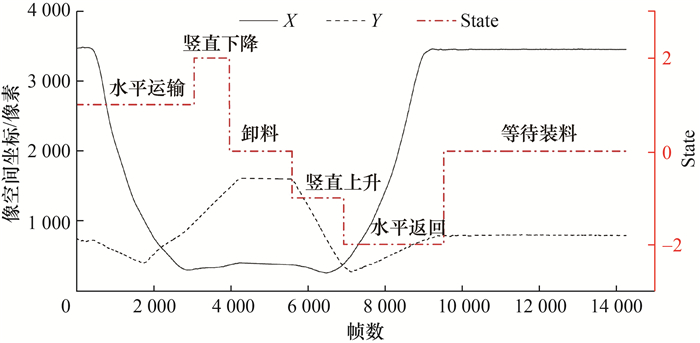

采用已建立的缆机吊运混凝土状态识别标准模板,从轨迹数据中快速判断缆机吊运状态。图 10给出了一个缆机吊运循环中轨迹数据的模式识别结果。根据识别结果,可以统计出缆机的水平运输、竖直下降、卸料、竖直上升、水平返回和等待装料的时长、吊运循环次数、单次吊运循环时长以及浇筑强度等施工效率指标。浇筑强度是衡量缆机施工效率的关键指标,常按一段时间内混凝土的总浇筑量进行衡量。本文中缆机的浇筑强度P是指从T1时刻到T2时刻的时段内缆机的混凝土吊运总量,单位为m3/h,计算方法见下式:

| $ P=C V. $ | (10) |

|

| 图 10 吊罐轨迹数据的模式识别结果 |

其中:C是从T1到T2时段内缆机的吊运循环次数,对于非完整的吊运循环,统计其在平均单次吊运循环时长中的占比;V是缆机吊罐的容量,在大坝工程中多采用9 m3。

4 工程应用与分析 4.1 缆机吊罐的多目标跟踪 4.1.1 实验细节与评价指标本实验训练采用的操作系统为Windows10,深度学习框架为PyTorch,实验处理器为11th Gen Intel(R) Core(TM) i7-11700k,显卡为NVIDIA GeForce RTX 3080。数据集为实际拍摄于某大坝施工现场的缆机吊运视频,共选取8段长视频序列进行多目标跟踪实验,每段视频时长不低于10 min,以保证有完整的吊运循环,其中4个为带标注信息的训练集,3个为测试集,1个时长1 h的视频作为工程案例用以分析缆机吊运效率。数据采集期间,大坝采用4台缆机同时浇筑混凝土。视频中吊罐采用统一型号,外观相似,且存在相互遮挡,以及被其他物体遮挡等复杂情况。

为评估本文提出的多目标跟踪算法的跟踪性能,采用多目标跟踪准确度(multiple object tracking accuracy, MOTA)、误检数(false positive, FP)、漏检数(false negative, FN)、ID跳变次数(identity switch, IDSW)、IDF1值(identity F1 score, IDF1)以及轨迹碎片数(number of track fragmentations, FM)等评价指标。其中MOTA用来整体衡量跟踪的准确度,是正向指标,计算方法见式(11);IDF1用来评估跟踪算法在保持目标ID一致性方面的表现,也是正向指标,计算方法见式(12)。

| $ \mathrm{MOTA}=1-\frac{\sum\limits_t\left(\mathrm{FN}_t+\mathrm{FP}_t+\mathrm{IDSW}_t\right)}{\sum\limits_t \mathrm{GT}_t}. $ | (11) |

其中:t为帧索引号,GT为真实标注的吊罐数量。

| $ \mathrm{IDF} 1=\frac{2 \mathrm{IDTP}}{2 \mathrm{IDTP}+\mathrm{IDFP}+\mathrm{IDFN}} $ | (12) |

其中:IDTP表示真正身份数,IDFP表示假正身份数,IDFN表示假负身份数。

4.1.2 结果与分析为分析本文算法在大坝复杂施工场景中的应用效果,选取3个拍摄于不同时间的长视频序列进行测试,并将其与同样基于DBT模式的SORT、DeepSORT算法进行对比,均使用YOLOv5作为目标检测器。视频序列基本情况为:视频1的时长约16 min,光照条件较好,光线较亮,遮挡时间(包括吊罐间相互遮挡以及吊罐被其他建筑物遮挡)较短;视频2的时长约15 min,光照条件较好,光线较亮,遮挡时间较长;视频3的时长约30 min,光照条件较差,光线较暗,遮挡时间最长。

3种多目标追踪算法的对比实验结果如表 3所示。先从整体角度综合3段视频来看,本文改进的DeepSORT算法的MOTA和IDF1指标分别高达90.0%和94.8%,说明其在跟踪准确度和ID保持能力方面都表现出很好的效果。与SORT和DeepSORT算法相比,本文算法的IDF1分别提升了53.3%和24.2%,且IDSW值明显降低;但三者的MOTA值相近,这是因为影响跟踪准确度的主要因素是检测器性能,而三者均采用YOLOv5作为目标检测器,且该检测器表现出很好的检测性能。本文算法的FM和FN值略高于其他2种算法,这是因为增加了基于轨迹片段的重匹配机制,利用遮挡开始的前n帧提取轨迹片段特征,不进行数据关联,这会增加轨迹的FM和FN值,但整体上会降低IDSW值,大幅度提高ID保持能力。本文算法的FP值低于其他2种算法,这是因为增加重匹配机制,提高了ID分配的准确性,降低了因数据关联错误造成的误检数。此外,3种算法均在视频1中的跟踪性能最好,在视频2和3中性能较差,这是由于视频1中的光照条件较好,有利于吊罐的目标检测;并且吊罐被遮挡的时间较短,有助于提高目标跟踪中数据关联的准确度。而视频3中光线较暗,吊罐被遮挡时间也较长,导致目标检测和跟踪的效果较差。可见,光照和遮挡等环境条件是影响多目标跟踪性能的重要因素,也是当前在工程领域应用视觉跟踪技术要解决的关键难题。

| 算法 | 数据来源 | IDF1 | MOTA | FP | FN | IDSW | FM |

| SORT | 视频1 | 56.5% | 98.3% | 1 001 | 772 | 14 | 177 |

| 视频2 | 47.7% | 93.5% | 2 364 | 3 887 | 77 | 93 | |

| 视频3 | 30.4% | 84.6% | 7 143 | 25 017 | 86 | 590 | |

| 视频1—3 | 41.5% | 90.3% | 10 508 | 29 676 | 177 | 860 | |

| DeepSORT | 视频1 | 78.6% | 98.2% | 790 | 1 177 | 4 | 215 |

| 视频2 | 86.6% | 95.8% | 580 | 3 525 | 6 | 39 | |

| 视频3 | 58.7% | 84.7% | 6 292 | 25 894 | 10 | 591 | |

| 视频1—3 | 70.6% | 90.8% | 7 662 | 30 596 | 20 | 845 | |

| 改进DeepSORT | 视频1 | 99.1% | 98.2% | 774 | 1 205 | 2 | 219 |

| 视频2 | 96.1% | 92.6% | 83 | 7 069 | 2 | 43 | |

| 视频3 | 91.9% | 84.6% | 6 233 | 26 149 | 4 | 619 | |

| 视频1—3 | 94.8% | 90.0% | 7 090 | 34 423 | 8 | 881 |

综上所述,本文算法在复杂的大坝施工场景中针对缆机吊罐多目标跟踪问题有很好的应用效果,实现了吊罐运输轨迹的高精度跟踪,满足工程需求。

4.2 基于模式识别计算缆机吊运效率从数据集中选取一段时长达1 h的长视频序列作为工程案例,应用本文提出的基于视觉跟踪和模式识别的方法计算缆机吊运效率。图 11给出了视频中4台缆机的吊罐轨迹坐标时序变化过程和模式识别结果。由图可知,本文建立的吊运混凝土模式识别方法准确地判断出缆机的水平运输、竖直下降、卸料、竖直上升、水平返回和等待装料6种工作状态。并且还发现,缆机CC2和CC3是从约25 000帧开始吊运混凝土;缆机CC4的单次吊运循环时长最长,其中等待装料的时间较长;缆机CC1的吊运循环次数最多,浇筑强度最高。

|

| 图 11 吊罐轨迹的时序特征和模式识别结果 |

进一步地,根据模式识别结果分析缆机的吊运效率,如表 4所示。缆机CC1和CC3的浇筑强度较高,P分别为64.8和59.4 m3/h;缆机CC2和CC4的浇筑强度较低,P分别为47.7和40.5 m3/h。这是由于缆机CC2和CC4等待装料和卸料的时长较长,造成单次吊运循环时长较长,所以现场管理中可对此进行优化。此外,由于缆机CC1和CC4负责浇筑的坝块1距离供料平台较远且高程较低(见图 7),导致运输时长和返程时长较长;而缆机CC2和CC3的负责浇筑的坝块4距离供料平台较近且高程较高,所需要的运输时长和返程时长较短。

| 缆机 | C/次 | 平均单次吊运循环时长/min | 平均运输时长/s | 平均卸料时长/s | 平均返程时长/s | 平均等待装料时长/s | P/(m3·h-1) | ||

| 水平运输 | 竖直下降 | 竖直上升 | 水平返回 | ||||||

| CC1 | 7.2 | 8.6 | 104.8 | 34.6 | 63.9 | 44.9 | 86.3 | 181.5 | 64.8 |

| CC2 | 5.3 | 9.5 | 72.6 | 15.6 | 170.1 | 38.7 | 57.7 | 219.3 | 47.7 |

| CC3 | 6.6 | 7.6 | 76.9 | 15.5 | 57.6 | 44.2 | 69.8 | 191.8 | 59.4 |

| CC4 | 4.5 | 13.9 | 95.6 | 42.1 | 417.2 | 41.5 | 74.9 | 162.7 | 40.5 |

上述分析结果符合工程实际状况,说明本文方法具备实用性和准确性。

5 结论针对大坝施工中缆机吊运混凝土的过程监测问题,本文提出一种基于视觉跟踪和模式识别的施工效率智能分析方法。首先分析了该问题中存在的施工场景庞大且繁杂、吊罐的外观相似和存在相互遮挡等特点;设计了以YOLO模型为目标检测器、改进DeepSORT算法为目标跟踪器的缆机吊罐多目标跟踪方法,实现高精度完整获取吊罐的移动轨迹,MOTA和IDF1指标分别高达90.0%和94.8%。然后以吊罐轨迹数据为输入,基于统计模式识别方法建立缆机吊运混凝土工作状态识别模型,实现从海量轨迹数据中快速精准识别缆机的水平运输、下降、卸料、上升、水平返回和等待装料6种工作状态,并计算了缆机的单次吊运循环时长、吊运循环次数、工作状态持续时长和浇筑强度等关键效率指标。通过对实际拱坝施工现场采集的缆机吊运视频数据进行实验,验证了本方法的实用性和准确性,为大坝实际施工管理与决策提供技术支持。

大坝的施工是一个长期的动态变化过程,施工环境复杂多变,对视觉技术的干扰因素也十分丰富。因此,未来还需就复杂施工环境下应用视觉技术做进一步研究和探索。

| [1] |

王飞, 刘金飞, 尹习双, 等. 高拱坝智能进度仿真理论与关键技术[J]. 清华大学学报(自然科学版), 2021, 61(7): 756-767. WANG F, LIU J F, YIN X S, et al. Intelligent scheduling for high arch dams[J]. Journal of Tsinghua University (Science and Technology), 2021, 61(7): 756-767. DOI:10.16511/j.cnki.qhdxxb.2021.26.003 (in Chinese) |

| [2] |

王仁超, 王晨旭. 混凝土坝浇筑仿真中的缆机干扰与联合问题研究[J]. 水资源与水工程学报, 2015, 26(2): 195-199. WANG R C, WANG C X. Research on interference and union problem of cable machine in concrete-dam pouring simulation[J]. Journal of Water Resources and Water Engineering, 2015, 26(2): 195-199. (in Chinese) |

| [3] |

徐建江, 陈文夫, 谭尧升, 等. 特高拱坝混凝土运输智能化关键技术与应用[J]. 清华大学学报(自然科学版), 2021, 61(7): 768-776. XU J J, CHEN W F, TAN Y S, et al. Intelligent concrete transport methods for super-high arch dams[J]. Journal of Tsinghua University (Science and Technology), 2021, 61(7): 768-776. DOI:10.16511/j.cnki.qhdxxb.2021.26.007 (in Chinese) |

| [4] |

钟登华, 关涛, 任炳昱. 基于改进重抽样法的高拱坝施工进度仿真研究[J]. 水利学报, 2016, 47(4): 473-482. ZHONG D H, GUAN T, REN B Y. Construction simulation for high arch dams based on modified Bootstrap[J]. Journal of Hydraulic Engineering, 2016, 47(4): 473-482. (in Chinese) |

| [5] |

WANG D, WANG X L, REN B Y, et al. Vision-based productivity analysis of cable crane transportation using augmented reality-based synthetic image[J]. Journal of Computing in Civil Engineering, 2022, 36(1): 04021030. DOI:10.1061/(ASCE)CP.1943-5487.0000994 |

| [6] |

WU H, YIN Y, WANG S J, et al. Optimizing GPS-guidance transit route for cable crane collision avoidance using artificial immune algorithm[J]. GPS Solutions, 2017, 21(2): 823-834. DOI:10.1007/s10291-016-0573-6 |

| [7] |

WU H, TAO J, LI X P, et al. A location based service approach for collision warning systems in concrete dam construction[J]. Safety Science, 2013, 51(1): 338-346. DOI:10.1016/j.ssci.2012.08.006 |

| [8] |

赵春菊, 资瑛, 周宜红, 等. 缆机吊重海量监测数据的吊运混凝土模式识别[J]. 水力发电学报, 2021, 40(12): 119-128. ZHAO C J, ZI Y, ZHOU Y H, et al. Pattern recognition of concrete lifting modes based on massive monitoring data of cable crane[J]. Journal of Hydroelectric Engineering, 2021, 40(12): 119-128. (in Chinese) |

| [9] |

SON H, KIM C. Integrated worker detection and tracking for the safe operation of construction machinery[J]. Automation in Construction, 2021, 126: 103670. DOI:10.1016/j.autcon.2021.103670 |

| [10] |

XIAO B, LIN Q, CHEN Y. A vision-based method for automatic tracking of construction machines at nighttime based on deep learning illumination enhancement[J]. Automation in Construction, 2021, 127: 103721. DOI:10.1016/j.autcon.2021.103721 |

| [11] |

XIAO B, XIAO H R, WANG J W, et al. Vision-based method for tracking workers by integrating deep learning instance segmentation in off-site construction[J]. Automation in Construction, 2022, 136: 104148. DOI:10.1016/j.autcon.2022.104148 |

| [12] |

华夏, 王新晴, 芮挺, 等. 视觉感知的无人机端到端目标跟踪控制技术[J]. 浙江大学学报(工学版), 2022, 56(7): 1464-1472. HUA X, WANG X Q, RUI T, et al. Vision-driven end-to-end maneuvering object tracking of UAV[J]. Journal of Zhejiang University (Engineering Science), 2022, 56(7): 1464-1472. (in Chinese) |

| [13] |

刘创, 梁军. 基于注意力机制的车辆运动轨迹预测[J]. 浙江大学学报(工学版), 2020, 54(6): 1156-1163. LIU C, LIANG J. Vehicle motion trajectory prediction based on attention mechanism[J]. Journal of Zhejiang University (Engineering Science), 2020, 54(6): 1156-1163. (in Chinese) |

| [14] |

SUN P Z, CAO J K, JIANG Y, et al. DanceTrack: Multi-object tracking in uniform appearance and diverse motion[C]// Proceedings of 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans, USA: IEEE, 2022: 20961-20970.

|

| [15] |

ZHANG Y, WANG T C, ZHANG X Y. MOTRv2: Bootstrapping end-to-end multi-object tracking by pretrained object detectors[C]// Proceedings of 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver, Canada: IEEE, 2023: 22056-22065.

|

| [16] |

WOJKE N, BEWLEY A, PAULUS D. Simple online and realtime tracking with a deep association metric[C]// Proceedings of 2017 IEEE International Conference on Image Processing. Beijing, China: IEEE, 2017: 3645-3649.

|

| [17] |

GUO Y Y, HONG W H, WU J X, et al. Vision-based cow tracking and feeding monitoring for autonomous livestock farming: The YOLOv5s-CA+DeepSORT-Vision transformer[J]. IEEE Robotics & Automation Magazine, 2023, 30(4): 68-76. |

| [18] |

ZHANG C, TANG Z Z, ZHANG M, et al. Developing a more reliable aerial photography-based method for acquiring freeway traffic data[J]. Remote Sensing, 2022, 14(9): 2202. DOI:10.3390/rs14092202 |

| [19] |

SUN Z H, CHEN J, CHAO L, et al. A survey of multiple pedestrian tracking based on tracking-by-detection framework[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2021, 31(5): 1819-1833. DOI:10.1109/TCSVT.2020.3009717 |

| [20] |

GAO T Y, WUSHOUER M, TUERHONG G. Small object detection method based on improved YOLOv5[C]// Proceedings of 2022 International Conference on Virtual Reality, Human-Computer Interaction and Artificial Intelligence. Changsha, China: IEEE, 2022: 144-149.

|

| [21] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]// Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA: IEEE, 2016.

|

| [22] |

YANG Y Z. Drone-view object detection based on the improved YOLOv5[C]// Proceedings of 2022 IEEE International Conference on Electrical Engineering, Big Data and Algorithms. Changchun, China: IEEE, 2022: 612-617.

|

| [23] |

金立生, 华强, 郭柏苍, 等. 基于优化DeepSort的前方车辆多目标跟踪[J]. 浙江大学学报(工学版), 2021, 55(6): 1056-1064. JIN L S, HUA Q, GUO B C, et al. Multi-target tracking of vehicles based on optimized DeepSort[J]. Journal of Zhejiang University (Engineering Science), 2021, 55(6): 1056-1064. (in Chinese) |

| [24] |

CHEN R X, FERREIRA V G, LI X H. Detecting moving vehicles from satellite-based videos by tracklet feature classification[J]. Remote Sensing, 2023, 15(1): 34. |

| [25] |

ZHANG Y F, SUN P Z, JIANG Y, et al. ByteTrack: Multi-object tracking by associating every detection box[C]// Proceedings of the 17th European Conference on Computer Vision. Tel Aviv, Israel: Springer, 2022: 1-21.

|

| [26] |

陈爽, 张悦, 张勤俭, 等. 一种基于B样条插值的机器人速度规划算法[J]. 应用基础与工程科学学报, 2018, 26(03): 661-671. CHEN S, ZHANG Y, ZHANG Q J, et al. A kind of robot speed planning algorithm based on B-spline interpolations[J]. Journal of Basic Science and Engineering, 2018, 26(03): 661-671. (in Chinese) |

| [27] |

万欣, 刘锡明, 苗积臣, 等. 改进的多层螺旋CT线性插值算法[J]. 清华大学学报(自然科学版), 2016, 56(12): 1346-1351. WAN X, LIU X M, MIAO J C, et al. Improved linear interpolation algorithm for multi-slice helical CT[J]. Journal of Tsinghua University (Science and Technology), 2016, 56(12): 1346-1351. DOI:10.16511/j.cnki.qhdxxb.2016.25.045 (in Chinese) |

| [28] |

CHEN Y, CAO R Y, CHEN J, et al. A practical approach to reconstruct high-quality Landsat NDVI time-series data by gap filling and the Savitzky-Golay filter[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2021, 180: 174-190. |