2. 湖南师范大学 工程与设计学院, 长沙 410006

2. College of Engineering and Design, Hunan Normal University, Changsha 410006, China

当前中国正处于教育数字化转型的关键阶段,网络空间内教育相关文本呈爆炸式增长,教育工作者如何从浩瀚的数据中快速准确地挖掘出关键信息是当前教育研究中的难点和热点。关键词自动抽取是一种从文本中自动抽取出主题性或重要性的词或短语的自然语言处理技术[1],可以帮助人们快速了解文档的主题思想和主要内容,提高信息获取的及时性和准确性;同时也是文本检索、文本摘要、意见挖掘、自动推荐等自然语言处理任务和信息检索任务的基础性和必要性工作,因此关键词自动抽取的方法一直受到研究者们的关注。

随着面向自然语言处理领域的预训练模型的兴起,现有的关键词自动抽取方法倾向于直接利用预训练语言模型从海量语料中学习到的通用语言表示进行关键词抽取[2]。虽然该类方法提升了关键词抽取任务的准确性,但还存在2方面的问题:1) 无法根据下游任务特性进行领域适配。目前的预训练语言模型主要是基于大规模通用领域文本语料进行训练[3],当该类预训练语言模型应用于特定领域的关键词自动抽取任务时,可能会因一些复杂汉字或生僻字没有记录在预训练模型的固定词汇表中,导致预训练语言模型无法完全理解其语义,抽取出任务相关关键词的准确性不高。因此有研究者尝试将汉字拆分成偏旁和部首[4],并抽取偏旁和部首的特征与预训练模型获取的上下文表示直接进行对齐融合,但上述方法没有将偏旁和部首特征集成到预训练语言模型底层,没有充分利用预训练语言模型的表示能力。2) 单模态信息语义表征能力有限。目前的预训练语言模型主要是利用单一的文本语料进行训练,大多关注文本中词语之间的语义关系[5]。而中文是以象形为基础的文字,往往通过字形图像来表达物体、动作和抽象概念等的特征或本质,字形图像能较好地辅助理解汉字,帮助中文自然语言处理模型获得更丰富、更全面的语义表征。因此,有研究者尝试提取汉字的字形特征丰富文本表示[6, 7],但是在使用时将字形特征与文本表示直接连接,没有考虑字形特征和文本特征分布在2个特征空间的情况。

因此,本文提出一种多模态信息增强表示的中文关键词抽取方法MIEnhance-KPE。针对无法根据下游任务特性进行领域适配的问题,使用Adapter层引入偏旁和部首信息微调预训练语言模型,更好地适应特定领域数据;针对单模态信息语义表征能力有限的问题将汉字转化为图像,在文本语义的基础上使用交叉注意力机制引入汉字图像语义信息,获得更丰富、全面的语义表征。在此基础上,利用公开数据集和自构建数据集进行了验证实验。

1 相关工作 1.1 关键词抽取现有的关键词抽取方法主要分为基于无监督的方法和基于有监督的方法。基于无监督的方法[8-10]是指通过人为设定关键词的权重量化指标,然后计算权重进行排序获得关键词。这类方法简单且无须标注语料,能适应各个领域的关键词抽取任务,但是其主要依靠人为设定权重量化指标,无法有效综合多种信息对候选关键词排序。基于有监督的方法将关键词抽取问题视为二分类问题或序列标注问题,即通过人为标注关键词的数据集来训练分类模型或序列标注模型,以此来判断词语是否为文本关键词。传统的基于有监督的方法主要依赖机器学习技术[11-13],该类方法抽取关键词的精度高于基于无监督的方法,但是特征构建过程依赖一定的人工经验,耗时耗力。针对上述问题,有研究者通过训练深度学习模型作为特征提取器,提取文本上下文特征[14-17]。例如Zhang等[18]使用循环神经网络(recurrent neural network,RNN)提取文本特征并对序列中的关键词进行标注。孙新等[19]利用长短时记忆神经网络(long short-term memory,LSTM)和卷积神经网络(convolutional neural network,CNN)构建了2种短语向量模型提取短语向量,再基于短语向量构建TextRank迭代图进行关键词抽取。上述方法虽然能直接从原始输入中学习到有效文本特征表示,但是需要大量标注数据用以训练模型。针对上述研究的不足,现有研究倾向于直接使用基于通用领域语料预先训练好的语言模型来生成包含上下文语义信息的文本表示,再进行后续的关键词抽取工作[20, 21]。例如Sun等[22]使用BERT获得上下文嵌入并构造候选短语向量和文档向量,通过计算两者之间的相似性对候选短语进行排序,从而获得文本关键词;Song等[23]使用RoBERTa获得短语表示和文档表示,然后将其映射到双曲空间中捕捉文本中的层次结构,最后通过计算短语-文档相关性获得关键词。虽然上述的方法取得了较好的效果,但是进行关键词抽取时依赖的上下文嵌入来源于预训练语言模型,对于固定词表中不存在的字符,预训练语言模型无法准确获取其上下文表示。同时现有的预训练语言模型主要是基于单一文本语料进行训练的,主要关注文本中单词和句子之间的语义关系,以及单词和句子在语料库中的上下文信息,并没有直接考虑汉字图像和偏旁部首等多模态信息,语义表征能力有限。

1.2 汉字多模态信息表示 1.2.1 偏旁和部首特征受人们通常通过分解汉字组件来理解字符含义的启发,有研究者开始尝试使用偏旁和部首信息来增强字符表示,目前抽取偏旁和部首特征的主要做法是将汉字根据拆字词典分解成偏旁和部首,然后通过固定的偏旁部首表映射成ID序列,最后输入深度学习模型通过迭代训练得到偏旁和部首特征。例如Dong等[24]使用部首级双向长短期记忆网络(bi-directional long short-term memory,Bi-LSTM)来提取偏旁和部首的嵌入,然后将其与字符嵌入拼接起来作为最终的输入,应用到中文命名实体识别任务中,并在MSRA数据集上取得了较好的效果。Han等[25]提出一种基于结构的汉字编码方法(五笔)将汉字分解成笔画来表示结构特征,并将语义、结构和语音特征融合进行命名实体识别任务。Wu等[26]将汉字分解为偏旁和部首输入到卷积神经网络中,获得汉字部首级别特征嵌入,然后提出一种基于多元数据嵌入的Transformer层,通过融合汉字部首级别特征、字符特征和词语特征来提高自然语言处理任务的性能。上述方法虽然取得了较好的效果,但没有将偏旁和部首特征集成到预训练语言模型底层,没有充分利用预训练语言模型的表示能力。

1.2.2 字形特征随着计算机技术的发展,对汉字字形特征的研究逐渐受到重视,汉字字形信息表示方法也得到了广泛的研究和应用。目前字形特征提取的主流做法是将汉字转化为图像,再用CNN等特征提取器进行图像特征提取。例如Meng等[6]提出了汉字表示的语言向量Glyce,该方法首先将汉字转化为图像,然后利用CNN进行卷积运算得到汉字的字形表征向量。Xuan等[7]将文本句子转化成图像序列,使用3D卷积层对图像序列进行编码,捕获了字形信息以及相邻字符的字形之间的交互知识。Chen等[27]将汉字转化为图像,然后利用卷积自动编码器ConvAE来获取汉字字形视觉特征解决了汉语词汇外词嵌入问题。上述方法有效丰富了汉字的语义信息,但是其在利用汉字字形特征时,忽略了字形特征和文本特征之间潜在的差异性,可能导致信息冗余或丢失,影响自然语言处理模型的性能。

因此,汉字的偏旁部首信息和字形信息是2种不同模态的信息,和文本语义信息并不完全独立,彼此之间存在一定的联系和相互作用。人们在理解和使用汉字时,往往需要将多模态信息和文本语义信息结合起来,才能准确表达和理解意义。因此,同时考虑汉字的文本语义、字形图像和偏旁部首等多模态信息,将有效地提高汉字表示的准确性和鲁棒性。

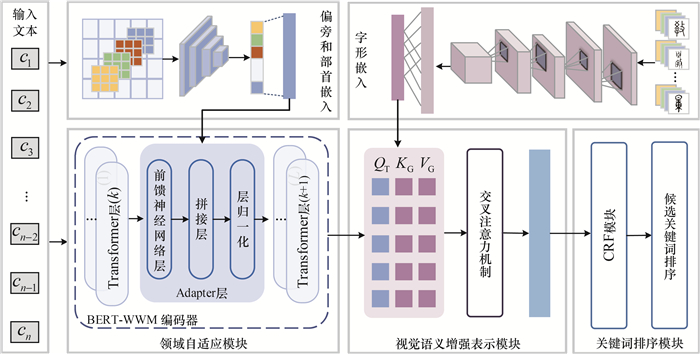

2 多模态信息增强表示的中文关键词抽取方法本文构建的多模态信息增强表示的中文关键词抽取方法MIEnhance-KPE主要包括领域自适应、视觉语义增强表示、关键词排序3个模块,具体流程如图 1所示。

|

| 图 1 MIEnhance-KPE流程 |

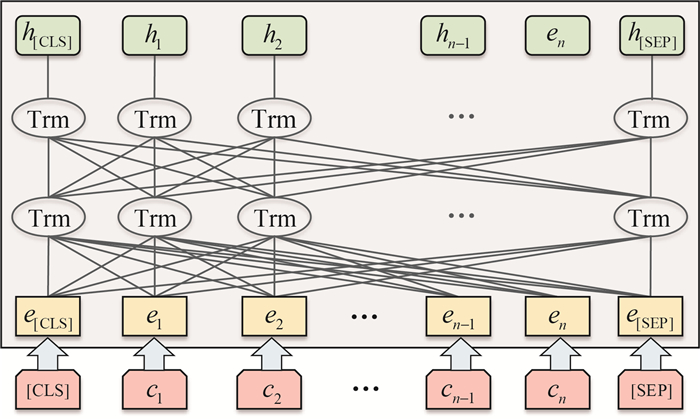

2.1 领域自适应模块 2.1.1 通用文本嵌入获取

采用哈尔滨工业大学讯飞联合实验室发布的基于全词覆盖的中文BERT预训练模型BERT-WWM[28]获取输入文本的特征表示,具体流程如图 2所示。BERT-WWM模型由相同的Transformer编码模块堆叠L层形成,每一层Transformer编码模块由多头注意力层、残差网络层、层归一化层和前馈神经网络层组成。给定输入文本D={c1, c2, …, cn},在其起始位置分别加入特殊符号“[CLS]”和“[SEP]”,通过映射可以得到输入向量E=(e[CLS], e1, e2, …, en, e[SEP]),对于第k(k∈{1, 2, …, L})层编码模块来说,首先将E输入到由M组自注意力模型组成的多头注意力中得到第m(m∈{1, 2, …, M})组特征向量zm,具体计算如式(1)所示。

| $\boldsymbol{z}_{m}=\operatorname{Attention}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})=\operatorname{softmax}\left(\frac{\boldsymbol{Q} \boldsymbol{K}^{\mathrm{T}}}{\sqrt{\boldsymbol{d}_{k}}}\right) \boldsymbol{V}.$ | (1) |

|

| 图 2 文本特征提取流程 |

其中:Q, K, V由3个不同的权值矩阵Wq, Wk, Wv与输入向量相乘得到;然后将M组特征向量拼接后得到向量Z,同时将向量Z与输入向量E拼接传入层归一化层得到向量Z′;最后将Z′传入到前馈神经网络层得到输出Hk=(h[CLS]k, h1k, h2k, …, hnk, h[SEP]k),计算如下所示:

| $\operatorname{FFN}\left(\boldsymbol{Z}^{\prime}\right)=\left(\max \left(0, \boldsymbol{Z}^{\prime} \boldsymbol{W}_{1}+\boldsymbol{b}_{1}\right)\right) \boldsymbol{W}_{2}+\boldsymbol{b}_{2}.$ | (2) |

其中FFN表示前馈神经网络层,包含激活函数ReLU层和线性激活函数层;W1, W2表示均参数矩阵;b1, b2均表示偏置。

2.1.2 领域自适应大规模预训练语言模型是基于通用语料库进行训练的,而特定领域的数据中可能会出现一些通用语料词表中没有记录的字词。为了解决该类词汇不足(out of vocabulary,OOV)问题,需要对特定领域的语料库进行微调,以便更好地理解和处理与该领域相关的语言现象。因此,为了更好地适应中文关键词抽取任务,本文引入Adapter层微调预训练语言模型,将偏旁和部首信息直接集成到预训练语言模型层中。受MECT[26]的启发,本文首先根据拆字词典将汉字分解成偏旁和部首,然后通过固定的偏旁部首表将其映射成ID序列,并将其ID序列输入到CNN特征提取器中进行卷积运算,最后使用最大池化和全连接网络得到每个汉字的偏旁和部首特征。其中CNN特征提取器主要是通过调整卷积核的大小来学习不同偏旁和部首之间的联系。具体来说,对于字符ci(i∈{1, 2, …, n}),首先通过拆字词典获得其偏旁和部首的序列{r1, r2, r3, r4},并随机初始化其特征获得偏旁和部首向量矩阵Ri;然后采用卷积核在Ri以步长l滑动时进行卷积操作,其输出可以表示为

| $\boldsymbol{E}_{\mathrm{CNN}}=\operatorname{Conv} 2 \mathrm{~d}\left(\boldsymbol{R}_{i}\right).$ | (3) |

最后通过最大池化层和前馈层得到偏旁和部首特征ERadical,具体计算如式(4)和(5)所示。

| $\boldsymbol{E}_{\max }=\text { Maxpooling }\left(\boldsymbol{E}_{\mathrm{CNN}}\right) , $ | (4) |

| $\boldsymbol{E}_{\text {Radical }}=\operatorname{FFN}\left(\boldsymbol{E}_{\max } \boldsymbol{W}_{3}+\boldsymbol{b}_{3}\right) .$ | (5) |

其中:W3表示参数矩阵,b3表示偏置。

本文在BERT-WWM已经训练过的Transformer层之间添加Adapter层,并为特定任务添加和训练Adapter中的参数。以在第k层Transformer和k+1层Transformer之间引入Adapter层为例,由BERT-WWM模型可以获得第k层Transformer的输出Hk=(hCLSk, h1k, h2k, …, hnk, hSEPk)。为了更好地融合BERT-WWM的语义特征与偏旁和部首特征,将ERadical和Hk作为Adapter层的输入,使用一个前馈层对两者进行对齐;然后利用ERadical与Hk进行拼接增强字符向量,具体计算如式(6)所示。

| $\boldsymbol{H}_{k}^{\prime}=\boldsymbol{H}_{k}+\boldsymbol{E}_{\text {Radical }} .$ | (6) |

BERT-WWM中Transformer的层数L=24,以此类推,将H′k输入k+1层Transformer中得到,同样将ERadical和Hk输入Adapter进行融合得到H′k+1,并作为下一层Transformer的输入。最后得到了用于序列标记任务的视觉增强表示HText。

2.2 视觉语义增强表示模块早期的汉字大多具有很强的象形性,可以通过字形直接理解其意义。但是当前广泛使用的简体字十分抽象化,很难得到字的表意信息,单一地使用简体字会丢失大量的象形信息。因此本文使用不同历史时期和不同写作风格的汉字作为字形图像来源,将其输入到CNN特征提取器中提取字形特征,并添加一个图像分类损失函数来提高模型的泛化能力。具体来说,对于字符ci,首先将其映射为不同时期和不同写作风格的文字,得到图像序列{v1, v2, …, vS};然后针对其中任一图像vs(s∈{1, 2, …, S}),用大小为g的卷积核进行卷积以捕获较低级图像特征;接着通过最大池化操作将特征图降为2×2大小以捕获更小尺度的特征;最后用分组卷积(group convolution)得到汉字的图像vs的字形表征向量EGlyph。在训练过程中为了更显式地建模汉字图像特征,使用了图像分类任务作为附加的损失函数,也即将字形嵌入EGlyph再输入到图像分类器中预测其对应的字符。图像分类任务的损失函数如式(7)所示。

| $\operatorname{Loss}_{\text {Glyph }}=-\ln P\left(q \mid v_{s}\right) .$ | (7) |

其中q表示图像vs的真实标签。

通过交叉注意力机制增强文本表示,其中HText作为查询(query)向量,而EGlyph分别作为键(key)向量和值(value)向量。视觉增强的注意输出为Evs,计算如式(8)所示。将HText和Ev连接起来输入到前馈神经网络中,其包含激活函数ReLU层和线性激活函数层,最后得到最终的视觉语义增强表示

| $ \begin{gather*} \boldsymbol{E}_{\mathrm{v}}=\operatorname{Attention}\left(\boldsymbol{Q}_{\mathrm{T}}, \boldsymbol{K}_{\mathrm{G}}, \boldsymbol{V}_{\mathrm{G}}\right)= \\ \operatorname{Softmax}\left(\frac{\boldsymbol{Q}_{\mathrm{T}} \boldsymbol{K}_{\mathrm{G}}^{\mathrm{T}}}{\sqrt{\boldsymbol{d}_{k}}}\right) \boldsymbol{V}_{\mathrm{G}} , \end{gather*}$ | (8) |

| $\boldsymbol{E}_{\mathrm{vs}}=\boldsymbol{E}_{\mathrm{v}}+\boldsymbol{H}_{\mathrm{Text}} , $ | (9) |

| $\hat{\boldsymbol{E}}_{\mathrm{vs}}=\operatorname{FFN}\left(\boldsymbol{E}_{\mathrm{vs}} \boldsymbol{W}_{4}+\boldsymbol{b}_{4}\right).$ | (10) |

其中:W4表示参数矩阵,b4表示偏置。

2.3 关键词排序模块直接使用

| $P(X \mid Y)=\frac{\exp \left(\sum\limits_{t=1}^{T} W_{t} F_{t}(X, Y)\right)}{\sum\limits_{y} \exp \left(\sum\limits_{t=1}^{T} W_{t} F_{t}(X, Y)\right)} .$ | (11) |

其中:Ft表示第t(t∈{1, 2, …, T})个标签序列的打分函数,Wt表示第t个标签序列的权重。然后使用Viterbi解码最大化P(X|Y),计算概率最大的标签序列获得候选关键词集合O={o1, o2, …, oJ}。

| $\hat{Y}=\operatorname{argmax} P(X \mid Y) .$ | (12) |

一篇文档的关键词的个数需有所限制,有研究者统计发现,在文档中出现位置越靠前的词语,越有可能成为文档的关键词[29],因此本文在词频权重WTF基础上加入了位置权重WPosition构成了词语的混合权重WSum,对CRF模型标注出来的候选关键词集合O进行排序,选取前K个候选关键词作为文本的关键词。候选关键词oj(j∈{1, 2, …, J})的WSum的计算如式(13)—(15)所示。

| $W_{\mathrm{TF}}\left(o_{j}\right)=\frac{f_{\mathrm{o}_{j}}}{N_{\mathrm{D}}}, $ | (13) |

| $W_{\text {Position }}\left(o_{j}\right)=\frac{1}{p_{{\rm{o}}_{j}}+u}, $ | (14) |

| $W_{\mathrm{Sum}}\left(o_{j}\right)=W_{\mathrm{TF}}\left(o_{j}\right) \cdot W_{\text {Position }}\left(o_{j}\right) .$ | (15) |

其中;foj表示候选关键词oj在输入文本D中出现的次数,ND表示输入文本D中所有词条项的总数量,poj表示候选关键词oj第一次出现在输入文本中的位置,u表示常数。

3 实验设置与结果分析 3.1 数据集为了验证MIEnhance-KPE方法的有效性,本文在公开的中文科学文献数据集(Chinese Scientific Literature,CSL)[30]和自构建的中文教育关键词抽取数据集CEKED上进行实验,数据集的详细统计数据如表 1所示。

| 个 | |||||||||||||||||||||||||||||

| 数据集 | 输入文本平均字符数 | 关键词平均数 | 抽取关键词平均数 | 生成关键词平均数 | |||||||||||||||||||||||||

| CEKED | 269.11 | 10.00 | 9.87 | 0.13 | |||||||||||||||||||||||||

| CSL | 227.23 | 5.10 | 4.29 | 0.82 | |||||||||||||||||||||||||

从CSL数据集中选取关键词生成部分的10 000篇期刊摘要进行相关实验。其中训练集8 000篇,验证集1 000篇,测试集1 000篇。平均每篇输入文本有5.10个关键词,根据语义生成的关键词的比例为16.08%。

为了实现教育领域关键词抽取任务,本文以教育研究的最新前沿动态和热点“互联网+教育”为主题,利用网络爬虫技术在中国知网(CNKI)中爬取主题为“互联网+教育”“教育+互联网”“‘互联网+’教育”“互联网教育”“网络教育”“在线教育”,且所属期刊级别为核心及以上的文献,构建了中文教育关键词抽取数据集CEKED,共获取了1 300篇期刊文献摘要。过滤其中重复、不完整、字量过少和语言为英文的期刊摘要,最终获得1 030篇期刊摘要。最后,论文采用Min-Max集合评测方法,邀请3名教育领域的专家各自对每篇期刊文献标注10个词语作为关键词,将3名专家标注结果的交集和并集作为最终标注结果(Ground-Truth),使用数据量最大的集合计算正确率,使用数据量最小的集合计算召回率,划分训练集、验证集和测试集的比例为7∶2∶1,平均每篇输入文本有10个关键词,根据语义生成的关键词的比例为1.30%。

3.2 实验参数设置本文所提出的关键词抽取方法MIEnhance-KPE采用Python3.6编程实现,所有实验均在硬件配置为显卡NVIDIA GeForce RTX 4090,处理器为11th Gen Intel(R) Core(TM) i9-11900K @ 3.50 GHz,运行内存为128 GB,运行环境为Ubuntu 20.04.3 LTS操作系统的计算机上实现;采用的预训练语言模型为哈尔滨工业大学讯飞联合实验室发布的基于全词覆盖的中文BERT预训练模型(BERT-WWM),其学习率为3×105,最大序列长度为512,训练批尺寸(batch size)为384。MIEnhance-KPE方法的具体训练参数设置如表 2所示。

| 参数 | 参数描述 | 参数值 |

| max_seq_len | 输入序列最大长度 | 512 |

| hidden_size | 隐藏层维度 | 1 024 |

| radical_emb_size | 偏旁和部首特征维度 | 50 |

| glyph _emb_size | 字形特征维度 | 1 024 |

| radicalCNN_kernel_size | 偏旁和部首特征提取器CNN的卷积核大小 | 3 |

| glyphCNN_kernel_size | 字形特征提取器CNN的卷积核大小 | 2 |

| crf_lr | CRF的学习率 | 1×103 |

| adapter_lr | Adapter的学习率 | 1×103 |

3.3 评价指标

在实验中采用准确率、召回率和F1值3种指标来评价关键词抽取的效果,3种指标具体计算过程如式(16)—(18)所示。

| $P=\frac{K_{\mathrm{A}} \cap K_{\mathrm{M}}}{K_{\mathrm{A}}} \times 100 \%, $ | (16) |

| $R=\frac{K_{\mathrm{A}} \cap K_{\mathrm{M}}}{K_{\mathrm{M}}} \times 100 \% , $ | (17) |

| $F=\frac{2 P R}{P+R} \times 100 \% .$ | (18) |

其中:F表示方法的F1值,P表示方法准确率,R表示方法的召回率,KM表示测试集中人工标注的关键词集合,KA表示测试集中自动抽取的关键词集合。

3.4 实验基准方法论文选取了基于无监督的方法TFIDF[8]、TextRank[9]、SIFRank[29],基于机器学习的方法LR-SGD[31]、CRF[12]、HMM(hidden Markov model)[32],基于深度学习的方法Bi-LSTM-CRF[15]、BiLSTM-CRF+Word Centrality[33]、BERT-KPE[22]、KIEMP[34]作为基准方法与本文所提的MIEnhance-KPE方法进行对比,基准方法的介绍如表 3所示。

| 方法类型 | 方法名称 | 简介 |

| TFIDF | 通过计算词语的词频和逆文档频率进行排序抽取关键词 | |

| 基于无监督的方法 | TextRank | 利用词语共现关系构建词图进行迭代抽取关键词 |

| SIFRank | 计算候选关键词向量与句向量的余弦相似度来抽取关键词 | |

| LR-SGD | 训练一个逻辑回归模型作为分类器区分词语是否为关键词 | |

| 基于机器学习的方法 | HMM | 训练HMM模型作为序列标注模型进行关键词抽取 |

| CRF | 训练CRF模型学习标注序列的条件概率分布实现关键词抽取 | |

| Bi-LSTM-CRF | 结合了BiLSTM模型的上下文建模能力和CRF模型的标签关系建模能力实现关键词抽取 | |

| 基于深度学习的方法 | BiLSTM-CRF+Word Centrality | 在BiLSTM-CRF的基础上引入中心性约束层进行关键词抽取 |

| BERT-KPE | 采用多任务学习同时训练分块和排序网络实现关键词抽取 | |

| KIEMP | 训练分块、排序和匹配模块从多个视角计算词语为关键词的概率 |

4 实验设置与结果分析 4.1 对比实验

将本文所提的MIEnhance-KPE方法与3.4节所列基准方法在CSL和CEKED数据集上进行对比,实验结果分别如表 4和表 5所示。其中“@3”表示方法在数据集上抽取3个关键词的情况,“@5”和“@10”可以此类推。由表可知,MIEnhance-KPE方法在CSL数据集和CEKED数据集上F的值比当前十分先进的KIEMP方法分别提高了15.71%和3.40%。与KIEMP方法相比,MIEnhance-KPE在公用数据集CSL上值提升的效果显著高于自构建数据集CEKED,原因是CEKED数据集的语料来自教育类文献,其中大部分标注关键词由复杂短语组合而成;而CSL数据集的语料来自于通用领域,其标注的关键词主要由简单的词语构成。KIEMP方法使用分块模块来专门提取短语,导致其更倾向于抽取长度较长的关键词。但MIEnhance-KPE方法在CSL数据集上的整体性能低于CEKED数据集,其原因是CSL数据集中根据语义生成关键词的比例为16.08%,而MIEnhance-KPE是关键词抽取方法,无法抽取不在输入文本中的关键词,导致准确率和召回率较低。

| % | |||||||||||||||||||||||||||||

| 方法类型 | 方法名称 | CSL数据集 | |||||||||||||||||||||||||||

| P@3 | P@5 | P@10 | R@3 | R@5 | R@10 | F@3 | F@5 | F@10 | |||||||||||||||||||||

| 基于无监督的方法 | TFIDF | 15.31 | 12.24 | 9.06 | 10.73 | 13.38 | 17.25 | 12.62 | 12.78 | 11.88 | |||||||||||||||||||

| TextRank | 13.35 | 11.47 | 8.86 | 9.00 | 12.56 | 17.98 | 10.75 | 11.99 | 11.87 | ||||||||||||||||||||

| SIFRank | 13.78 | 12.14 | 10.30 | 8.95 | 12.65 | 18.58 | 10.85 | 12.39 | 13.25 | ||||||||||||||||||||

| 基于机器学习的方法 | LR-SGD | 16.50 | 13.52 | 9.30 | 11.28 | 14.80 | 18.90 | 13.40 | 14.13 | 12.46 | |||||||||||||||||||

| HMM | 13.58 | 12.79 | 12.50 | 7.65 | 8.77 | 9.37 | 9.79 | 10.41 | 10.71 | ||||||||||||||||||||

| CRF | 18.13 | 17.90 | 17.87 | 8.10 | 8.68 | 8.74 | 11.20 | 11.69 | 11.74 | ||||||||||||||||||||

| 基于深度学习的方法 | Bi-LSTM-CRF | 29.41 | 25.57 | 24.28 | 18.41 | 22.55 | 26.86 | 22.64 | 23.97 | 25.51 | |||||||||||||||||||

| BiLSTM-CRF+ Word Centrality | 29.40 | 26.62 | 25.64 | 18.04 | 22.21 | 25.42 | 22.36 | 24.22 | 25.53 | ||||||||||||||||||||

| BERT-KPE | 32.45 | 39.07 | 23.59 | 42.50 | 47.91 | 65.59 | 34.81 | 35.93 | 32.16 | ||||||||||||||||||||

| KIEMP | 43.02 | 35.10 | 24.84 | 40.11 | 52.41 | 69.56 | 38.64 | 39.06 | 33.96 | ||||||||||||||||||||

| MIEnhance-KPE | 46.88 | 46.91 | 46.74 | 44.58 | 50.58 | 52.48 | 45.70 | 48.68 | 49.44 | ||||||||||||||||||||

| % | |||||||||||||||||||||||||||||

| 方法类型 | 方法名称 | CEKED数据集 | |||||||||||||||||||||||||||

| P@3 | P@5 | P@10 | R@3 | R@5 | R@10 | F@3 | F@5 | F@10 | |||||||||||||||||||||

| 基于无监督的方法 | TFIDF | 16.18 | 14.76 | 11.84 | 4.85 | 7.38 | 11.84 | 7.47 | 9.84 | 11.84 | |||||||||||||||||||

| TextRank | 16.18 | 13.98 | 12.14 | 4.85 | 6.99 | 12.14 | 7.47 | 9.32 | 12.14 | ||||||||||||||||||||

| SIFRank | 20.71 | 17.48 | 17.34 | 6.21 | 8.74 | 16.43 | 9.56 | 11.65 | 16.87 | ||||||||||||||||||||

| 基于机器学习的方法 | LR-SGD | 19.09 | 16.12 | 12.52 | 5.73 | 8.06 | 12.52 | 8.81 | 10.75 | 12.52 | |||||||||||||||||||

| HMM | 49.84 | 41.50 | 35.97 | 14.95 | 20.29 | 28.76 | 23.00 | 27.25 | 31.96 | ||||||||||||||||||||

| CRF | 55.72 | 50.51 | 46.18 | 16.37 | 23.25 | 31.79 | 25.31 | 31.84 | 37.66 | ||||||||||||||||||||

| 基于深度学习的方法 | Bi-LSTM-CRF | 62.30 | 54.40 | 43.94 | 18.45 | 26.60 | 41.18 | 28.47 | 35.73 | 42.52 | |||||||||||||||||||

| BiLSTM-CRF+ Word Centrality | 62.78 | 55.28 | 46.73 | 18.45 | 26.80 | 42.74 | 28.52 | 36.10 | 44.65 | ||||||||||||||||||||

| BERT-KPE | 71.20 | 66.41 | 58.06 | 21.92 | 34.07 | 59.59 | 33.52 | 45.04 | 58.82 | ||||||||||||||||||||

| KIEMP | 76.70 | 70.87 | 58.93 | 23.70 | 36.41 | 60.53 | 36.21 | 48.11 | 59.72 | ||||||||||||||||||||

| MIEnhance-KPE | 78.76 | 74.07 | 67.59 | 23.74 | 37.12 | 59.20 | 36.48 | 49.46 | 63.12 | ||||||||||||||||||||

整体来看,基于有监督的方法优于一般的基于无监督的方法,基于深度学习的方法比基于机器学习方法的效果要好。其中无监督方法如TFIDF和TextRank都是在分词结果的基础上进行关键词抽取,而教育类文献中人工标注的关键词大都为“在线教育”“教育成本”“政策支持”等名词、形容词和动词的相互组合而成的短语,分词工具在分词的时候直接把这些短语进行了切分。因此上述2种无监督方法无法建模短语边界信息,在教育类文献上的关键词抽取效果不佳。无监督方法如SIFRank利用正则表达式抽取短语以及引入预训练语言模型ELMo表征文本表示,因此其在关键抽取效果上优于TFIDF和TextRank方法,但是其通过正则表达式抽取短语的方法会在候选关键词集合中引入大量噪声数据,所以导致后续关键词抽取的效果不佳。LR-SGD是基于有监督的机器学习方法,其能人工定义多种特征并通过迭代训练获得这些特征的最优组合,但是其候选关键词同样基于分词的结果,无法抽取建模短语边界信息,导致其在教育文献上的关键词抽取效果也不佳。HMM和CRF方法将关键词视为序列标注任务,避免了因分词导致的词语边界错误问题,让关键词抽取任务的准确率得到了大幅度的提升,但在CSL数据集上HMM和CRF方法的效果并没有得到很大提升,这是因为CSL方法标注的数据比较稀疏,HMM和CRF方法很难学习到有用的信息。BiLSTM-CRF方法是在CRF模型的基础上结合深度学习模型BiLSTM,这种结合既能够利用BiLSTM捕捉上下文信息,又能够利用CRF处理标签之间的依赖关系。但是BiLSTM-CRF是通过随机初始化字符向量并在训练过程中调整其值的方法抽取字符特征,其效果依赖大规模的语料训练,在训练数据集较少的情况下该方法的特征提取和表示效果无法达到理想效果。BERT-KPE和KIEMP方法都是利用BERT语言模型获取字向量再进行后续的关键词抽取工作,在数据量较少的CEKED数据集的F值比BiLSTM-CRF方法提升了至少16.30%,这说明与传统字向量表示方法相比,BERT等大规模预训练语言模型生成的字向量具有更丰富、更深层的语义信息,能提升自然语言处理下游任务的性能。

实验结果进一步表明了引入领域自适应模块可以弥补通用语言模型获得表示和特定领域数据之间的差距,帮助模型更好地适应特定的领域;引入视觉语义增强表示模块可以增强方法的语义表征能力,从而提高后续关键词抽取任务的准确性。

4.2 消融实验设计消融实验以验证所提MIEnhance-KPE方法的有效性,在CSL数据集和CEKED数据集上的消融实验结果分别如表 6和表 7所示。其中“-w/o Adapter”“ -w/o Visual”“-w/o Adapter+Visual”分别表示不加入领域自适应模块、不加入视觉语义增强模块以及同时不加入上述2种模块的情况。由表可知,缺少领域自适应模块会让MIEnhance-KPE在CSL数据集上抽取3、5和10个关键词的F值分别下降了1.38%、0.66%、0.70%,在CEKED数据集上则分别下降了2.00%、0.85%、0.51%,这表明直接利用BERT-WWM获得的通用领域表示无法充分适应特定的下游领域任务;同时偏旁和部首信息有助于MIEnhance-KPE捕捉汉字的组成结构信息,缺乏该类信息可能会导致其无法捕捉汉字更细粒度的特征,从而影响了关键词抽取的准确性。

| % | |||||||||||||||||||||||||||||

| 方法 | CSL数据集 | ||||||||||||||||||||||||||||

| P@3 | P@5 | P@10 | R@3 | R@5 | R@10 | F@3 | F@5 | F@10 | |||||||||||||||||||||

| MIEnhance-KPE | 46.88 | 46.91 | 46.74 | 44.58 | 50.58 | 52.48 | 45.70 | 48.68 | 49.44 | ||||||||||||||||||||

| -w/o Adapter | 46.00 | 46.72 | 46.43 | 42.75 | 49.39 | 51.29 | 44.32 | 48.02 | 48.74 | ||||||||||||||||||||

| -w/o Visual | 44.96 | 46.09 | 46.00 | 42.05 | 48.93 | 51.47 | 43.46 | 47.47 | 48.58 | ||||||||||||||||||||

| -w/o Adapter+Visual | 43.95 | 44.68 | 44.66 | 41.22 | 47.75 | 50.13 | 42.54 | 46.16 | 47.24 | ||||||||||||||||||||

| % | |||||||||||||||||||||||||||||

| 方法 | CEKED数据集 | ||||||||||||||||||||||||||||

| P@3 | P@5 | P@10 | R@3 | R@5 | R@10 | F@3 | F@5 | F@10 | |||||||||||||||||||||

| MIEnhance-KPE | 78.76 | 74.07 | 67.59 | 23.74 | 37.12 | 59.20 | 36.48 | 49.46 | 63.12 | ||||||||||||||||||||

| -w/o Adapter | 74.51 | 72.75 | 63.65 | 22.43 | 36.50 | 61.60 | 34.48 | 48.61 | 62.61 | ||||||||||||||||||||

| -w/o Visual | 70.92 | 70.59 | 65.85 | 21.35 | 35.44 | 59.10 | 32.82 | 47.19 | 62.29 | ||||||||||||||||||||

| -w/o Adapter+Visual | 58.50 | 60.39 | 62.98 | 17.61 | 30.29 | 58.59 | 27.07 | 40.34 | 60.71 | ||||||||||||||||||||

缺乏视觉语义增强表示模块让MIEnhance-KPE在CSL数据集上抽取3、5和10个关键词的值分别下降了2.24%、1.21%、0.86%,在CEKED数据集上则分别下降了3.66%、2.27%、0.83%,这表明汉字图像信息有助于方法理解汉字的形态特征,缺乏图像信息可能导致模型在处理相似字形时出现混淆,进而影响了关键词抽取的准确性。

同时缺乏领域自适应与视觉语义增强表示模块会让MIEnhance-KPE的性能下降更明显,在CSL数据集上抽取3、5和10个关键词的F值分别下降了3.16%、2.52%、2.22%,在CEKED数据集上则分别下降了9.41%、9.12%、2.41%,这表明同时缺乏这2个模块会导致方法在处理汉字时的理解能力显著下降,从而严重影响关键词抽取的性能。进一步证实了领域自适应与视觉语义增强表示模块的加入能帮助方法更好地适应特定领域和捕捉到文字丰富的语义信息,提高后续关键词抽取任务的准确性。

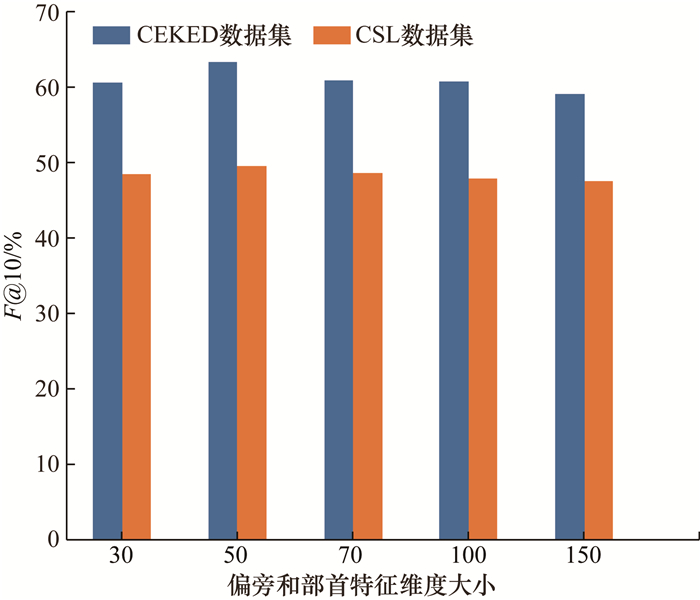

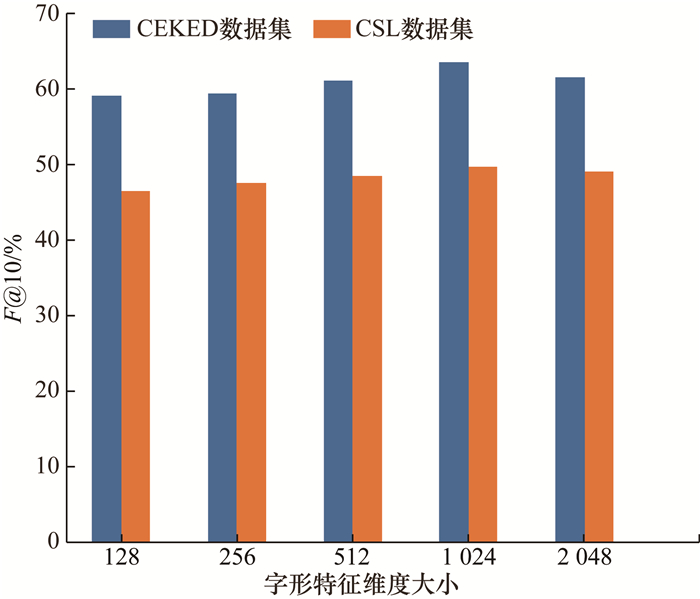

4.3 相关参数分析进一步探究不同偏旁和部首特征维度大小与字形特征维度大小对关键词抽取效果的影响。将偏旁和部首特征维度大小设置为30、50、70、100、150进行实验,由图 3可以看出,当偏旁和部首特征大小设置为50时,关键词抽取效果最佳;将字形特征维度大小设置为128、256、512、1 024、2 048进行实验,由图 4可以看出,当字形特征大小设置为1 024时,关键词抽取效果最佳。结合图 3和图 4可以看出,如果将偏旁和部首特征维度大小和字形特征维度大小设置过小,可能无法全面地描述一个汉字的语义信息,导致关键词抽取的效果不佳。如果将偏旁和部首特征维度大小与字形特征维度大小设置过大,可能会引入过多的噪声,影响关键词抽取的准确性。因此,需要选择合适的偏旁和部首特征维度大小和字形特征维度大小,以达到最佳的关键词抽取效果。

|

| 图 3 不同偏旁和部首特征维度大小的抽取结果 |

|

| 图 4 不同字形特征维度大小的抽取结果 |

4.4 融合策略探索

为了探索视觉特征与语义特征的融合策略,分析了3种融合策略分别应用在CSL数据集和CEKED数据集上的P、R和F值,结果如表 8和表 9所示。可以看出,基于“Concat+Linear”策略的关键词抽取方法准确率最低,这主要是由于汉字的图像特征和语义特征来自2个完全不同的特征空间,直接将不同模态的特征在通道维度上进行拼接再经过线性层,没有考虑到不同模态之间的交互和依赖关系。Add策略对不同模态特征进行元素加法运算,增加了特征表示的信息密度,因此其效果通常优于“Concat+Linear”策略。但是只有当2个模态的特征在语义上较为相似时,Add策略才能够有效地结合它们的信息,因此其关键词抽取准确率低于Attention策略。基于Attention策略取得的关键词抽取效果最好,主要原因是汉字的图像特征存在一定的噪声,运用Attention策略可以允许方法根据输入文本中每个汉字的语义特征和视觉特征来分配不同的关注度,实现不同特征的自适应融合,从而提高关键词抽取任务的准确率。

| % | |||||||||||||||||||||||||||||

| 融合策略 | CSL数据集 | ||||||||||||||||||||||||||||

| P@3 | P@5 | P@10 | R@3 | R@5 | R@10 | F@3 | F@5 | F@10 | |||||||||||||||||||||

| Concat+Linear | 37.14 | 38.13 | 38.04 | 31.40 | 36.06 | 37.12 | 34.03 | 37.07 | 37.57 | ||||||||||||||||||||

| Add | 45.92 | 46.43 | 46.22 | 43.11 | 49.07 | 50.74 | 44.47 | 47.71 | 48.37 | ||||||||||||||||||||

| Attention | 46.88 | 46.91 | 46.74 | 44.58 | 50.58 | 52.48 | 45.70 | 48.68 | 49.44 | ||||||||||||||||||||

| % | |||||||||||||||||||||||||||||

| 融合策略 | CEKED数据集 | ||||||||||||||||||||||||||||

| P@3 | P@5 | P@10 | R@3 | R@5 | R@10 | F@3 | F@5 | F@10 | |||||||||||||||||||||

| Concat+Linear | 61.44 | 55.78 | 50.82 | 18.49 | 27.97 | 47.76 | 28.43 | 37.26 | 49.24 | ||||||||||||||||||||

| Add | 78.43 | 73.33 | 66.07 | 23.63 | 36.82 | 59.53 | 36.32 | 49.02 | 62.63 | ||||||||||||||||||||

| Attention | 78.76 | 74.07 | 67.59 | 23.74 | 37.12 | 59.20 | 36.48 | 49.46 | 63.12 | ||||||||||||||||||||

5 结论

针对现有的中文关键词抽取方法难以领域自适应以及语义表征能力有限的问题,本文提出了一种多模态信息增强表示的中文关键词抽取方法MIEnhance-KPE。该方法首先使用Adapter层引入偏旁和部首信息微调预训练语言模型,然后使用交叉注意力机制引入汉字图像信息增强文本语义表示,最后利用CRF(conditional random field)模型进行序列标注任务,并计算候选关键词的位置-词频权重对其进行排序获得关键词。在公开的CSL数据集上和自构建的教育类CEKED数据集上进行方法的对比实验和方法所提模块的消融实验,结果表明微调预训练语言模型和引入多模态信息增强表示能够有效提高关键词抽取任务的效果。本文所提的多模态信息增强表示的关键词抽取方法有助于教育研究工作者快速检索文献、迅速了解教育发展的前沿动态和热点,为教育改革创新的动因分析提供数据基础,进而推动教育领域的数字化转型进程。

| [1] |

赵京胜, 朱巧明, 周国栋, 等. 自动关键词抽取研究综述[J]. 软件学报, 2017, 28(9): 2431-2449. ZHAO J S, ZHU Q M, ZHOU G D, et al. Review of research in automatic keyword extraction[J]. Journal of Software, 2017, 28(9): 2431-2449. (in Chinese) |

| [2] |

胡少虎, 张颖怡, 章成志. 关键词提取研究综述[J]. 数据分析与知识发现, 2021, 5(3): 45-59. HU S H, ZHANG Y Y, ZHANG C Z. Review of keyword extraction studies[J]. Data Analysis and Knowledge Discovery, 2021, 5(3): 45-59. (in Chinese) |

| [3] |

DING N, QIN Y J, YANG G, et al. Parameter-efficient fine-tuning of large-scale pre-trained language models[J]. Nature Machine Intelligence, 2023, 5(3): 220-235. DOI:10.1038/s42256-023-00626-4 |

| [4] |

YIN M W, MOU C J, XIONG K N, et al. Chinese clinical named entity recognition with radical-level feature and self-attention mechanism[J]. Journal of Biomedical Informatics, 2019, 98: 103289. DOI:10.1016/j.jbi.2019.103289 |

| [5] |

WANG S N, KHABSA M, MA H. To pretrain or not to pretrain: examining the benefits of pretrainng on resource rich tasks [C]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. New York, USA: ACL Press, 2020: 2209-2213.

|

| [6] |

MENG Y X, WU W, WANG F, et al. Glyce: Glyph-vectors for Chinese character representations [C]//Proceedings of the 33rd International Conference on Neural Information Processing Systems (NeurIPS 2019). Vancouver, Canada: Curran Associates Inc., 2019: 2746-2757.

|

| [7] |

XUAN Z Y, BAO R, JIANG S Y. FGN: Fusion glyph network for Chinese named entity recognition [C]//5th China Conference on Knowledge Graph and Semantic Computing: Knowledge Graph and Cognitive Intelligence. Nanchang, China: Springer Press, 2021: 28-40.

|

| [8] |

SALTON G, BUCKLEY C. Term-weighting approaches in automatic text retrieval[J]. Information Processing & Management, 1988, 24(5): 513-523. |

| [9] |

庞庆华, 董显蔚, 周斌, 等. 基于情感分析与TextRank的负面在线评论关键词抽取[J]. 情报科学, 2022, 40(5): 111-117. PANG Q H, DONG X W, ZHOU B, et al. Keyword extraction of negative online reviews based on sentiment analysis[J]. Information Science, 2022, 40(5): 111-117. (in Chinese) |

| [10] |

马慧芳, 刘芳, 夏琴, 等. 基于加权超图随机游走的文献关键词提取算法[J]. 电子学报, 2018, 46(6): 1410-1414. MA H F, LIU F, XIA Q, et al. Extraction algorithm based on weighted hypergraph random walk[J]. Acta Electronica Sinica, 2018, 46(6): 1410-1414. (in Chinese) |

| [11] |

TERRYN A R, DROUIN P, HOSTE V, et al. Analysing the impact of supervised machine learning on automatic term extraction: HAMLET vs TermoStat [C]//Proceedings of the International Conference on Recent Advances in Natural Language Processing. Varna, Bulgaria: INCOMA Ltd. Press, 2019: 1012-1021.

|

| [12] |

ZHANG C Z, WANG H L, LIU Y, et al. Automatic keyword extraction from documents using conditional random fields[J]. Journal of Computational Information Systems, 2008, 4(3): 1169-1180. |

| [13] |

ARDIANSYAH S, MAJID M A, ZAIN J M. Knowledge of extraction from trained neural network by using decision tree [C]//Proceedings of 20162nd International Conference on Science in Information Technology (ICSITech). Balikpapan, Indonesia: IEEE Press, 2016: 220-225.

|

| [14] |

CHAN H P, CHEN W, WANG L, et al. Neural keyphrase generation via reinforcement learning with adaptive rewards [C]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence, Italy: ACL Press, 2019: 2163-2174.

|

| [15] |

CHEN W, CHAN H P, LI P J, et al. Exclusive hierarchical decoding for deep keyphrase generation [C]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. New York, USA: ACL Press, 2020: 1095-1105.

|

| [16] |

ZHANG Y Y, ZHANG C Z. Using human attention to extract keyphrase from microblog post [C]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence, Italy: ACL Press, 2019: 5867-5872.

|

| [17] |

曾道建, 童国维, 戴愿, 等. 基于序列到序列模型的法律问题关键词抽取[J]. 清华大学学报(自然科学版), 2019, 59(04): 256-261. ZENG D J, TONG G W, DAI Y, et al. Keyphrase extraction for legal questions based on a sequence to sequence model[J]. Journal of Tsinghua University (Science and Technology), 2019, 59(4): 256-261. (in Chinese) |

| [18] |

ZHANG Q, WANG Y, GONG Y Y, et al. Keyphrase extraction using deep recurrent neural networks on Twitter [C]//Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Austin, Texas: ACL Press, 2016: 836-845

|

| [19] |

孙新, 盖晨, 申长虹, 等. 基于短语向量和主题加权的关键词抽取方法[J]. 电子学报, 2021, 49(9): 1682-1690. SUN X, GAI C, SHEN C H, et al. The theme-weighted keyphrase extraction algorithm based on phrase embedding[J]. Acta Electronica Sinica, 2021, 49(9): 1682-1690. (in Chinese) |

| [20] |

SAHRAWAT D, MAHATA D, ZHANG H M, et al. Keyphrase extraction as sequence labeling using contextualized embeddings [C]//42nd European Conference on IR Research on Advances in Information Retrieval (ECIR). Lisbon, Portugal: Springer, 2020: 328-335.

|

| [21] |

ZHANG L H, CHEN Q, WANG W, et al. MDERank: A masked document embedding rank approach for unsupervised keyphrase extraction [C]//Proceedings of the 2022 Conference on Empirical Methods in Natural Language Processing. Dublin, Ireland: ACL Press, 2022: 396-409.

|

| [22] |

SUN S, XIONG C Y, LIU Z H, et al. Capturing global informativeness in open domain keyphrase extraction [C]//Proceedings of the Natural Language Processing and Chinese Computing. QingDao, China: Springer. Press, 2021: 275-287.

|

| [23] |

SONG M Y, FENG Y, JING L P. Hyperbolic relevance matching for neural keyphrase extraction [C]//Proceedings of the 2022 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Seattle, United States: ACL Press, 2022: 396-409.

|

| [24] |

DONG C H, ZHANG J J, ZONG C Q, et al. Character-based LSTM-CRF with radical-level features for Chinese named entity recognition [C]//Natural Language Under-standing and Intelligent Applications: 5th CCF Conference on Natural Language Processing and Chinese Computing and 24th International Conference on Computer Processing of Oriental Languages. Kunming, China: Springer International Press, 2016: 239-250.

|

| [25] |

HAN X K, YUE Q, CHU J, et al. Multi-feature fusion transformer for Chinese named entity recognition [C]//202241st Chinese Control Conference. Hefei, China: IEEE Press, 2022: 4227-4232.

|

| [26] |

WU S, SONG X N, FENG Z H. MECT: Multi-metadata embedding based cross-transformer for Chinese named entity recognition [C]//Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing. New York, USA: ACL Press, 2021: 1529-1539.

|

| [27] |

CHEN H Y, YU S H, LIN S D. Glyph2Vec: Learning Chinese out-of-vocabulary word embedding from glyphs [C]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. New York, USA: ACL Press, 2020: 2865-2871.

|

| [28] |

CUI Y M, CHE W X, LIU T, et al. Pre-training with whole word masking for Chinese BERT [C]//Proceedings of IEEE/ACM Transactions on Audio, Speech, and Language Processing. Balikpapan, Indonesia: IEEE Press, 2021: 3504-3514.

|

| [29] |

SUN Y, QIU H, ZHENG Y, et al. SIFRank: a new baseline for unsupervised keyphrase extraction based on pre-trained language model[J]. IEEE Access, 2020, 8: 10896-10906. |

| [30] |

LI Y D, ZHANG Y Q, ZHAO Z, et al. CSL: A large-scale Chinese scientific literature dataset [C]//Proceedings of the 29th International Conference on Computational Linguistics. Gyeongju, Republic of Korea: International Committee on Computational Linguistics Press, 2022: 3917-3923.

|

| [31] |

WU X Y, BOLIVAR A. Keyword extraction for contextual advertisement [C]//Proceedings of the 17th international conference on World Wide Web. New York, USA: ACM Press, 2008: 1195-1196.

|

| [32] |

WANG J J, XU C S, CHNG E, et al. Sports highlight detection from keyword sequences using HMM [C]//2004 IEEE International Conference on Multimedia and Expo. Taipei, China: IEEE, 2004: 599-602.

|

| [33] |

GERO Z, HO J. Word centrality constrained representation for keyphrase extraction [C]//Proceedings of the 20th Workshop on Biomedical Language Processing. New York, USA: ACL Press, 2021: 155-161.

|

| [34] |

SONG M Y, XIAO L, JING L P. Learning to extract from multiple perspectives for neural keyphrase extraction[J]. Computer Speech & Language, 2023, 81: 101502. |