2. 清华大学 工程物理系, 公共安全研究院, 北京 100084

2. Institute of Public Safety Research, Department of Engineering Physics, Tsinghua University, Beijing 100084, China

古建筑是古代人类智慧的结晶,是人类保存有限且珍贵的卓越文化遗产之一[1]。然而,2010—2022年,古建筑火灾事件频发,这些火灾事件不仅造成了巨大的财产损失,还威胁着宝贵的古建筑文化遗产[2]。以2010年3月21日福建鼓山风景区火灾为例,该事件由夜间驾车上山的游客随意丢弃烟蒂引发。类似地,2011年2月1日湖北道观河景区的火灾同样源于游客乱扔烟蒂[3]。此外,在许多未查明原因的古建筑火灾案例中,消防危险品(如烟蒂)通常是潜在的引火源。

针对古建筑防火问题,许多学者开展了一系列研究。李园园[4]提出了一种评估指标体系框架以梳理火灾危险源的构成,并利用改进的Gustav法对古建筑群进行火灾风险评估,采用建筑信息模型(building information modeling,BIM) 建立古建筑火灾风险数据库,实现了动态信息化管理。熊倩[5]在古建筑修缮现场布置了监测点位,提出了一种基于YOLO (you only look once) 算法的火灾图像检测算法,利用建模技术验证火灾监测方法有效。韩嘉兴[6]调研了古建筑火灾荷载,通过开展移动式高压细水雾防火分隔试验和仿真模拟,对比分析火灾蔓延的情况。Helfers[7]使用单一变量法研究了影响多个火源燃烧的因素,包括点火源数量及其排列模式等,并总结了多点火源在结构建筑火灾中的燃烧行为。学者们使用的大部分火灾风险评估研究方法主观性强、识别率低,影响因素的权重取值易受人为因素影响,模型精度难以满足实际应用要求。火灾监测预防的研究缺乏及时性和有效性[8]。

对于古建筑火灾,通常使用火灾报警系统报警,但这仍然无法高效地避免火灾、降低火灾损失,为解决此问题可将单一的火灾报警转向火灾预警。He等[9]提出了一种结合注意力机制、特征层和决策层融合模块的雾环境下烟雾检测方法。Zhang等[10]提出一种利用视觉注意机制进行火灾探测与识别的方法,由于古建筑通常位于偏远山区,缺乏足够的消防人员和水源,且存在火灾防护不足的问题,火灾难以控制和扑灭[11],因此,将抢救性保护转向预防性保护至关重要。与直接探测火灾及烟雾不同,检测香烟等消防危险品能有效从源头控制火灾,基于监控设备的目标检测算法能保证实时检测预警。及时发现潜在火灾危险并采取措施加以预防,将带来巨大的经济和社会效益。

目标检测算法大多依托于监控拍摄的视频图像,监控中分辨率低的图像会严重影响模型的检测精度,因此检测前需要重建优化图像。此外,面对多场景部署及实时预警需求,应同时保证模型精度及模型尺寸。

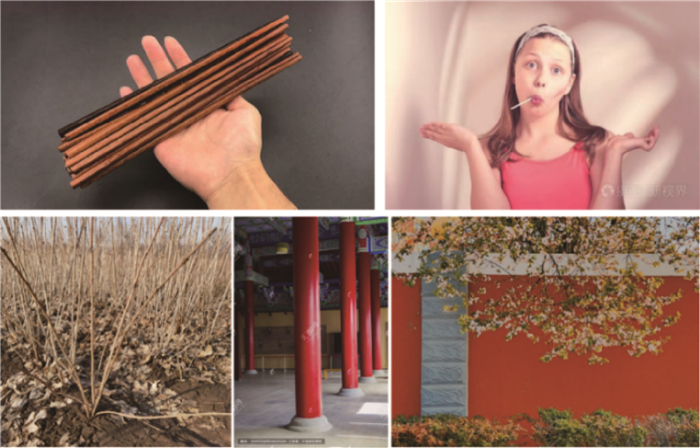

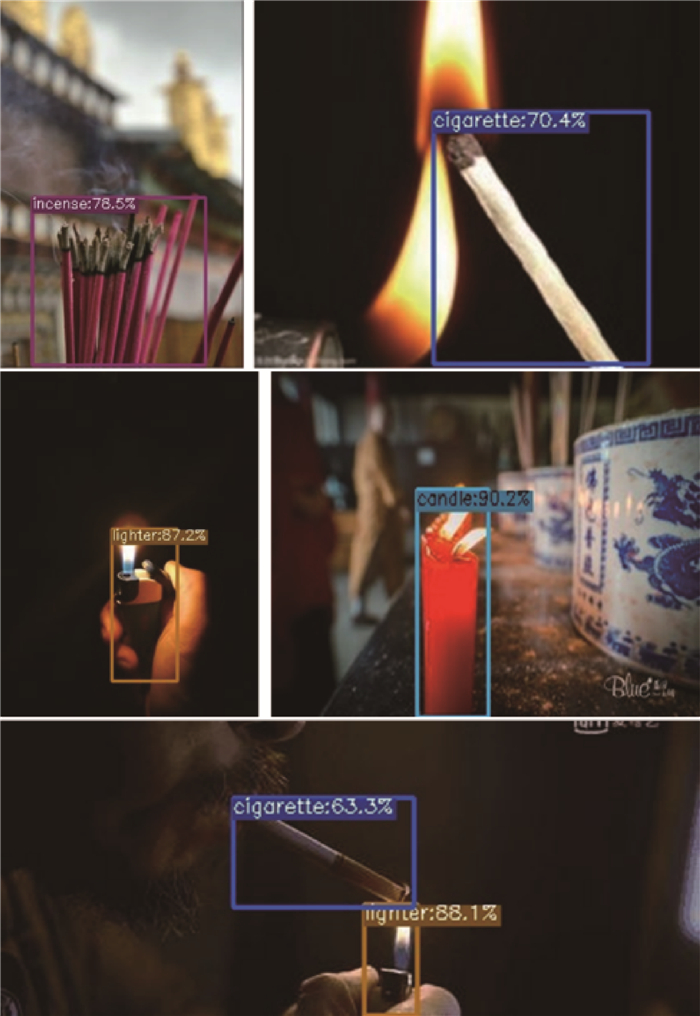

1 消防危险品检测方法 1.1 数据集构建本研究的数据主要来自前期研究构建的图像数据集、收集的网络图片以及自主拍摄的各类图片。数据集覆盖不同环境条件,包括白天、黑夜、室内和室外等,同时涵盖了不同角度、单一危险品目标和多个危险品目标,以确保目标检测模型在实际场景中应用准确。为使数据集图片的背景与文物古建筑环境相符,拍摄了背景颜色或材质与古建筑相似的图片,以确保目标图像的多样性和逼真性。图 1展示了数据集中的代表性图像。

|

| 图 1 部分消防危险品代表性图像样本 |

为提升模型在复杂环境下的识别能力,需要深入探索危险品图像中的“困难”样本。这类“困难”样本包括小尺寸目标,同时也涵盖了与打火机、烟蒂等危险品相似的视觉干扰物。图 2展示了部分与危险品相似的干扰图像样本。

|

| 图 2 部分干扰图像样本 |

整个格式为VOC的数据集包含7 157张危险品图像和6 536张非危险品图像,其中训练集10 956张,验证集2 737张;训练集与验证集的比例约为8∶2,具体如表 1所示。

| 张 | |||||||||||||||||||||||||||||

| 类别 | 训练集 | 验证集 | 合计 | ||||||||||||||||||||||||||

| 打火机 | 1 416 | 354 | 1 770 | ||||||||||||||||||||||||||

| 火柴棒 | 742 | 185 | 927 | ||||||||||||||||||||||||||

| 烟蒂 | 1 095 | 273 | 1 368 | ||||||||||||||||||||||||||

| 蜡烛 | 1 210 | 302 | 1 512 | ||||||||||||||||||||||||||

| 香 | 1 264 | 316 | 1 580 | ||||||||||||||||||||||||||

| 负样本 | 5 229 | 1 307 | 6 536 | ||||||||||||||||||||||||||

| 合计 | 10 956 | 2 737 | 13 693 | ||||||||||||||||||||||||||

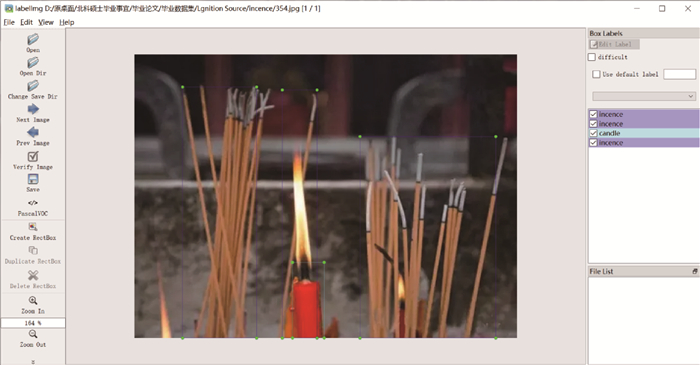

获取和筛选数据集后,选用LabelImg图像标注软件及PASCAL VOC数据集格式,对数据集中的目标检测对象进行矩形边界框标注,如图 3所示。

|

| 图 3 消防危险品数据集标注示意图 |

另外,本研究对数据集中的文物古建筑消防危险品进行了详细的数据分析,数据量统计结果如图 4a所示。图 4b显示了每个物体边界框的位置和大小,图中橙色方框表示边界框的位置。图 4c中显示了危险品的中心点坐标(x, y),图像中心的颜色较深且数据点密集,说明大部分数据集图像中的消防危险品位于图像中心,并且具有完整的特征。图 4d显示了危险品的高度和宽度,数据以物体宽高与图像宽高的归一化值呈现。数据图的左下角颜色较深且数据点分布密集,表明目标检测中的小目标危险品占比较大。

|

| 图 4 文物古建筑消防危险品数据集信息统计 |

1.2 损失函数的改进

相较于其他YOLO算法版本,YOLOv5算法更加适用于移动应用、轻量化模型,且具有快速检测能力[12],此外,YOLOv5s算法的模型尺寸仅为14 MB,适用于嵌入式设备的部署和检测。综合考虑模型尺寸、推理速度,即检测速度和计算成本等因素,选择YOLOv5s算法作为基准模型检测消防危险品图像。在模型的损失函数方面,与交并比(intersection over uniou, IoU)的损失LIoU相比,全局交并比(generalized intersection over union, GIoU)的损失LGIoU能反映目标之间的距离信息,可在不重叠的目标之间建立关系。交集面积与并集面积的比值I及LIoU、LGIoU的公式表示如下[9]:

| $ I=\frac{A \cap B}{A \cup B}, $ | (1) |

| $ L_{\mathrm{IoU}}=1-I, $ | (2) |

| $ L_{\mathrm{GloU}}=1-I+\frac{K-A \cup B}{K} . $ | (3) |

其中:A表示预测框的面积,B表示真实框的面积,K表示预测框与真实框的最小外接矩形面积。由式(3)可知,当真实框与预测框之间的距离增加时,K也随之增加,同时K与A∪B的差异也增大,表明LGIoU可反映真实框与预测框之间的距离信息。

GIoU算法修复了IoU的一些问题,但当真实框完全包含预测框时,A∪B的值等于K,这会导致式(3)中的最后一项变为0,使LGIoU退化为LIoU。因此,本研究采用完整交并比(complete intersection over union, CIoU) 算法优化YOLOv5的损失函数。综合考虑中心点距离和长宽比的方式可准确地评估预测框的质量,从而使目标框的回归更加稳定和准确。此外,CIoU算法的收敛速度快,加速了训练过程,进一步提高了目标检测模型的性能。CIoU的损失LCIoU公式表示如下[13]:

| $ L_{\mathrm{CloU}}=1-I+\frac{p^2\left(b, b_{\mathrm{gt}}\right)}{c^2}+\alpha v, $ | (4) |

| $ \alpha=\frac{v}{(1-I)+v}, $ | (5) |

| $ v=\frac{4}{\pi^2}\left(\arctan \frac{w_{\mathrm{gt}}}{h_{\mathrm{gt}}}-\arctan \frac{w}{h}\right)^2 . $ | (6) |

其中:b和bgt分别表示预测框和真实框的中心点,Euclid距离p2(b,bgt)用于衡量这些点之间的距离; c表示能同时包含预测框和真实框的最小外接矩阵的对角线距离; α表示权重函数; v表示修正因子,可进一步调整损失函数,考虑目标框的形状和方向, 用于度量宽高比的一致性;wgt、hgt、w和h分别表示真实框和预测框的宽、高信息。CIoU在GIoU的基础上加入长宽比信息以衡量真实框和预测框之间的位置关系,提升了预测框的回归效果。

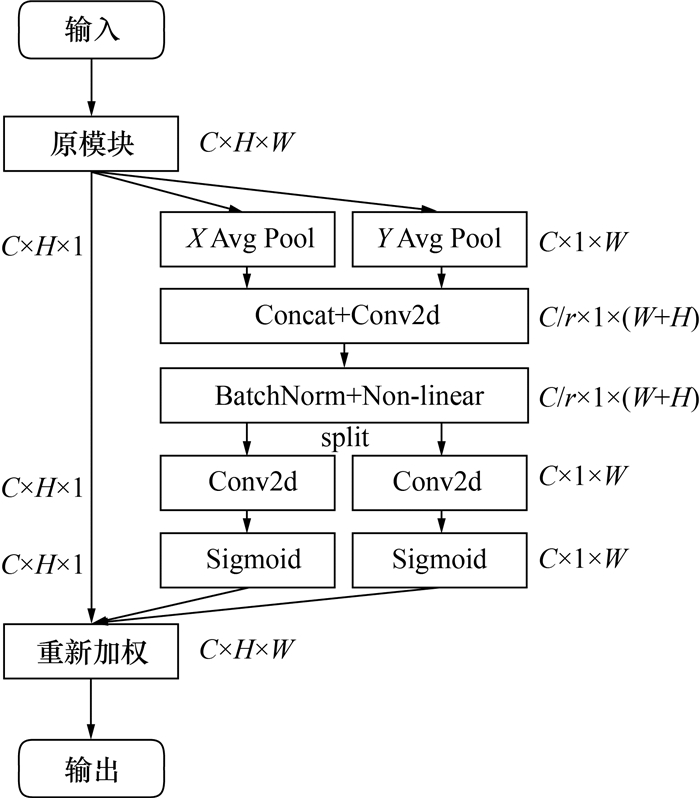

1.3 坐标注意力机制本节中引入了坐标注意力机制(coordinate attention,CA)[14]到YOLOv5的主干网络中。在目标检测中,位置信息至关重要,因此使用CA机制补充位置信息,CA模块首先降低特征图的通道数以增大感受野,然后通过学习得到通道的权重分布,最后使用这些参数重新分配通道特征。CA能够解决特征图和通道的权重分布不匹配的问题,进一步提升了检测精度。CA机制的网络结构如图 5所示。图 5中X Avg Pool表示对特征图宽度W方向做平均池化;Y Avg Pool表示对特征图高度H方向做平均池化;Concat表示横向连接操作;Conv2d表示二维数据上的卷积层;BatchNorm表示批归一化层;Non-linear表示全连接层+Relu激活函数;split表示分支操作;Sigmoid表示激活函数;C×H×W表示数据形式,其中C代表通道数;r表示缩减率,缩减特征图的通道维度。

1.4 SRGAN图像超分

图像超分辨率生成对抗网络(super-resolution generative adversarial network,SRGAN)是一种基于生成对抗网络(generative adversarial network,GAN)的超分辨率重建算法,使生成的图像更符合人类视觉感知[15]。

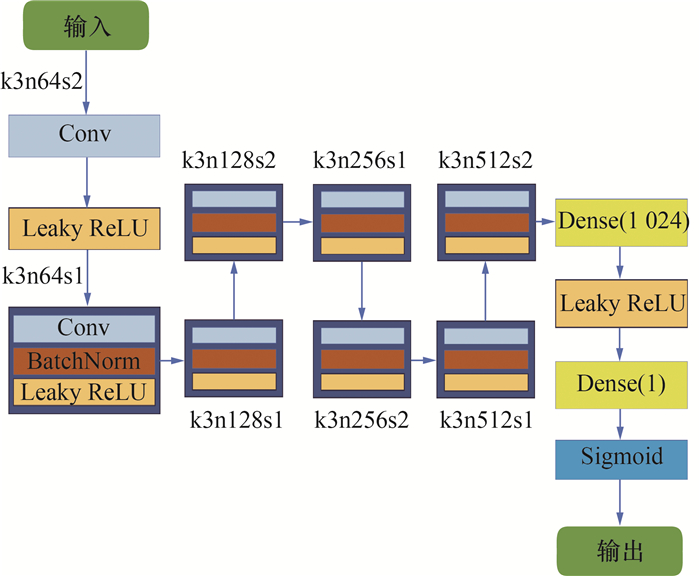

SRGAN采用反卷积层进行上采样,并使用tanh激活函数限制输出范围,通过Sigmoid函数输出图像的真伪概率判别网络。生成网络和判别网络交替训练,生成网络最小化图像与实际图像之间的均方误差(mean-square error,MSE),同时最大化判别网络的输出损失,从而学习生成更真实、分辨率更高的图像的能力。SRGAN判别器模型的结构如图 6所示。图 6中Conv表示卷积层,Leaky ReLU表示激活函数,Dense表示全连接层,k后的数字表示卷积核的尺寸,n后面的数字表示卷积输出的通道数,s后面的数字表示步长。

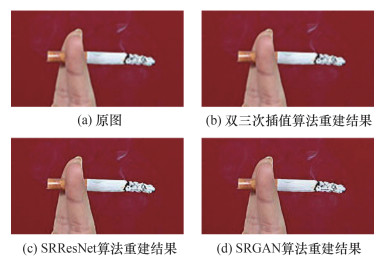

图 7显示了经过双三次插值、SRResNet及SRGAN算法处理前后的烟蒂图像。相对于双三次插值和SRResNet算法,SRGAN消除了原始图像的模糊感,重建后的图像更自然,提高了数据集图片的质量。使用SRGAN重建图片操作更简便,可逼真地还原烟蒂的细节纹理,使重建的图像在视觉上与真实图像更加接近。

|

| 图 7 图像重建结果对比 |

2 检测结果与分析 2.1 实验环境搭建

本文的模型训练在DELL Precision 7920服务器上进行,服务器系统为Windows Server2019,并配有64 GB内存的Inter(R)Xeon(R) Gold 6230 @2.1 GHz CPU和10 G显存的NVIDIA GeForce RTX3080 GPU。实验的软件环境为Anaconda 4.10.1科学计算包、Pytorch 1.8.1深度学习框架和Python 3.8,并采用CUDA11.1在训练过程中加速GPU。

基于SRGAN算法的消防危险品检测模型在模型训练过程中的超参数设置如表 2所示,优化过程采用ADAM优化算法。

| 参数 | 取值 |

| 初始学习率 | 0.01 |

| 最终学习率 | 0.10 |

| 梯度下降动量(momentum) | 0.94 |

| 权重预热批次 | 4.00 |

| 训练轮次(epochs) | 100.00 |

| 权重衰减系数 | 0.000 4 |

| 每轮训练批次尺寸(batch size) | 16.00 |

| 边界框损失系数 | 0.05 |

| 分类损失系数 | 0.50 |

| 目标性损失 | 1.10 |

2.2 模型检测结果

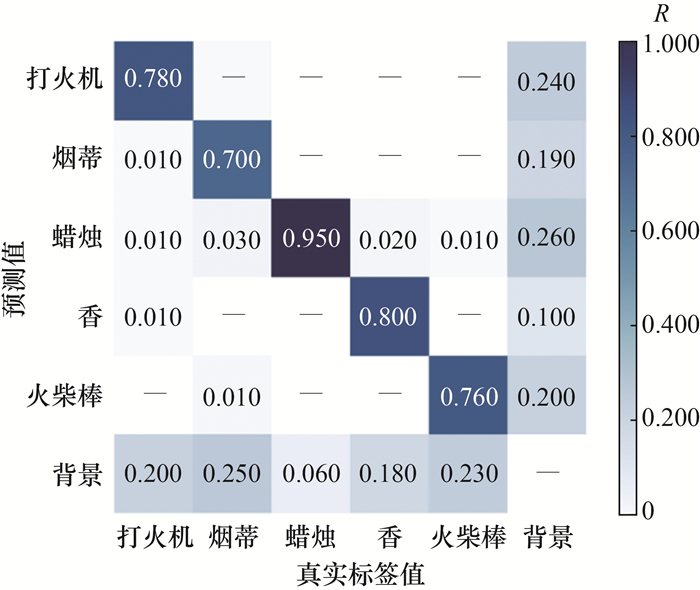

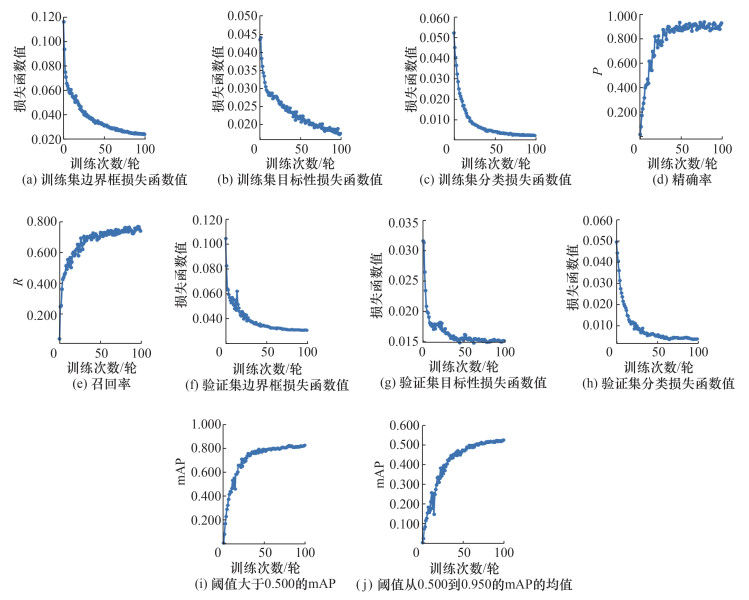

本文使用混淆矩阵评估消防危险品检测模型,如图 8所示,将图片中的所有数值在纵坐标上进行了归一化处理,对角线上的数值是各类别的召回率。检测模型在一定程度上存在误差,会将一部分背景错误地识别为消防危险品。原因是消防危险品数据集中包含许多小目标物体,有些图像中还同时出现多个危险品,导致检测结果的准确率降低。图 9展示了古建筑消防危险品检测模型在各项指标上的结果。训练结果显示,随着训练次数增加,训练集的边界框回归损失(box_loss)、目标性损失(obj_loss)和分类损失(train_loss)逐渐趋于稳定,图像损失逐渐减小,最终达到预期训练目标。模型的精确率P、召回率R和平均精度均值(mean average precision, mAP)(阈值大于0.500)表现出色,分别达到了0.940、0.770和0.830。该模型在大部分涉及小尺度目标的古建筑消防危险品检测任务中取得了卓越的检测效果。

|

| 图 8 检测模型的混淆矩阵 |

|

| 图 9 检测模型训练结果 |

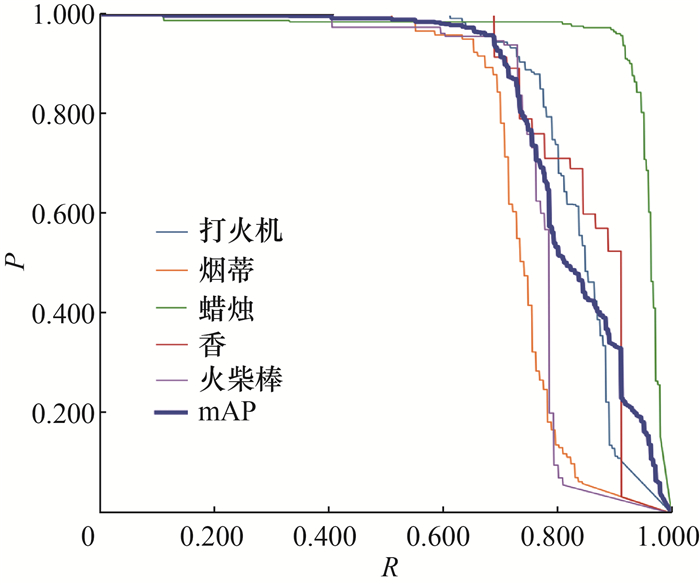

检测模型在验证集上的P-R(precision-recall)曲线如图 10所示,图中打火机、烟蒂、蜡烛、香和火柴棒的目标平均精确率为0.839、0.743、0.949、0.851和0.767,所有类别的目标mAP为0.830。

|

| 图 10 测模型训练的P-R曲线 |

将模型在验证集的首批图像上进行了测试,结果如图 11和12所示。图 11显示了模型的预测标签,可知模型清晰地标记了各个消防危险品目标。然而,在预测阶段仍然存在一些误检和漏检的情况,如图 12所示,在第2张图像中,蜡烛(candle)目标被错误标记为火柴(match)目标;在第一张图像中,虽然模型能正确识别蜡烛(candle),但未检测到烟蒂(cigarette)。此外,检测模型在小目标和被遮挡目标的检测方面表现出色。该检测模型对于困难样本的检测具有较高的准确性和鲁棒性。

|

| 图 11 第一个批次的预测标签结果 |

|

| 图 12 第一个批次的测试结果 |

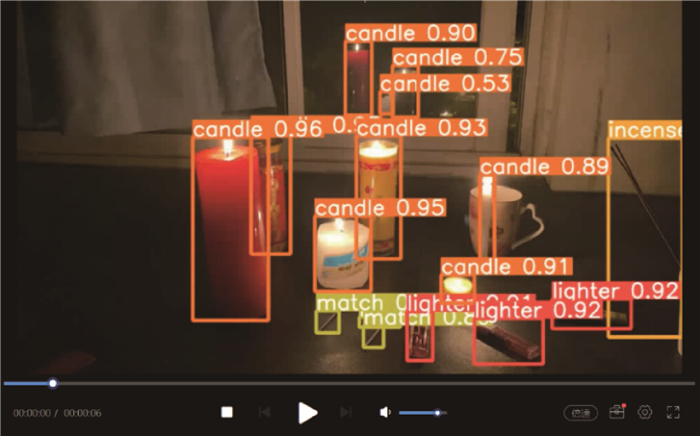

为了进一步验证模型的可行性,本文收集了消防危险品的图像和视频,验证结果如图 13和14所示。结果表明,模型能准确检测图像中危险品的类别并进行定位。而在视频中,尽管存在物体数量较多且物体之间相互重叠的现象,模型仍保持较高的准确率。由视频检测结果可知,蜡烛和打火机的检测准确率较高,原因是其在图像中占比较大;同时模型也能准确检验到火柴棒等小物体,表明本文提出的检测模型有效。

|

| 图 13 消防危险品图像验证效果图 |

|

| 图 14 消防危险品视频验证效果图 |

2.3 模型对比实验

为验证本研究中图像的超分辨率、网络结构优化和损失函数的改进对古建筑消防危险品检测模型mAP的影响,进行了一系列消融实验,并探究了各种优化策略的最佳组合,结果如表 3所示。消融实验结果表明,在基准模型的基础上,最佳优化策略使检测模型的mAP相较于基准模型提高了0.038,为0.830,具体结果如下:

| 模型 | mAP | mAP增长量 |

| YOLOv5 | 0.792 | — |

| YOLOv5+CIoU | 0.798 | 0.006 |

| YOLOv5+CIoU+CA | 0.819 | 0.027 |

| YOLOv5+CIoU+CA+SRGAN | 0.830 | 0.038 |

1) 引入CIoU损失函数平衡正负样本比例,使检测模型的mAP相较于基准模型提高了0.006;

2) 引入CIoU和CA,使检测模型的mAP相较于基准模型提升了0.027,因为CA更容易检测到数据集中的小尺寸消防危险品目标;

3) 引入SRGAN、CIoU和CA的图像超分技术提高了数据集中图像的质量,从而使检测模型相对于仅引入CIoU和CA的模型mAP提高了0.011,表明这一技术可有效检测古建筑消防危险品。

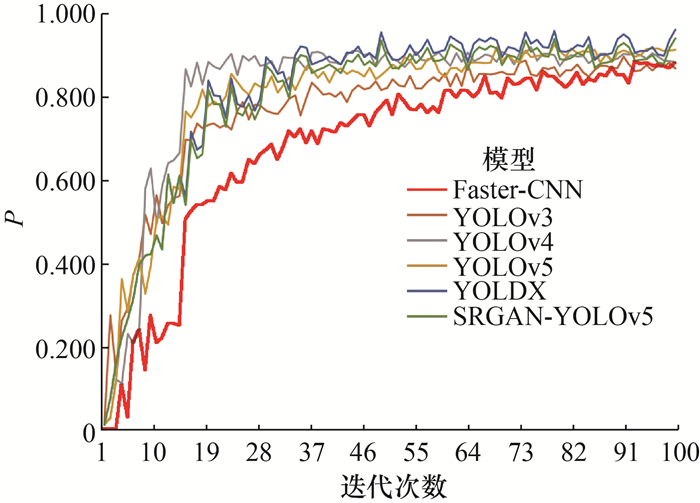

为评估本研究提出的基于CA和SRGAN结构,即CA-SRGAN的SRGAN-YOLOv5模型在图像检测中的性能,本研究将其与主流的目标检测网络进行了比较,包括Faster-RCNN(faster regions-convelutional neural network)[16],YOLOv3[17],YOLOv4[18]、YOLOv5和YOLOX[19]。由于各模型损失函数设计不同,比较损失变化曲线不具有实际意义,因此本文对各模型的精确率、多类别mAP、模型推理速度和模型尺寸等指标进行全面对比。在初期训练阶段,精确率存在较大波动,但随着训练进行,模型逐渐趋于稳定,精确率的波动减小,如图 15所示。在古建筑火灾检测任务中,对比了6个检测模型,其中YOLOX模型的检测精确率最高,其最高精确率为0.960,本文提出的古建筑消防危险品检测模型检测精准率位列第二,最高精确率达0.940。

|

| 图 15 训练过程中各模型精确率对比图 |

表 4为各个目标检测模型的模型参数尺寸、推理速度和mAP综合的对比结果。由表可知,近年来提出的目标检测模型YOLO系列在准确率方面的表现明显优于早期模型Faster系列。最新的YOLOX模型在本文的消防危险品检测任务中的mAP最高,但相应的模型尺寸大于本文提出的模型且推理速度也低于本文提出的模型。本文提出的检测模型在模型尺寸和推理速度上也基本优于其他4个模型,因此,对于实时检测任务而言,本文提出的检测模型在尺寸和推理速度方面具备优势。综合考虑各模型性能可知,本文提出的模型在消防危险品检测任务中具有显著优势和广阔的应用前景。

| 模型 | 模型尺寸/MB | 推理速度/fps | mAP@0.5 |

| Faster-RCNN | 47 | 56 | 0.768 |

| YOLOv3 | 38 | 68 | 0.783 |

| YOLOv4 | 32 | 72 | 0.784 |

| YOLOv5 | 22 | 73 | 0.792 |

| YOLOX | 29 | 78 | 0.842 |

| SRGAN-YOLOv5 | 24 | 92 | 0.830 |

| 注:mAP@0.5表示将IoU设为0.5时,每一个类别下所有图片的mAP。 | |||

3 结论

鉴于解决古建筑消防安全问题的紧迫性,本研究对此挑战提出并实施了一种基于深度学习的消防危险品图像智能检测方法,以下是主要结论:

1) 针对古建筑消防安全领域数据匮乏的问题,本研究创建了一个自制数据集,包括烟蒂、火柴棒、打火机、蜡烛和香等典型消防危险品图像。在构建过程中,充分考虑了不同环境因素,确保了图像的多样性,并利用LabelImg工具进行详细标注。

2) 采用基于对抗生成网络的SRGAN算法对图像进行预处理,从而提高图像质量和目标信息,为后续检测模型提供高质量输入。

3) 为提高模型对小目标和位置信息的感知能力,本研究在YOLOv5基础上引入了CA,以充分利用图像中的位置信息,增强对消防危险品的检测效果。

4) 为更准确地评估预测框的质量,本研究将YOLOv5中的GIoU替换为CIoU作为损失函数,联合多个几何因素计算框的位置关系,优化了模型的收敛速度。

5) 在自建数据集上训练检测模型,实现了对烟蒂、火柴棒、打火机、蜡烛和香等消防危险品的实时检测。模型的mAP和精确率分别达0.830和0.940,具备竞争力,例如,在服务器上运行时,模型推理速度可达92 fps。

虽然本研究取得了显著成果,但仍存在一些不足之处,如数据集规模较小和类别设置不够丰富。下一步工作将致力于扩大数据集规模,增加更多样本类别,以提高模型的泛化能力。此外,还将深入研究模型压缩和加速方法,提高计算效率,以促进消防危险品检测系统在更多古建筑场景中的应用和普及,同时考虑其与警报和主动灭火系统的集成。

| [1] |

白子龙. 木结构古建筑防火改造技术对策研究[D]. 沈阳: 沈阳建筑大学, 2017. BAI Z L. Study on technical measures for fire protection of wooden ancient buildings[D]. Shenyang: Shenyang Jianzhu University, 2017. (in Chinese) |

| [2] |

王鹏飞. 砖木结构古建筑(群)火灾模拟与风险预测研究[D]. 西安: 长安大学, 2018. WANG P F. The research of heritage building on fire simulation and risk prediction of brick and timber structures[D]. Xi'an: Chang'an University, 2018. (in Chinese) |

| [3] |

庄一凰. 风景名胜区防火措施研究[D]. 泉州: 华侨大学, 2012. ZHUANG Y H. Research on the fire prevention measure of scenic area[D]. Quanzhou: Huaqiao University, 2012. (in Chinese) |

| [4] |

李园园. 基于改进的半定量Gustav法的古建筑群火灾风险评估与管理[D]. 西安: 长安大学, 2019. LI Y Y. Fire risk assessment and management of ancient buildings based on improved semi-quantitative Gustav method[D]. Xi'an: Chang'an University, 2019. (in Chinese) |

| [5] |

熊倩. 基于YOLO-BP神经网络的古建筑修缮阶段火灾监测方法研究[D]. 西安: 西安建筑科技大学, 2021. XIONG Q. Research on monitoring method of fire in repair stage of ancient buildings based on YOLO-BP neural network[D]. Xi'an: Xi'an University of Architecture and Technology, 2021. (in Chinese) |

| [6] |

韩嘉兴. 古建筑消防性能化研究[D]. 北京: 北京建筑大学, 2018. HAN J X. Performance-based study on safty fire engineering for ancient building [D]. Beijing: Beijing University of Civil Engineering and Architecture, 2018. (in Chinese) |

| [7] |

HELFERS B. Wiederanbindung des historischen Hafens Bad Karlshafen an die Weser[J]. Bautechnik, 2017, 94(12): 861-867. DOI:10.1002/bate.201700073 |

| [8] |

赵平, 熊倩, 张鑫, 等. 基于YOLO-BP神经网络的古建筑修缮阶段火灾监测方法[J]. 中国安全生产科学技术, 2020, 16(12): 122-128. ZHAO P, XIONG Q, ZHANG X, et al. Monitoring method of fire in repair stage of ancient buildings based on YOLO-BP neural network[J]. Journal of Safety Science and Technology, 2020, 16(12): 122-128. (in Chinese) |

| [9] |

HE L J, GONG X L, ZHANG S R, et al. Efficient attention based deep fusion CNN for smoke detection in fog environment[J]. Neurocomputing, 2021, 434: 224-238. DOI:10.1016/j.neucom.2021.01.024 |

| [10] |

ZHANG H J, ZHANG N, XIAO N F. Fire detection and identification method based on visual attention mechanism[J]. Optik, 2015, 126(24): 5011-5018. DOI:10.1016/j.ijleo.2015.09.167 |

| [11] |

马万学. 古建筑消防安全分析评估及防火对策探讨[J]. 消防技术与产品信息, 2015(6): 12-16. MA W X. Analysis and evaluation of fire safety in ancient buildings and exploration of fire prevention measures[J]. Fire Technique and Products Information, 2015(6): 12-16. DOI:10.3969/j.issn.1002-784X.2015.06.004 (in Chinese) |

| [12] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA: IEEE, 2016: 779-788.

|

| [13] |

徐栋. 基于深度学习的电动车头盔佩戴检测系统的设计与实现[D]. 南京: 南京邮电大学, 2022. XU D. Design and implementation of electric bicycle helmet wearing detection system based on deep learning[D]. Nanjing: Nanjing University of Posts and Telecom- munications, 2022. (in Chinese) |

| [14] |

HOU Q B, ZHOU D Q, FENG J S. Coordinate attention for efficient mobile network design[C]// 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville, USA: IEEE, 2021: 13708-13717.

|

| [15] |

LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Honolulu, USA: IEEE, 2017: 1132-1140.

|

| [16] |

REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [17] |

REDMON J, FARHADI A. YOLOv3: An incremental improvement[J/OL]. arxiv. (2018-04-08)[2023-10-10]. https://arxiv.org/abs/1804.02767.

|

| [18] |

BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLOv4: Optimal speed and accuracy of object detection[J/OL]. arxiv. (2020-04-23)[2023-10-10]. https://arxiv.org/abs/2004.10934.

|

| [19] |

GE Z, LIU S T, WANG F, et al. YOLOX: Exceeding YOLO series in 2021[J/OL]. arxiv. (2021-07-18)[2023-10-10]. https://arxiv.org/abs/2107.08430.

|