2. 清华大学 自动化系, 北京 100084

2. Department of Automation, Tsinghua University, Beijing 100084, China

鸡尾酒会[1-2]是一个有趣的场景(也称为多说话人场景),其中,多个说话人的声音混合在一起,就像在一场喧嚣的社交聚会上一样。在多说话人场景中,听力正常的人能够选择性地关注感兴趣的声音,忽略其他干扰声音,这种现象是由于人类听觉系统中的听觉注意能够准确地从多种声音中挑选出感兴趣的信息传递给大脑。然而,听力受损的人因听力障碍[3]而很难在嘈杂的环境中区分目标声音和干扰声音,从而导致他们在社交场合中沟通困难,容易引发情感和社交问题。听觉注意检测(auditory attention detection,AAD)[4-5]致力于从大脑信号中检测出听觉注意。因此,一些脑机接口应用[6](brain-computer interface,BCI),如助听器、人工耳蜗等,通过集成先进的听觉注意检测算法,帮助听障人士更准确地捕捉目标声音,忽略背景噪声,提高他们在多说话人场景下的听觉能力。

随着医学、神经科学和心理声学等相关领域研究的不断深入,研究人员现在能够从多种大脑信号中解码听觉注意,如皮质电图(electrocorticography,ECoG) [7]、脑磁图(magnetoencephalography,MEG)[8]和脑电图(electroencephalogram,EEG)[9-11]等。与皮质电图、脑磁图相比,EEG提供了一种低成本的非侵入式技术,可以对高时间分辨率的大脑皮质活动进行研究,是便携性助听设备的现实选择。研究表明[12-13],使用EEG进行听觉注意检测是可行的。

在基于EEG的听觉注意检测领域,鲁汶大学(University of Leuven)的KUL数据集[14]和丹麦技术大学(Technical University of Denmark)的DTU数据集[15]是运用较为成熟的公开可用数据集,但它们仅包含EEG数据和音频数据。然而,在日常生活中,人们的听觉注意通常伴随着视觉信息,例如,当一个人面向另一个人,并聆听他的声音时,视觉感官输入也会在注意过程中发挥重要作用。因此,在研究听觉注意时,除了音频信息外,视频信息也具有重要意义。为了更全面地研究人们在视听结合状态下的听觉注意,研究需要整合EEG、音频和视频数据。基于这一需求,本文构建了一个综合的音视频脑电数据集(audio-video EEG dataset,AVED),

以实现对听觉注意的深入探究。该数据集不仅包括EEG和音频数据,还加入了视频信息,这样的综合数据集可以提供更丰富的多模态信息,使研究人员能够深入研究人们在视听信息同时刺激下的听觉注意模式和神经机制。通过这个音视频脑电数据集,研究人员可以研究人们在日常环境中是如何同时处理视觉和听觉信息的。这对于理解大脑在多模态刺激条件下的工作机制,以及在认知和神经科学领域取得进展具有重要意义。

1 现存数据集本节详细介绍了目前在听觉注意检测领域广泛使用的2个公开数据集——KUL和DTU。这2个数据集为研究听觉注意提供了重要的数据资源。AVED与KUL、DTU的参数对比如表 1所示,其中,“√”表示数据集中包含该类数据,“×”表示不包含。

| 数据集参数 | KUL | DTU | AVED | |

| audio-only | audio-video | |||

| EEG | √ | √ | √ | √ |

| audio | √ | √ | √ | √ |

| video | × | × | × | √ |

| 受试者数量 | 16 | 18 | 10 | 10 |

| EEG通道数量 | 64 | 64 | 32 | 32 |

| EEG持续时间/min | 48 | 50 | 40 | 40 |

| 演讲者性别 | 男性 | 男性和女性 | 男性和女性 | 男性和女性 |

| 刺激语言 | 荷兰语 | 丹麦语 | 普通话 | 普通话 |

| 刺激方向 | ±90° | ±60° | ±90° | ±90° |

1.1 KUL数据集[14]

该数据集包括16名受试者的64通道EEG数据,性别分布均匀,即一半为男性,一半为女性。这些数据采用采样率为8 192 Hz的BioSemi ActiveTwo系统进行记录,并符合国际10/20系统的电极布局。听觉刺激是由男性演讲者朗读的4个荷兰短篇故事。在实验中,每位受试者被要求将注意力集中在2位竞争的男性演讲者之一所讲述的故事上,同时忽略另一位演讲者。听觉刺激以60 dB的音量通过入耳式耳机呈现,并进行了低通滤波,截止频率为4 kHz。

每位受试者参与20次实验,每次实验持续6 min。实验包括2种刺激条件:一种是使用头相关传输函数(head related transfer functions,HRTF)过滤刺激,以模拟扬声器左侧90°和右侧90°的音频;另一种是采用二分法演示,其中,每个故事轨道通过左侧耳机和右侧耳机分别呈现。这2个条件共有8次试验。在上述2个刺激条件下,2位演讲者的声音分别从受试者的左侧90°和右侧90°呈现,演讲者的音频以随机顺序呈现,旨在避免声音对不同受试者的影响。本研究使用每位受试者8个6 min的实验数据,总计48 min的EEG数据。

1.2 DTU数据集[15]该数据集包含18名受试者的64通道EEG数据,受试者的数据使用采样率为512 Hz的Biosemi系统进行记录,并符合国际10/20系统的电极布局。听觉刺激是由男性和女性演讲者朗读的丹麦有声读物。在实验中,每位受试者被要求专注于2位演讲者中的一个(一个男性演讲者和一个女性演讲者),同时忽略另一个演讲者。为了模拟低混响条件,2位竞争演讲者的录音被6位额外的背景说话者(3男3女)的声音所干扰。

2位演讲者的声音以65 dB的音量通过扬声器的形式从受试者的正前方+60°和-60°位置呈现。听觉刺激使用ER-2 insert earphones以48 kHz的采样率进行录制。每位受试者依次在3种不同的实验条件下进行数据采集,共进行了60次实验,每次实验持续50 s,因此,每位受试者为数据集提供了总计50 min的EEG数据。

2 音视频脑电数据集针对前述2个数据集中缺乏视觉信息输入的问题,本研究采集了一个新的脑电数据集,其中的刺激来源包括音频和视频,即音视频脑电数据集(AVED)。本节将介绍这个音视频脑电数据集的构成。值得注意的是,该数据集的总体设置遵循了先前发布的公开数据集(KUL、DTU)的标准。与前述数据集不同的是,该数据集不仅使用普通话音频作为听觉刺激,而且还引入了视频作为刺激的一部分。有关AVED的详细信息见表 1。

2.1 受试者本实验共招募20位受试者,包括14名男性和6名女性,受试者的平均年龄约为20岁,年龄范围为18~27岁。所有受试者都是听力正常的在校学生,且未患有神经系统疾病。在实验开始前,每位受试者都已仔细了解实验内容,并签署了知情同意书,确认自愿参与本实验。知情同意书中明确了实验的目的、可能的风险和利益,以及他们可以随时选择退出实验而不会受到任何影响。此外,知情同意书还强调了数据的匿名性和机密性,以保护受试者的隐私和权益。

2.2 刺激实验中的听觉刺激来源于16个故事,这些故事选自中国短篇小说集《聊斋志异》,并分别由一名男性和一名女性讲述。在实验过程中,向受试者同时播放2个故事的音频,若有视频刺激,则受试者关注视频中讲述者性别对应的故事声音,并忽略另一个故事声音。实验在一个光线适中、隔音的房间里进行,并要求受试者在此期间尽量减少眨眼和其他活动。每次实验结束后,都有与受试者所关注的故事相关的3个单选题,以保证受试者实验过程的注意力集中。在刺激的录制过程中,以MP4格式、WAV格式分别保存讲述者的音视频和单人立体声干净音频,并根据实验要求进一步处理。刺激的录制和处理分为以下2部分。

1) 音频刺激(audio-only)。在录制的干净音频基础上,用Adobe Audition软件合成双声道混合音频(左声道设置男声,右声道设置女声),去除少量噪声,总时长为152 s,其中包含开头的2 s静音片段,以保证呈现给受试者2只耳朵的音频同时播放。音频信号的频带限制为44.1 kHz,通过一对插入式耳机(即IE100PRO),以适当音量呈现给每位受试者。2个音频分别向受试者的左耳/右耳播放,即听觉方向为受试者的±90°。

2) 音视频刺激(audio-video)。音视频刺激的视频使用HIK VISION DS-E14a专业摄像头、Lenovo xiaoxin Air 15IKBR内置麦克风在无环境杂音的房间中进行录制,要求讲述者在录制过程中尽量保持肢体不动。通过视频编辑器统一裁剪为16个总时长为152 s的视频(开头的前2 s保持静音),并保留每个故事的开头,以引起受试者兴趣。以4 K分辨率、25帧/s的速率导出MP4格式的音视频数据。视频所使用的音轨采样频率为44.1 kHz。用Adobe Audition软件合成双声道混合音频(其中包含该视频讲述者的声音轨道),并保证2个声音轨道的电平平衡。视频的演示顺序按照编号1—16的顺序排列。

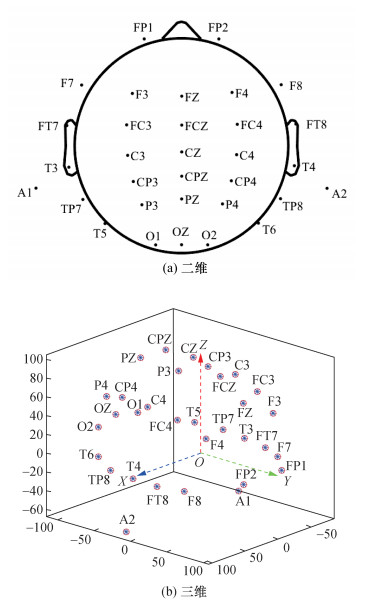

2.3 脑电数据采集EEG信号使用Neuroscan EEG /ERP设备进行记录,并应用了GT5新型磨砂医用导电膏,以降低阻抗,增强电极与头皮之间的电连接,以确保获取高质量的脑电信号。实验采集过程使用32个有源AgCl电极帽,以1 000 Hz的采样率记录脑电信号,其中,电极帽包括2个乳突电极。电极帽的布局遵循国际10/20系统,图 1为二维和三维EEG通道的空间位置。在每次实验中,要特别确保刺激演示计算机和Neuroscan EEG系统记录脑电数据的开始时间同步。随后,离线阶段使用MATLAB软件进行数据预处理,以进一步优化信号的质量和准备进行后续的分析。

|

| 图 1 二维和三维EEG通道的空间位置 |

2.4 实验流程

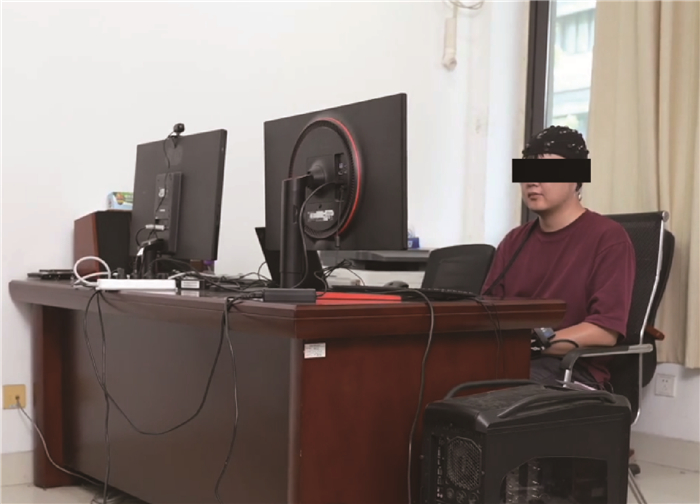

实验在隔音房间内进行,旨在最大程度地减少外界干扰,实验场景如图 2所示。受试者就座于舒适的椅子上,距离刺激屏幕约30 cm,头戴脑电设备,按照实验指导专注于一个音频源,并忽略另一个。将受试者分为2组,各有10名受试者,分别标记为1组和2组。1组进行接收音频作为唯一刺激(audio-only)的实验,2组进行接收音视频作为刺激(audio-video)的实验。2组的受试者成员没有重复,确保刺激故事对受试者完全陌生。实验具体设置如下。

|

| 图 2 实验场景 |

1) 音频刺激(audio-only)。在仅有音频作为刺激的采集实验过程中,刺激演示计算机端播放混合音频,受试者只需佩戴耳机,根据指令确定注意力方向,即受试者需集中注意力关注空间方向上左耳/右耳的故事。

2) 音视频刺激(audio-video)。在音视频作为刺激的采集实验过程中,刺激演示计算机端播放音视频,受试者需佩戴耳机,并根据自身需要佩戴眼镜。根据每次试验播放的视频中讲述者的性别确定注意力方向,要求受试者的视线一直注视讲述者的唇部变化,以更好地集中注意力。

每位受试者都进行了16次实验,每次实验持续152 s,其中包括实验开始之前2 s的静音时间。每次实验结束后,受试者需要回答与他们专注的音频相关的单项选择问题,这些问题的答案用于衡量受试者是否成功专注于目标音频。为确保受试者在实验过程中不会出现疲劳或注意力不集中的情况,实验中设置了休息时间。在整个实验期间,目标音频的空间位置及说话者的性别都是随机呈现的,以确保实验的多样性和可比性。每位受试者为数据集提供40 min的脑电数据。共有20名受试者参与了实验,因此,脑电数据的总收集时间约为13.3 h。

3 听觉注意检测针对上述提到的2个已有公开数据集(KUL和DTU),以及本文构建的新数据集(AVED),本节采用深度学习方法对3个数据集进行与听觉空间注意检测相关的实验。在这些实验中,本文对每个频段及全频段进行深入研究,以探索不同频率范围内的听觉注意机制,旨在通过对这些数据集进行深度学习实验,深入了解听觉空间注意的神经机制,并探究不同频段对听觉注意选择的影响。

3.1 EEG数据预处理1) KUL数据集。首先对EEG信号进行0.1~50 Hz的带通滤波,以滤除不相关的频率。随后对信号进行下采样,下采样频率为128 Hz,以减少数据量,同时保留主要频率信息。此外,对每个通道的信号进行归一化,确保每次实验的信号均值和方差都为零[13]。

2) DTU数据集。首先,进行线路噪声和谐波的滤除,尤其是50 Hz处的干扰。其次,采用基于快速Fourier变换(fast Fourier transformation,FFT)的重采样方法将EEG数据下采样至64 Hz,以满足实验需要。再次,在数据预处理中,采用联合去相关框架,以去除眼睛伪影,并在1.0 Hz处使用四阶正向Butterworth高通滤波器处理EEG数据[16]。最后,对每个EEG通道进行归一化,并对每个试验的EEG数据进行Z-Score归一化,确保每个通道的单位方差和均值均为零,以提高数据的标准化程度。

3) AVED数据集。首先,应用陷波滤波器消除50 Hz处的工频干扰;其次,使用有限长单位冲激响应(finite impulse response,FIR)滤波器,进行高通和低通滤波,以去除电压漂移和高频噪声,这一系列滤波步骤有助于提取干净的EEG信号;再次,为了减小数据量,并降低计算复杂度,对EEG信号进行降采样至128 Hz,同时保留主要的频率信息;然后,利用独立成分分析(ICA)处理数据,分离脑电信号中的独立成分,去除潜在的混杂成分,如眼动和肌电活动,以提高信号纯度和解释性;最后,对所有脑电信号通道进行重参考,以确保数据在分析过程中的一致性和可比性,减小参考电极的影响,保障EEG数据的准确性和稳定性。

3.2 基于深度学习的听觉空间注意检测最新的听觉注意检测研究表明,在短时间窗口条件下,非线性模型通常能够获得比线性模型更出色的性能。因此,本研究利用非线性模型评估数据集的有效性。听觉空间注意检测的目标是从脑电信号中解码被关注语音的空间轨迹。本研究使用的非线性模型仅需输入EEG数据,而不需要额外的听觉刺激。这是因为先前的一些听觉注意检测研究使用了EEG和干净的听觉刺激作为输入,但在实际生活中,获取纯净的听觉刺激通常非常困难。因为在实际场景中,听者接收到的听觉刺激通常是混合的语音,分离混合语音并获得干净刺激是非常具有挑战性的,这也影响了使用干净刺激的研究的准确性。因此,考虑实际应用的复杂性和可行性,本文选择仅使用EEG数据的方法,以确保模型在真实场景中更加实用和有效。

通常,正常听力的人将注意力转移到另一个说话者所需的时间约为1~2 s。因此,本文采用滑动窗口的方法,将每个受试者的整个EEG数据切分成等长的片段,这些片段之间有50%的重叠。根据之前的研究,本文采用一个先进的非线性模型(MBSSFCC)[17],以作为基线模型对3个数据集进行评估。该模型由以下4部分组成。

1) 多频段微分熵特征提取。将每个EEG全频段分解为5个经典频段,即Delta(1~3 Hz)、Theta(4~7 Hz)、Alpha(8~13 Hz)、Beta(14~30 Hz)和Gamma(31~50 Hz)。

2) 三维到二维投影[13]。利用EEG的拓扑模式,将脑电信号的光谱和空间信息进行充分利用,实现三维到二维的投影。

3) 频谱-空间-时间特征提取。使用卷积层对EEG信号进行特征提取,充分考虑频率、空间和时间的维度。

4) 分类。在网络的最后应用全连接(FC)层和softmax,以获得二元分类决策结果(在第一个FC层之后应用了dropout,以减小过拟合的可能性)。

为了防止过拟合和提高模型的泛化能力,采用批量归一化和ReLU激活函数。实验共进行200次迭代,采用交叉熵作为损失函数,并设置学习率为0.001,学习率衰减为0.001。softmax输出的数字0或1代表了被关注的语音来源在左侧或右侧。

本文进一步研究了不同频段在听觉空间注意检测中的性能表现。此外,本文提出的数据集相对较为稀疏,仅包含32通道EEG,因此,与其他2个64通道的数据集相比,这样的数据密度对听觉注意检测的实际应用具有更大的便利性。

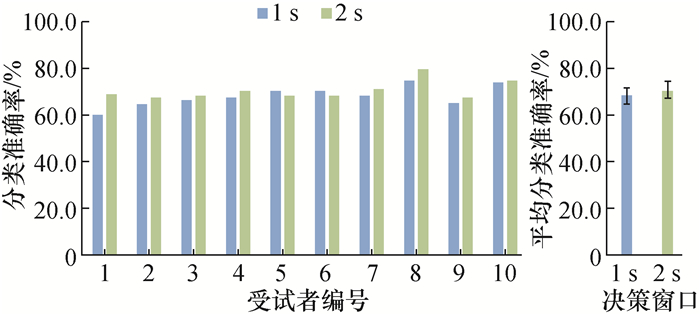

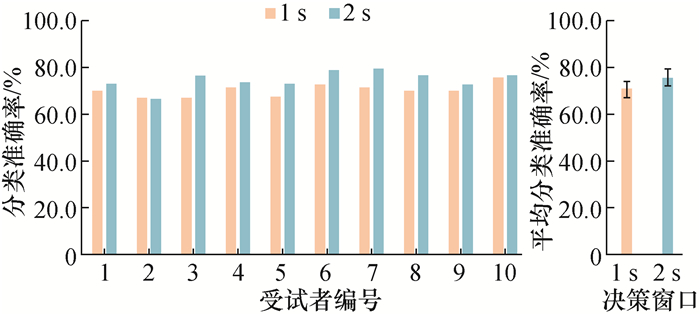

4 实验结果与分析 4.1 基于非线性模型的实验结果与分析基于所提出的音视频脑电数据集,图 3(仅有音频作为刺激,audio-only)和图 4(音视频作为刺激,audio-video)呈现了每位受试者的听觉空间注意检测性能,并且分别在图 3和图 4中的右侧呈现了每个决策窗口下所有受试者的平均分类准确率。此外,所有受试者的平均分类准确率见表 2。随着决策窗口的增加,即从1 s到2 s,研究观察到,听觉注意检测的准确度也呈上升趋势,这与先前的研究结果一致。这表明,随着时间窗口的增加,脑电信号中包含的信息也增加,从而使模型能够提取更多有助于听觉空间注意检测的特征。

|

| 图 3 使用基线模型在音视频脑电数据集上的分类性能 |

|

| 图 4 使用基线模型在仅有音频刺激脑电数据集上的分类性能 |

| % | |||||||||||||||||||||||||||||

| 数据集 | 决策窗口 | 全频段 | Delta | Theta | Alpha | Beta | Gamma | ||||||||||||||||||||||

| KUL | 1 s | 88.7±7.19 | 74.8±6.38 | 79.3±8.63 | 85.7±9.10 | 66.4±5.90 | 71.5±4.69 | ||||||||||||||||||||||

| 2 s | 91.3±6.03 | 79.4±5.78 | 82.9±9.04 | 89.9±7.46 | 67.5±7.29 | 73.1±6.22 | |||||||||||||||||||||||

| DTU | 1 s | 74.9±6.29 | 62.1±4.34 | 61.3±5.30 | 63.7±4.91 | 73.7±7.36 | 74.3±7.58 | ||||||||||||||||||||||

| 2 s | 78.3±7.10 | 64.5±6.60 | 61.8±6.57 | 65.0±5.75 | 77.6±7.63 | 78.3±7.15 | |||||||||||||||||||||||

| audio-video | 1 s | 68.1±4.44 | 59.9±3.24 | 60.0±3.58 | 58.6±3.80 | 59.2±3.81 | 64.0±3.11 | ||||||||||||||||||||||

| 2 s | 70.5±3.81 | 60.9±4.23 | 59.1±3.61 | 61.7±3.66 | 61.1±2.69 | 65.8±5.90 | |||||||||||||||||||||||

| audio-only | 1 s | 70.1±2.73 | 59.2±2.52 | 58.8±2.63 | 61.1±2.58 | 61.0±2.31 | 60.2±2.74 | ||||||||||||||||||||||

| 2 s | 75.2±3.81 | 61.5±5.52 | 63.5±3.32 | 63.3±3.34 | 62.6±4.37 | 61.9±4.77 | |||||||||||||||||||||||

从表 2可以看出,当受试者仅接收音频刺激(audio-only)时,在1 s和2 s决策窗口下,所有受试者的平均准确率分别为70.1%(标准差2.73%)和75.2%(标准差3.81%)。相比之下,当受试者接收音视频刺激(audio-video)时,在1 s和2 s的决策窗口下,所有受试者的平均准确率分别为68.1%(标准差4.44%)和70.5%(标准差3.81%)。根据上述2种情境下的数据可以明显看出,在这2种接收刺激的情境中,仅接收音频刺激的平均准确率显著高于接收音视频刺激的情况。这个现象是由于后者情境下,受试者需要同时处理音频和视频信息,从而分散了他们的注意力。具体而言,这种分散可能是因为视觉和听觉信息的处理方式不同,要求大脑在同一时间内处理多种感官输入。音频信息主要依赖于听觉系统,通常以线性方式传达,而视频信息则涉及视觉感知,需要更多的视觉处理。当这2种信息同时传递给大脑时,大脑可能会面临来自2个感官通道的信息干扰,导致注意力分散和信息处理效率降低。因此,在接收音视频刺激的情境下,受试者需要更多的认知资源来处理这2种信息,从而降低了他们处理任务的准确率。

4.2 基于不同频段的实验结果与分析除了对多频段的脑电信号进行研究外,本文还对每个频段的脑电信号进行了听觉注意分类性能的深入评估。具体而言,研究分别评估了Delta(1~ 3 Hz)、Theta(4~7 Hz)、Alpha(8~13 Hz)、Beta(14~30 Hz)和Gamma(31~50 Hz)频段下的听觉空间注意检测性能,相应结果见表 2。由表 2可知,KUL数据集在1 s和2 s的时间决策窗口下,全频段的平均分类准确率分别为88.7%(标准差7.19%)和91.3%(标准差6.03%),而DTU数据集在相同条件下的平均分类准确率为74.9%(标准差6.29%)和78.3%(标准差7.10%)。此外,由表 2还可知,无论是在不同的数据集中,还是在不同的决策窗口下,全频段脑电数据都表现出最佳性能。由此表明,1~50 Hz的EEG数据中包含每个频段有关听觉注意的信息,模型可以从中获得更多有关听觉注意的脑电特征。

此外,由表 2可知,在KUL数据集中,与其他频段相比,非线性模型在Alpha频段仍实现了相对较高的检测性能,即1 s和2 s决策窗口下的平均分类准确率分别达到了85.7%(标准差9.10%)和89.9%(标准差7.46%)。与之不同的是,在DTU数据集中,Gamma频段展现出了相对较高的检测性能,1 s和2 s决策窗口下的平均分类准确率分别为74.3%(标准差7.58%)和78.3%(标准差7.15%)。这一趋势在本文构建的使用音视频作为刺激(audio-video)的脑电数据集中得到了验证,即与DTU数据集的结果一致,Gamma频段比其他频段表现出较高的分类准确率(1 s决策窗口下的平均分类准确率为64.0%、标准差为3.11%,2 s决策窗口下的平均分类准确率为65.8%、标准差为5.90%)。而在本文构建的仅使用音频作为刺激(audio-only)的脑电数据集中,在Alpha频段,1 s和2 s决策窗口下的平均分类准确率分别达到了61.1%(标准差2.58%)和63.3%(标准差3.34%),在1 s决策窗口下,Alpha频段的检测性能高于其他频段;在2 s决策窗口下,Alpha频段的平均分类准确率比Theta频段低了0.2%,但仍高于其他频段。

综上所述,在进行听觉空间注意时,Alpha和Gamma频段的脑电信号承载了至关重要的信息。这些特定频段的信号可能反映了大脑在处理空间定向和注意力选择时的关键活动。Alpha频段通常与大脑的放松、休息及内向性任务相关联,而Gamma频段往往与认知加工、感知整合和注意力集中有关。因此,在理解听觉空间注意的神经机制及开发基于脑电信号的注意力探测技术时,这些频段的研究具有深远意义。

5 结论本研究通过构建一个音视频脑电数据集为研究听觉注意提供了更具挑战性的实验环境。与过去的研究不同,本文在模拟真实场景时引入了视频信息,这有助于更好地理解多模态感知任务中的注意力选择机制。所提出的数据集不仅包括同时接收音频和视频刺激的情况,还包括仅接收音频刺激的情境,这使得研究能够直接比较2种情境下的注意检测性能。研究结果表明,在音视频刺激情境下,受试者需要同时处理2种感官信息,这可能会分散他们的注意力,导致大脑注意力分散和信息处理的效率下降。这突出了多模态任务中听觉注意力选择的挑战,对设计更高效的多感官应用和理解大脑注意机制具有实际意义。此外,实验结果还强调了不同频段对听觉注意的影响,特别是Alpha和Gamma波段的重要性,这有助于更好地理解听觉空间注意的神经机制。总之,本研究的数据集为未来的多模态研究和真实场景模拟提供了有力的支持,有望推动听觉注意领域的深入研究和应用。

| [1] |

CHERRY E C. Some experiments on the recognition of speech, with one and with two ears[J]. The Journal of the Acoustical Society of America, 1953, 25(5): 975-979. DOI:10.1121/1.1907229 |

| [2] |

黄雅婷, 石晶, 许家铭, 等. 鸡尾酒会问题与相关听觉模型的研究现状与展望[J]. 自动化学报, 2019, 45(2): 234-251. HUANG Y T, SHI J, XU J M, et al. Research advances and perspectives on the cocktail party problem and related auditory models[J]. Acta Automatica Sinica, 2019, 45(2): 234-251. (in Chinese) |

| [3] |

CICCARELLI G, NOLAN M, PERRICONE J, et al. Comparison of two-talker attention decoding from EEG with nonlinear neural networks and linear methods[J]. Scientific Reports, 2019, 9(1): 11538. DOI:10.1038/s41598-019-47795-0 |

| [4] |

PUFFAY C, ACCOU B, BOLLENS L, et al. Relating EEG to continuous speech using deep neural networks: A review[J]. Journal of Neural Engineering, 2023, 20(4): 041003. DOI:10.1088/1741-2552/ace73f |

| [5] |

GEIRNAERT S, VANDECAPPELLE S, ALICKOVIC E, et al. Electroencephalography-based auditory attention decoding: Toward neurosteered hearing devices[J]. IEEE Signal Processing Magazine, 2021, 38(4): 89-102. DOI:10.1109/MSP.2021.3075932 |

| [6] |

陈小刚, 陈菁菁, 刘冰川, 等. 基于脑电的脑机接口技术在医学领域中的应用[J]. 人工智能, 2021(6): 6-14. CHEN X G, CHEN J J, LIU B C, et al. Application of brain-computer interface technology based on EEG in medical field[J]. Artificial Intelligence VIEW, 2021(6): 6-14. (in Chinese) |

| [7] |

MESGARANI N, CHANG E F. Selective cortical representation of attended speaker in multi-talker speech perception[J]. Nature, 2012, 485(7397): 233-236. DOI:10.1038/nature11020 |

| [8] |

DING N, SIMON J Z. Neural coding of continuous speech in auditory cortex during monaural and dichotic listening[J]. Journal of Neurophysiology, 2012, 107(1): 78-89. DOI:10.1152/jn.00297.2011 |

| [9] |

O'SULLIVAN J A, POWER A J, MESGARANI N, et al. Attentional selection in a cocktail party environment can be decoded from single-trial EEG[J]. Cerebral Cortex, 2015, 25(7): 1697-1706. DOI:10.1093/cercor/bht355 |

| [10] |

KURUVILA I, MUNCKE J, FISCHER E, et al. Extracting the auditory attention in a dual-speaker scenario from EEG using a joint CNN-LSTM model[J]. Frontiers in Physiology, 2021, 12: 700655. DOI:10.3389/fphys.2021.700655 |

| [11] |

SU E Z, CAI S Q, XIE L H, et al. STAnet: A spatiotemporal attention network for decoding auditory spatial attention from EEG[J]. IEEE Transactions on Biomedical Engineering, 2022, 69(7): 2233-2242. DOI:10.1109/TBME.2022.3140246 |

| [12] |

FAGHIHI F, CAI S Q, MOUSTAFA A A. A neuroscience-inspired spiking neural network for EEG-based auditory spatial attention detection[J]. Neural Networks, 2022, 152: 555-565. DOI:10.1016/j.neunet.2022.05.003 |

| [13] |

CAI S Q, SU P C, SCHULTZ T, et al. Low-latency auditory spatial attention detection based on spectro-spatial features from EEG[C]// Proceedings of the 2021 43rd Annual International Conference of the IEEE Engineering in Medicine & Biology Society. Piscataway, USA: IEEE Press, 2021: 5812-5815.

|

| [14] |

DAS N, FRANCART T, BERTRAND A. Auditory attention detection dataset KULeuven (1.1.0)[DB/OL]. (2019-08-30)[2023-12-21]. https://doi.org/10.5281/zenodo.3997352.

|

| [15] |

FUGLSANG S A, WONG D D E, HJORTKJæR J. EEG and audio dataset for auditory attention decoding (version 1)[DB/OL]. (2018-03-15)[2023-12-21]. https://doi.org/10.5281/zenodo.1199011.

|

| [16] |

WONG D D E, FUGLSANG S A, HJORTKJæR J, et al. A comparison of regularization methods in forward and backward models for auditory attention decoding[J]. Frontiers in Neuroscience, 2018, 12: 531. DOI:10.3389/fnins.2018.00531 |

| [17] |

JIANG Y F, CHEN N, JIN J. Detecting the locus of auditory attention based on the spectro-spatial-temporal analysis of EEG[J]. Journal of Neural Engineering, 2022, 19(5): 056035. DOI:10.1088/1741-2552/ac975c |