2. 厦门大学 电子工程系, 厦门 361005;

3. 厦门大学 人工智能系, 厦门 361005

2. Department of Electronic Engineering, Xiamen University, Xiamen 361005, China;

3. Department of Artificial Intelligence, Xiamen University, Xiamen 361005, China

近年来,预训练技术在自然语言处理领域得到广泛应用[1-4],与此同时,语音领域的学者也开始探索语音预训练技术,利用语音预训练模型从大量的无标注音频数据中学习通用语音表征,并将通用语音表征应用到下游各种任务,如语音识别、情感识别、意图分类等。Schneider等[5]提出wav2vec,在当前帧(锚点)、未来帧(正样例)和随机挑选的干扰帧(负样例)之间构建对比损失函数,最大化锚点与正样例之间的相似性,同时最小化锚点与负样例之间的相似性。Baevski等[6]在wav2vec的基础上进行改进,提出wav2vec 2.0预训练框架,通过引入带有自注意力机制的Transformer[7]模块提升性能。随后,HuBERT[8]、UniSpeech-SAT[9]和WavLM[10]等基于预测离散语音单元的自监督预训练模型被相继提出。

目前,不少研究者探索了语音预训练模型在有监督说话人验证中的应用。相关研究表明,与传统的声学特征(如FBANK等)相比,预训练模型能从音频中捕获更有价值的信息,并能更好地提升说话人识别性能[11-12]。一些工作在预训练模型顶层添加由池化层和全连接层组成的说话人分类网络,并在训练过程中联合更新预训练模型和说话人分类网络的参数,以提升系统性能[13-14]。进一步地,研究者们用更适合说话人验证任务的模型(如ECAPA-TDNN[15]等)替代简单的说话人分类网络,取得了更好的识别性能[16-17]。然而,这些有监督说话人验证系统通常需要大量的有标签数据,如几百小时的VoxCeleb1[18]数据集,甚至是数千小时的VoxCeleb2[19]数据集。在低资源场景下,基于半监督学习[20]的训练策略是一个很好的解决方式。Inoue等[21]采用广义对比损失(generalized contrastive loss,GCL)法,提出半监督对比学习架构,将监督学习和无监督对比学习的损失统一起来,作为半监督学习的损失。Zhang等[22]通过半监督学习对大量未标注的语音数据加以利用,通过对比自监督学习最小化同一语音不同片段特征之间的距离,并最大化不同语音片段特征之间的距离,试验结果表明:半监督学习为说话人识别系统带来较大的性能提升。

Chen等[23]探索了无监督场景下基于预训练模型的说话人验证框架,充分利用预训练模型提取说话人信息,在性能上超越了此前的无监督说话人验证系统[24-26]。由于低资源场景下通常还可使用大量无标注的音频数据,因此,本文将基于预训练模型的无监督说话人验证框架拓展至半监督场景,利用目标域少量带标注和大量无标注数据进一步提升低资源说话人验证性能。在仅有100 h带标签说话人数据的条件下,本文提出的半监督系统在VoxCeleb1-O测试集的等错误率为1.02%,比基线系统降低了86.8%,表明本文所提出的半监督说话人验证系统的有效性。

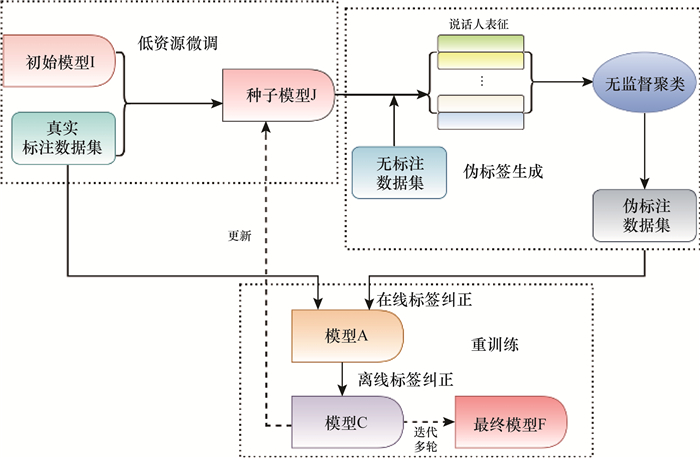

1 基于预训练模型的半监督说话人验证系统 1.1 系统框架基于预训练模型的半监督说话人验证系统的整体框架如图 1所示,大致可分为以下几个步骤。

|

| 图 1 基于预训练模型的半监督说话人验证系统 |

1) 先利用约100 h真实标注数据对预训练模型进行微调训练,得到一个性能较好的系统模型,作为种子模型J。

2) 用种子模型J提取大量无标注音频数据集的说话人表征,利用提取的说话人表征为无标注音频数据集构建说话人表征图,将该图送入Infomap[27]聚类模块,输出聚类结果,并按照聚类类别为每条音频分配对应的说话人伪标签。

3) 对系统模型进行重训练。将原始的少量真实标注数据和经聚类生成的大量伪标注数据集进行合并,重新训练系统模型。由于说话人伪标签中会不可避免地引入噪声,因此在重训练过程中引入伪标签纠正策略,以减轻错误伪标签对系统模型造成的负面影响。具体而言,在重训练过程中先使用在线伪标签纠正策略,训练得到模型A,利用模型A对无标注数据进行伪标签预测,得到伪标签集{Yonline},再利用离线伪标签纠正策略对{Yonline}进行过滤和纠正,得到{Yoffline},然后将真实标注数据和经过离线标签纠正的数据合并,再次重新训练得到模型C,以此完成第1轮迭代。

4) 固定模型C的参数,并将模型C重新设置为种子模型,重复步骤2和3,通过多轮迭代得到最终模型F。本试验采用4轮迭代。

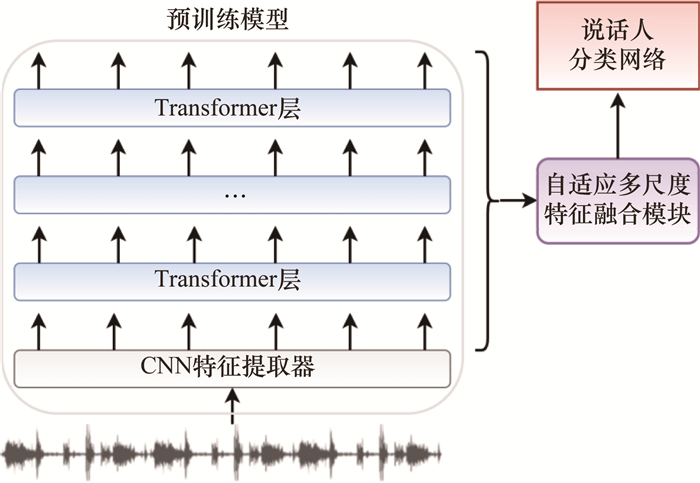

图 1中的模型J、A、C均使用图 2所示的基于预训练模型的说话人验证模型。预训练模型包含CNN(卷积神经网络)特征提取器和多层Transformer,多层Transformer的输出经过自适应多尺度特征融合模块送入下游说话人分类网络ECAPA-TDNN中,并最终生成192维的说话人嵌入。

|

| 图 2 基于预训练模型的说话人验证模型 |

1.2 自适应多尺度特征融合模块

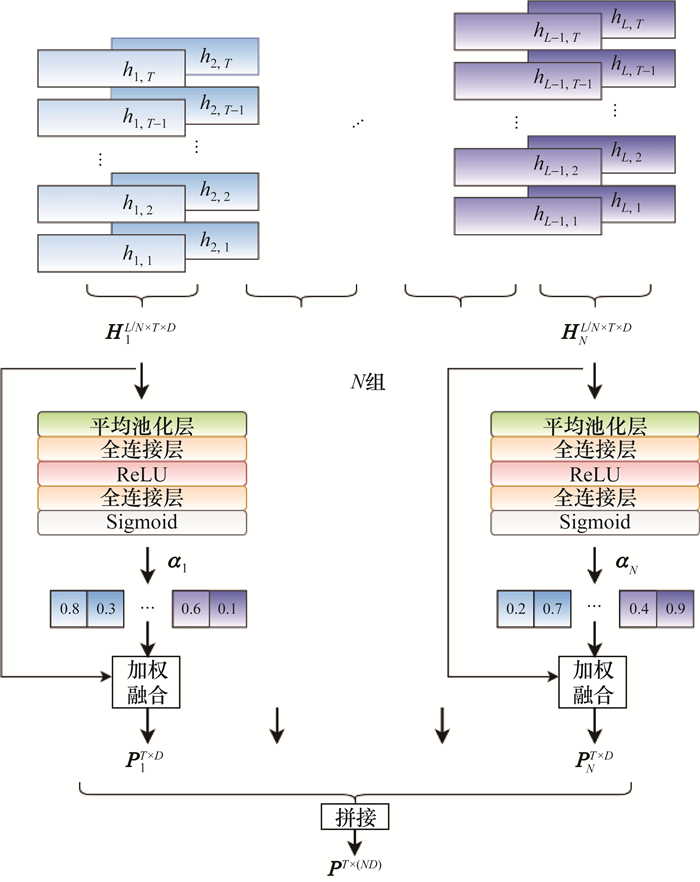

预训练模型中的Transformer模块能学习不同层次和级别的语音表征,文[28-29]表明:说话人相关信息会分布在不同的Transformer层,相邻层所携带的说话人信息相似,本文提出自适应特征融合模块,可对Transformer层进行分组处理,旨在从多层语音通用表征中学习到更丰富的说话人信息。如图 3所示,自适应多尺度特征融合模块依次由平均池化层、全连接层、ReLU激活函数、全连接层和Sigmoid激活函数组成。

|

| 图 3 自适应多尺度特征融合模块 |

设第l层Transformer模块的输出为

| $ \begin{equation*} \boldsymbol{P}_{n}^{T \times D}=\sum\limits_{i=1}^{L / N}\left(\boldsymbol{\alpha}_{n, i} \cdot \boldsymbol{H}_{n, i}^{T \times D}\right) \end{equation*}. $ | (1) |

传统聚类方法(如K-means)和凝聚层次聚类(agglomerative hierarchical clustering, AHC)更倾向优化类内距离,未对类间或全局结构进行建模。然而,图结构可反映数据全局和局部的拓扑结构,能有效地对复杂数据结构进行建模。文[23]利用基于Infomap的聚类算法,在说话人表征图上进行随机游走,引入层次编码,通过最小化平均编码长度获取聚类结果。通过试验分析,Infomap展示出较好的说话人聚类效果,有利于无监督说话人验证模型的性能提升。本文沿用Infomap聚类算法对说话人表征进行聚类,以期得到高质量的说话人伪标签。具体而言,将每个说话人表征视为图节点,通过计算节点间的余弦相似度得到边权重值,以构建说话人表征图;然后将说话人表征图作为聚类算法的输入,根据算法输出的聚类结果为所有音频分配对应的说话人伪标签。在对音频进行切段处理后,每条片段级别音频的伪标签继承其句子级别音频的伪标签。

1.4 伪标签纠正利用聚类算法生成说话人伪标签不可避免地产生错误标签信息,因此,在重训练过程中,需引入伪标签纠正技术。本文沿用文[23]中的在线和离线伪标签纠正策略,具体如下。

1.4.1 在线伪标签纠正1) 双标签纠正(dual label correction)损失。

本文利用双标签纠正损失ΓDLC进行训练,如式(2)所示,并利用模型自身预测的标签作为辅助信息,避免模型仅对噪声分布进行建模,以抑制错误伪标签对模型训练造成的干扰,从而改善训练效果。

| $ \begin{equation*} \varGamma_{\mathrm{DLC}}=-\frac{1}{B} \sum\limits_{b=1}^{B}\left\{\ln \left(P_{b, \hat{y}_{b}}\right)+\beta_{c} \cdot \ln \left(P_{b, \tilde{y}_{b}}\right)\right\} \end{equation*}. $ | (2) |

其中:B为批量大小;

2) 可靠样本后验概率重放缩。

当伪标签和模型的预测标签一致时,该伪标签被认为是可靠的。加大对可靠样本的关注可使模型朝更准确的方向优化。为使模型更大程度地从可靠样本中受益,对这类可靠样本的后验概率进行重放缩,表示如下:

| $ P_{b,{{\tilde y}_b}}^\prime = P_{b,{{\tilde y}_b}}^\prime = \frac{{{{\rm{e}}^{s\left( {\cos \left( {{{\hat y}_{,b}} + a} \right)} \right)}}}}{{{{\rm{e}}^{s\left( {\cos\left( {{\theta _{\hat y,b}} + a} \right)} \right)}} + \sum\limits_{j \ne {{\hat y}_b}}^K {{{\rm{e}}^{s\left( {\cos \left( {{\theta _{j,b}}} \right) + r} \right)}}} }}. $ | (3) |

式(3)是基于AAM-Softmax[30]的变体,其中:s和a分别为比例因子和角度惩罚因子;K为样本数量;θj, b为模型输出的第b个样本的说话人表征向量与第j类中心向量的夹角;r为重放缩项,取值与cos(θj, b)相关。重放缩可加大可靠样本对模型参数更新的贡献。

1.4.2 离线伪标签纠正离线伪标签纠正直接对数据集进行伪标签的硬性纠正:假设某条完整音频U被切分为E条音频片段,其中出现频率最高的标签为y,对应的音频片段数量为G。若G/E>0.5,则认为该条音频具有主标签,那么这E条音频片段的标签都会被修正为主标签y; 若G/E≤0.5,则认为该音频没有主标签,那么这E条音频片段都会被剔除。

2 试验设置 2.1 数据集本文从VoxCeleb2(简称Vox2)中随机挑选288个说话人,抽取其全部音频(共包含47 478条样本,总时长约100 h)作为有标注数据集,简称为Vox2-100,以此模拟低资源场景。Vox2中剩余的1 044 531条样本作为无标注数据集,与带标注数据集中的说话人无重叠,在训练中只利用其音频数据,不使用其原有标签信息,总时长约2 300 h,简称Vox2-2300。

预训练音频数据集包括LibriSpeech和Mix-94k。其中:LibriSpeech(简称LibriS)数据集音频约28万条,总时长约960 h,包含2 338个说话人;Mix-94k则由6.0×104 h的LibriLight、2.4×104 h的VoxPopuli及1.0×104 h的GigaSpeech组成。

2.2 模型配置说话人验证模型由自适应多尺度特征融合模块将预训练模型与专用声纹网络ECAPA-TDNN连接得到,其中:预训练模型均从开源项目获取,用于从原始音频中学习帧级别语音高级表征;自适应多尺度特征融合模块和ECAPA-TDNN的网络参数都是随机初始化的。为降低训练复杂度,本文仅采用Base规模的不同预训练模型,使用多尺度特征融合模块将预训练模型中全部的12层Transformer模块的输出进行融合。本试验将特征融合模块的分组数N分别设置为1和4。

2.3 训练策略本文的说话人识别试验基于开源工具ASV-SUBTOOLS[31]开展。批训练集由随机采样的512条时长为2 s的音频构成,即Batch size为512。为提高微调训练效果,本文采用2阶段模型训练策略:第1阶段仅更新ECAPA-TDNN和自适应多尺度特征融合模块的网络参数;第2阶段以更小的学习率更新整个系统模型的网络参数。具体而言,在低资源微调训练试验中,仅使用Vox2-100作为训练数据,第1阶段和第2阶段的训练Epoch数量均设为10,峰值学习率分别设为2×10-4和5×10-5。在进行系统模型的重训练时,合并有标注数据集Vox2-100与无标注数据集Vox2-2300,此时,2个训练阶段的Epoch数量分别为10和5,峰值学习率分别设为1×10-4和1.25×10-5。试验用AAM-Softmax作为损失函数,比例因子和角度惩罚因子分别设为30和0.2。此外,训练中还采用在线数据增强策略进一步提升性能,包括加噪、加混响和变速。

2.4 评价指标为全面评估说话人识别性能,本文使用不同的测试集进行性能测试,即除了VoxCeleb1-O外,还包括VoxCeleb1-E、VoxCeleb1-H。测试利用Cosine进行打分,不进行分数规整等任何后处理操作,以等错误率EER为评价指标。

3 试验结果与分析 3.1 低资源微调训练基于预训练模型的低资源微调训练结果如表 1所示,表中所有系统均仅使用Vox2-100进行训练,以EER为评估指标。其中,系统S1为不使用预训练模型的ECAPA-TDNN基线系统,其在VoxCeleb1-O上的EER为7.75%。而其他系统都基于预训练模型,结果表明,在低资源场景下,与基线系统相比,基于预训练模型的系统均可有效降低EER。由系统S2—S5的结果可知,wav2vec 2.0比其他预训练模型表现略差,而WavLM的性能最佳。与系统S5相比,系统S6利用使用了更大规模预训练音频集MIX-94K的WavLM进行微调训练,EER相对下降了13.4%,因此,增大预训练音频集规模可有效提升低资源说话人识别性能。由系统S7—S11的结果可知,使用分组的特征融合方式可进一步提升系统性能,表明预训练模型不同层次的Transformer模块所携带的有用说话人信息比重不同,对相邻Transformer层的输出进行分组处理可帮助模型学习到更具区分性的特征,验证了本文所提出的分组融合方式的有效性。

| 系统 | 预训练模型 | 预训练音频集 | N | EER/% |

| S1 | — | — | — | 7.75 |

| S2 | wav2vec 2.0 | LibriS | 1 | 5.99 |

| S3 | HuBERT | LibriS | 1 | 5.29 |

| S4 | UniSpeech-SAT | LibriS | 1 | 5.33 |

| S5 | WavLM | LibriS | 1 | 5.22 |

| S6 | WavLM | Mix-94k | 1 | 4.52 |

| S7 | wav2vec 2.0 | LibriS | 4 | 5.62 |

| S8 | HuBERT | LibriS | 4 | 5.02 |

| S9 | UniSpeech-SAT | LibriS | 4 | 5.06 |

| S10 | WavLM | LibriS | 4 | 4.97 |

| S11 | WavLM | Mix-94k | 4 | 4.34 |

| 注:S1为ECAPA-TDNN;S2—S11的下游网络为相同配置的ECAPA-TDNN。 | ||||

3.2 半监督系统

选择表 1中性能最佳的系统S11作为种子模型,用以提取无标注的Vox2-2300数据集的说话人表征,经过聚类模块可得到上述数据集音频的伪标签;随后将携带伪标签的Vox2-2300数据集与带标注的Vox2-100数据集联合,组成新的训练集,对S11进行重训练,在重训练过程中应用伪标签纠正技术,得到基于预训练模型的半监督说话人验证系统S13。系统S13进行1轮迭代的试验结果见表 2,与有监督系统S12进行对比分析,其中,S12为主流识别模型ECAPA-TDNN,使用带标注Vox2全部数据进行有监督训练,评估指标为EER。

| 系统 | EER/% | ||

| VoxCeleb1-O | VoxCeleb1-E | VoxCeleb1-H | |

| S12 | 1.19 | 1.22 | 2.37 |

| S13 | 1.25 | 1.29 | 2.45 |

首先,对比表 1中的系统S11与表 2的系统S13可以看出,半监督训练可有效利用无标注音频数据,大幅度提升了低资源说话人识别的性能,EER相对降低了71.2%;其次,半监督系统S13在3种不同测试集上的表现与完全有监督系统S12相当,表明本文提出的基于预训练模型的半监督识别框架可充分利用无标注音频数据,仅利用100 h的真实标注数据即可实现一个高性能的说话人识别系统。

由于表 2的半监督系统S13仅进行1轮迭代,因此,按图 1中步骤通过多轮迭代提升模型性能,多轮迭代结果如表 3所示。其中:归一化互信息(normalized mutual information,NMI)计算真实数据分布与预测的数据分布之间的互信息,并进行归一化,其值越大,聚类结果越好;B/A分别为在线伪标签纠正前和离线伪标签纠正后的聚类NMI。由表 3可知:经过多轮迭代,随着种子模型性能越来越强,NMI逐步增加,聚类所得到的伪标签质量越来越高,从而使得基于预训练模型的半监督系统性能得到进一步提升。经过第2轮迭代,半监督系统的性能有了显著提升,继续进行第3、4轮迭代后,系统性能趋于收敛,最终,VoxCeleb1-O测试集上的EER降至1.02%,这得益于预训练模型较好的泛化性能。

| 评价指标 | 第1轮 | 第2轮 | 第3轮 | 第4轮 |

| NMI(B/A) | 95.1/97.8 | 98.5/98.7 | 98.6/98.8 | 98.7/98.9 |

| EER/% | 1.25 | 1.10 | 1.05 | 1.02 |

4 结论

本文针对低资源说话人识别问题提出基于预训练模型的半监督说话人验证系统。该系统通过结合预训练模型、Infomap聚类算法和伪标签纠正技术对无标注音频数据进行充分利用。试验结果表明:本文所提出的半监督训练框架的有效性,在带标签的说话人数据仅有100 h的场景下,达到与传统完全有监督的基线系统相近的性能,经过多轮迭代训练后,性能得到进一步提升。然而,本文使用的训练数据集与测试集属于同一数据域,后续可考虑在域不匹配的情况下进一步验证该系统的鲁棒性。

| [1] |

DEVLIN J, CHANG M W, LEE K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding[C] // Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Minneapolis, USA: ACL, 2019: 4171-4186.

|

| [2] |

YANG Z L, DAI Z H, YANG Y M, et al. XLNet: Generalized autoregressive pretraining for language understanding[C] // Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver, Canada: ACM, 2019: 517.

|

| [3] |

LAN Z Z, CHEN M D, GOODMAN S, et al. ALBERT: A lite BERT for self-supervised learning of language representations[C] // Proceedings of the 8th International Conference on Learning Representations. Addis Ababa, Ethiopia: ICLR, 2020: 1-17.

|

| [4] |

BROWN T B, MANN B, RYDER N, et al. Language models are few-shot learners[C] // Proceedings of the 34th International Conference on Neural Information Processing Systems. Vancouver, Canada: ACM, 2020: 159.

|

| [5] |

SCHNEIDER S, BAEVSKI A, COLLOBERT R, et al. wav2vec: Unsupervised pre-training for speech recognition[C] // Proceedings of the 20th Annual Conference of the International Speech Communication Association. Graz, Austria: ISCA, 2019: 3465-3469.

|

| [6] |

BAEVSKI A, ZHOU Y H, MOHAMED A, et al. wav2vec 2.0: A framework for self-supervised learning of speech representations[C] // Proceedings of the 34th Advances in Neural Information Processing Systems. Vancouver, Canada: ACM, 2020: 12449-12460.

|

| [7] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C] // Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach, USA: ACM, 2017: 6000-6010.

|

| [8] |

HSU W N, BOLTE B, TSAI Y H H, et al. HuBERT: Self-supervised speech representation learning by masked prediction of hidden units[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 3451-3460. DOI:10.1109/TASLP.2021.3122291 |

| [9] |

CHEN S Y, WU Y, WANG C Y, et al. UniSpeech-SAT: Universal speech representation learning with speaker aware pre-training[C] // Proceedings of the 2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Singapore: IEEE, 2022: 6152-6156.

|

| [10] |

CHEN S Y, WANG C Y, CHEN Z Y, et al. WavLM: Large-scale self-supervised pre-training for full stack speech processing[J]. IEEE Journal of Selected Topics in Signal Processing, 2022, 16(6): 1505-1518. DOI:10.1109/JSTSP.2022.3188113 |

| [11] |

YANG S W, CHI P H, CHUANG Y S, et al. SUPERB: Speech processing universal PERformance benchmark[C] // Proceedings of the 22nd Annual Conference of the International Speech Communication Association. Brno, Czechia: ISCA, 2021: 1194-1198.

|

| [12] |

SANKALA S, RAFI B S M, MURTY K S R. Multi-feature integration for speaker embedding extraction[C] // Proceedings of the 2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Singapore: IEEE, 2022: 7957-7961.

|

| [13] |

VAESSEN N, VAN LEEUWEN D A. Fine-tuning wav2vec2 for speaker recognition[C] // Proceedings of the 2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Singapore: IEEE, 2022: 7967-7971.

|

| [14] |

VAESSEN N, VAN LEEUWEN D A. Training speaker recognition systems with limited data[C] // Proceedings of the 23rd Annual Conference of the International Speech Communication Association. Incheon, South of Korea: ISCA, 2022: 4760-4764.

|

| [15] |

DESPLANQUES B, THIENPONDT J, DEMUYNCK K. ECAPA-TDNN: Emphasized channel attention, propagation and aggregation in TDNN based speaker verification[C] // Proceedings of the 21st Annual Conference of the International Speech Communication Association. Shanghai, China: ISCA, 2020: 3830-3834.

|

| [16] |

CHEN Z Y, CHEN S Y, WU Y, et al. Large-scale self-supervised speech representation learning for automatic speaker verification[C] // Proceedings of the 2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Singapore: IEEE, 2022: 6147-6151.

|

| [17] |

NOVOSELOV S, LAVRENTYEVA G, AVDEEVA A, et al. Robust speaker recognition with transformers using wav2vec 2.0[Z/OL]. (2022-03-28)[2023-12-28]. https://arxiv.org/abs/2203.15095.

|

| [18] |

NAGRANI A, CHUNG J S, XIE W D, et al. VoxCeleb: Large-scale speaker verification in the wild[J]. Computer Speech & Language, 2020, 60: 101027. |

| [19] |

CHUNG J S, NAGRANI A, ZISSERMAN A. VoxCeleb2: Deep speaker recognition[C] // Proceedings of the 19th Annual Conference of the International Speech Communication Association. Hyderabad, India: ISCA, 2018: 1086-1090.

|

| [20] |

CHAPELLE O, SCHOLKOPF B, ZIEN A. Semi-supervised learning[J]. IEEE Transactions on Neural Networks, 2009, 20(3): 542. |

| [21] |

INOUE N, GOTO K. Semi-supervised contrastive learning with generalized contrastive loss and its application to speaker recognition[C] // Proceedings of the 2020 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA ASC). Auckland, New Zealand: IEEE, 2020: 1641-1646.

|

| [22] |

ZHANG H R, ZOU Y X, WANG H L. Contrastive self-supervised learning for text-independent speaker verification[C] // Proceedings of the 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, Canada: IEEE, 2021: 6713-6717.

|

| [23] |

CHEN Z C, WANG J, HU W X, et al. Unsupervised speaker verification using pre-trained model and label correction[C] // Proceedings of the ICASSP IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Rhodes Island, Greece: IEEE, 2023: 1-5.

|

| [24] |

CAI D W, WANG W Q, LI M. An iterative framework for self-supervised deep speaker representation learning[C] // Proceedings of the 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, Canada: IEEE, 2021: 6728-6732.

|

| [25] |

TAO R J, LEE K A, DAS R K, et al. Self-supervised speaker recognition with loss-gated learning[C] // Proceedings of the 2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Singapore: IEEE, 2022: 6142-6146.

|

| [26] |

HAN B, CHEN Z Y, QIAN Y M. Self-supervised speaker verification using dynamic loss-gate and label correction[C] // Proceedings of the 23rd Annual Conference of the International Speech Communication Association. Incheon, South of Korea: ISCA, 2022: 4780-4784.

|

| [27] |

ROSVALL M, BERGSTROM C T. Maps of random walks on complex networks reveal community structure[J]. Proceedings of the National Academy of Sciences of the United States of America, 2008, 105(4): 1118-1123. |

| [28] |

FAN Z Y, LI M, ZHOU S Y, et al. Exploring wav2vec 2.0 on speaker verification and language identification[C] // Proceedings of the 22nd Annual Conference of the International Speech Communication Association. Brno, Czechia: ISCA, 2021: 1509-1513.

|

| [29] |

CHEN S Y, WU Y, WANG C Y, et al. Why does self-supervised learning for speech recognition benefit speaker recognition[C] // Proceedings of the 23rd Annual Conference of the International Speech Communication Association. Incheon, South of Korea: ISCA, 2022: 3699-3703.

|

| [30] |

XIANG X, WANG S, HUANG H J, et al. Margin matters: Towards more discriminative deep neural network embeddings for speaker recognition[C] // Proceedings of the 2019 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA ASC). Lanzhou, China: IEEE, 2019: 1652-1656.

|

| [31] |

TONG F C, ZHAO M, ZHOU J F, et al. ASV-SUBTOOLS: Open source toolkit for automatic speaker verification[C] // Proceedings of the 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto, Canada: IEEE, 2021: 6184-6188.

|