2. 安徽工业大学 安徽省工业互联网智能应用与安全工程研究中心, 马鞍山 243032;

3. 安徽理工大学 计算机科学与工程学院, 淮南 232000;

4. 合肥综合性国家科学中心 人工智能研究院, 合肥 240088;

5. 淮南联合大学 信息工程学院, 淮南 232000

2. Anhui Engineering Research Center for Intelligent Applications and Security of Industrial Internet, Anhui University of Technology, Ma'anshan 243032, China;

3. School of Computer Science and Engineering, Anhui University of Science & Technology, Huainan 232000, China;

4. Institute of Artificial Intelligence, Hefei Comprehensive National Science Center, Hefei 240088, China;

5. School of Information Engineering, Huainan Union University, Huainan 232000, China

神经网络技术的飞速发展使得人们越来越关注模型本身的安全问题[1-3]。随着GPT-2(generative pre-trained transformer-2)[4]、BERT(bidirectional encoder representations from transformers)[5]、ChatGPT(chat generative pre-trained transformer)[6]等预训练语言模型的出现,再度将业内学者的目光吸引到了自然语言处理(natural language processing, NLP)领域的对抗样本生成。对抗样本生成起源于图像领域[7],指通过在原始图像中添加细微扰动,生成看似无差异但能诱导神经网络模型产生错误分类的图像的技术。而文本对抗样本生成与图像对抗样本生成类似,主要作用于NLP领域,不仅会影响分类模型的准确率,也威胁着关系抽取和文本生成等下游任务的安全[8]。

目前,中文对抗样本生成方法可以归结为替换、删除字词[9-10]、词序调整[11]等。此类方法生成的对抗样本在一定程度上影响了模型的分类结果,但依旧存在扰动幅度大,语义空间中的信息偏差大,致使样本易被识别的缺陷。故亟需一种能够最大程度影响模型分类精度,且具有高语义保留的高质量中文对抗样本生成方法,这一直是业内学者的研究热点。

无论图像或文本的对抗样本生成,均是通过分析原始样本,进而生成与原始样本视觉上类似但机器会识别出较大信息偏差的对抗样本。对抗样本的生成过程与扩散模型[12-13]高度类似。扩散模型通过模拟自然界中常见的扩散过程来合成新数据,通过向噪声数据中添加细节的扩散过程来生成复杂数据,再通过反向逆扩散生成新的数据。扩散模型的有效性已经在目标检测[14-15]和自然语言处理[16-17]等多个领域得到验证。

针对目前中文对抗样本生成方法中存在的问题,本文受Gong等[16-17]工作的启发,将扩散模型引入到中文对抗样本生成中,提出基于攻击引导扩散的中文对抗样本生成方法DiffuAdv。DiffuAdv通过在模拟文本对抗样本攻击的过程中关注数据分布的细微变化,进而强化了生成对抗样本的扩散机制。利用从原始样本到对抗样本的变化梯度作为导向条件,不仅揭示了样本之间的细腻差异,也为模型学习提供了直接的方向。在模型的预训练阶段,利用变化梯度来引导模型的逆扩散过程,确保了生成的对抗样本既自然真实又具有高效的攻击能力。针对3个公开数据集使用8种对抗样本生成方法生成对抗样本,在文本情感分类、因果关系抽取和情感原因对抽取任务上,分别采用4种分类或抽取方法进行对比实验,验证了本文方法的先进性。同时,通过消融实验证明了利用原始样本与原对抗样本之间变化梯度指引逆扩散过程来生成新对抗样本的有效性。

1 相关工作 1.1 中文对抗样本生成中文对抗样本方面,张顺香等[8]针对中文中存在的多音字提出一种基于多音字替换的对抗样本生成方法PGAS,能够生成与原始样本外形一样但信息不同的对抗样本,但由于样本存在多音字的概率比较低,致使生成的对抗样本数量稀少;韩子屹等[9]提出一种在对抗样本生成的不同阶段,对对抗样本进行视觉相似度和语义相似度进行约束的对抗攻击方法MCGC;夏倪明等[10]则全面分析表音文字和意音文字之间的差异,结合汉语的构字法、字音、字形、认知语言学等先验知识,提出一种基于启发式算法的对抗样本生成方法BSCA;Song等[11]提出一种基于差分进化的两阶段频域生成算法,用于黑盒对抗样本的生成,旨在提高对抗样本的生成效率和有效性;Liang等[18]依据输入数据的词向量梯度来选择删除或插入位置;Ebrahimi等[19]最早使用同义词来替换原词进行对抗样本生成,但是由于原句能替换的同义词较少,导致生成的对抗样本数量少;Liu等[20]通过分析中文和英文对抗样本生成方法的特点,提出一种结合字形和字音的对抗样本生成方法Argot。但上述方法均存在生成对抗样本质量不高且成功率较低的问题。

1.2 扩散模型扩散模型作为一种强大且通用的生成式人工智能技术,在计算机视觉(computer vision,CV)、NLP等领域都取得了巨大的成功[21]。利用扩散模型生成较为完整文本的工作是Gong等提出的DiffuSeq[16]和DiffuSeq-v2[17]方法。Gong等针对扩散模型在连续信号中的成功应用,借助条件扩散模型[22],提出基于Seq2Seq文本生成任务的扩散模型。通过模拟如何从无序状态生成具有特定结构的文本序列,解决了扩散模型难以进行文本生成的难题。在条件引导中,Ajay等[23]提出决策扩散(decision diffuser)使生成结果呈现有条件的轨迹,其将奖励、限制或技能作为引导并增强Diffuser的性能。胡忠义等[24]提出改进扩散模型的方法来生成中文文本。而陈子民等[25]则是将条件扩散模型应用到图像分类的对抗样本防御中。何琨等[26]提出了基于引导扩散模型的自然对抗补丁的生成方法,与文本对抗样本生成有着异曲同工之处。上述扩散模型的相关工作均证实了扩散模型在文本对抗样本领域有着巨大的发展空间。

基于中文对抗样本生成和扩散模型在条件引导方面的研究,可以发现利用条件引导生成中文对抗样本具有坚实的理论基础。因此,可以通过原始文本与对抗样本之间的变化信息来生成更有效的中文对抗样本。

2 本文方法 2.1 问题定义设X为原始中文文本映射出的文本输入空间,xori为X中的原始样本,Y为对应的标签空间,f: X→Y为训练好的学习模型。若xori∈X且f(xori)=y,则认为该分类结果正确。而中文对抗样本生成的目标是通过找到扰动

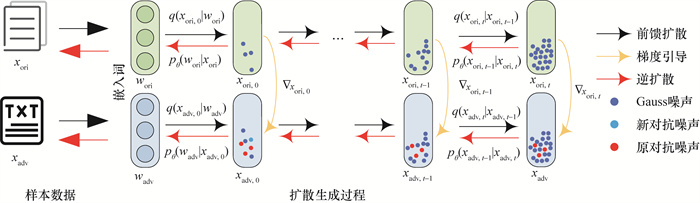

本文提出的基于攻击引导扩散的中文对抗样本生成方法DiffuAdv框架如图 1所示。

|

| 图 1 DiffuAdv框架 |

训练阶段,针对输入的样本数据x进行数据捕获及特征学习,x包括xori和xadv。DiffuAdv首先捕获并学习xori的数据分布,并分析能进行对抗样本攻击的xadv是如何偏离该分布的。具体的,DiffuAdv将xori与xadv转化为一个连续空间的表示形式,并在这个空间中模拟对抗样本生成过程(由xori转变为xadv)时的扩散概率pθ(xt-1|xt, |y)。在模拟阶段完成后,逆向扩散过程开始,模型逐渐从噪声状态恢复成清晰的文本表示。此过程受条件引导控制,使用变化梯度进行引导,以确保生成的对抗样本具有高攻击成功率。

在逆扩散过程中首先计算目标模型的损失梯度。根据分类器模型计算出对抗样本生成时的损失函数相对于输入样本xori的梯度

从表 1中可以看出,当对原始句子“他听着音乐,一边随着节奏摇摆。”进行情感分类时,分类结果为积极,但是由其生成出的对抗样本“他听着音乐,—边随着节奏揺摆。”将“摇”逐步扩散变为“揺”,“一”扩散变为了“—”。再对其进行情感分类时,情感极性发生了变化。在原始样本中,“摇”具有积极的情感含义,而当“摇”被扩散为“揺”后,句子整体含义未变,但机器解析其嵌入向量时获取的含义不同,从而影响情感分类结果。这一典型案例说明了本文方法的有效性。

2.2.1 数据捕获DiffuAdv要借用g来指导逆扩散过程,就必须对xori的数据分布pdata(xori)进行捕获并学习,并明确xadv如何偏离该分布。

设x所在的数据集D包含了大量xori和xadv,其中xori均服从分布pdata(xori)。DiffuAdv的首要任务是通过学习D来理解并模拟该分布,其通过最大化D的似然度完成,即通过最大化以下目标实现:

| $ L_{\text {ori }}(D ; \theta)=\frac{1}{|D|} \sum\limits_{x_{\text {ori }} \in D} \ln p_{\text {model }}\left(x_{\text {ori }} ; \theta\right) . $ | (1) |

其中pmodel(xori; θ)代表了由模型参数θ定义的文本数据分布。

同时,要了解能成功实现样本攻击的xadv如何偏离xori的分布,需要对对抗样本xadv的数据分布进行学习。对任意的xadv都需要评估其与ori的差异,通过度量xadv在模型分布pmodel下的似然度得到,计算公式为

| $ L_{\mathrm{adv}}(D ; \theta)=\frac{1}{|D|} \sum\limits_{x_{\mathrm{adv}} \in D} \ln p_{\mathrm{model}}\left(x_{\mathrm{adv}} ; \theta\right) . $ | (2) |

xadv与xori之间的分布有着显著差异,故仅需比较Lori(D; θ)与Ladv(D; θ)之间的不同,即可识别出二者分布的偏离程度。

2.2.2 扩散训练扩散训练阶段是DiffuAdv的关键部分。该阶段的目标是训练一个扩散模型来学习和模拟数据的分布特征,以及攻击过程中可能出现的扩散概率。先将文本数据由离散表示形式转换为连续空间中的表示,然后在此空间模拟概率扩散。整个扩散训练阶段包括两个部分,分别是正向扩散过程以及受攻击引导的逆向生成过程。

1) 正向扩散过程。

正向扩散首先向输入数据xori引入噪声,直至数据分布达到均匀分布。此过程用Markov链来描述。具体来说,用q(xt|xt-1)来描述时间步(t-1)的数据xt-1扩散到时间步t的数据xt。该过程由加性Gauss噪声控制,计算公式为

| $ q\left(x_t \mid x_{t-1}\right)=\mathcal{N}\left(x_t ; \sqrt{1-\beta_t} x_{t-1}, \beta_t \boldsymbol{I}\right) . $ | (3) |

其中:βt为噪声增量参数,I代表单位矩阵。随着时间步的推移,噪声比例逐步增加,受控的参数βt确保了数据分布从pmodel逐渐过渡到均匀分布。

2) 逆扩散过程。

逆扩散阶段也可称为逆向生成阶段,负责逐步从噪声状态恢复成样本状态。这一过程同样依赖Markov链逆转,具体是指使用似然度pθ(xt-1|xt)来估计给定xt的条件下xt-1的条件概率分布。逆向扩散过程中,pθ(xt-1|xt)由神经网络参数化,其中参数θ在训练过程中通过最大化pθ(xt-1|xt)来学习。

| $ p_\theta\left(x_{t-1} \mid x_t\right)=\mathcal{N}\left(x_{t-1} ; \mu_\theta\left(x_t, t\right), \varSigma_\theta\left(x_t, t\right)\right) . $ | (4) |

其中μθ(xt, t)和Σθ(xt, t)分别表示逆向扩散过程中由参数θ控制的均值和协方差。

3) 攻击引导模块。

在对抗样本的攻击引导中,为了使得生成的样本不仅从视觉上类似于真实样本,而且能够导致分类错误,需要对逆扩散的扩散方向进行引导修正。攻击引导模块(attack-guided module)负责在逆扩散过程中紧密关注模型逆扩散生成阶段的状态,确保在去除噪声的同时引入具有意图性的扰动。

该模块将g作为条件输入,生成的对抗样本与原始样本相似但有所不同,从而使下游任务结果发生改变。该引导条件确保逆扩散过程能够沿着提高攻击成功率的方向进行,具体可通过计算θ实现。

| $ \begin{aligned} \theta^*= & \underset{\theta}{\operatorname{argmin}} E_{q\left(x_t \mid x_0\right)} \sum\limits_{t=1}^T \| f_\theta\left(x_{t-1} \mid x_t, \right. \\ & \left.\nabla_{x_t} L\left(\theta, x_t, y\right)\right)-x_{t-1} \|_2^2 . \end{aligned} $ | (5) |

其中:Eq(xt|x0)表示在给定初始样本x0的条件下,扩散过程最终状态xt的期望;fθ为由模型参数θ决定的条件转移函数,根据扩散样本xt及g来估计前一时间步的样本xt-1。

时间步(t-1)生成的对抗样本可以表示为

| $ x_{\mathrm{adv}, t-1}=\mu_\theta\left(x_t, t\right)+\sigma_t \odot_\epsilon+\eta \nabla_{x_t} L\left(\theta, x_t, y\right) . $ | (6) |

其中:

DiffuAdv通过结合正向扩散过程引入的噪声和条件引导模块的引导条件,令逆向扩散过程能够对原始数据分布进行精准的估计,并向其引入目的性强的扰动来生成对抗样本。通过调整和优化模型参数,使得在每一步的逆向扩散过程中,都能精准地估计并追踪数据的原始分布。同时使对抗样本是在约束下生成的,以确保生成的对抗样本要同时满足与原始样本高度相似且拥有高攻击成功率的特性。

2.2.3 损失函数损失函数L(·)需要在原始样本和对抗样本上同时优化,从而提高模型在对抗样本上的鲁棒性,则综合损失函数表示为

| $ L_{\text {total }}=L\left(\theta, x_{\text {ori }}, y\right)+\lambda L\left(\theta, x_{\text {adv }}, y\right) $ | (7) |

其中λ是超参数。

3 实验结果及分析为了验证本文所提DiffuAdv方法的有效性,对文本情感分类[27]、因果关系抽取[28]及情感原因对抽取(ECPE)[29-30]等3个任务进行实验。

3.1 实验准备 3.1.1 数据集实验针对3个任务,选用3个公开的数据集:酒店评论数据集(https://github.com/m220745/keras-sentiment-analysis)、金融因果关系抽取数据集(https://tianchi.aliyun.com/dataset/dataDetail?dataId=110901)、情感原因对抽取数据集(https://paperswithcode.com/dataset/ecpe-xia-and-ding-2019)。对这3个公开数据集分别抽取出3 000条样本,构成原始数据集,然后均按照7∶1∶2的样本数比例划分为训练集、验证集和测试集。

3.1.2 实验设置实验在云服务器上进行,其中CPU和GPU分别为Intel Xeon CPU E5-2680 v4 64GB 56核和Tesla P4(8GB显存)。默认扩散步长为1 000,批处理大小为16。文本处理方式按照文[16]的方式进行。

3.1.3 评价指标本文采用准确率(Acc)和困惑度(PPL)[31]进行生成对抗样本有效性的度量。其中,Acc用于观察所生成的对抗样本在不同任务上对不同模型所造成的影响;PPL用于衡量生成对抗样本句子合理性程度,其值越低,表示生成的文本越接近自然语言文本,合理性和可读性越高。

3.2 对比方法为验证DiffuAdv方法的有效性,将其与中文对抗样本生成领域的相关方法进行比较,具体对比方法如下:

1) DiffuSeq[16]:应用扩散模型的思想来生成连贯和高质量的文本。

2) CWC[32]:主要针对形近字替换,运用ConvAE对汉字进行视觉向量嵌入,生成形近字的替换候选池;并使用USE语义约束来确保对抗样本的语义不偏离。

3) GA[33]:利用同义词和近义词替换并进行句法结构调整来生成对抗样本,为了使影响效果最大化,还添加了语境干扰来误导模型。

4) PGAS [8]:字符级的中文对抗样本生成方法,主要使用多音字来对原始样本中的中文进行替换。

5) WHD[34]:提出一种新的词语重要性计算算法,并运用同音词替换生成对抗样本,在黑盒模式下进行测试,增强了分类模型的鲁棒性。

6) CWA[35]:依据文本数据的语义和语法特征,找到对分类结果影响较大的关键词,并通过同义词替换、词序调整等技术改变关键词,生成对抗样本。

7) BERT-ATTACK [36]:针对以BERT为代表的预训练语言模型进行快速有效地生成对抗样本。

3.3 攻击实验在不同任务上分别使用4种分类或抽取方法进行实验,对Acc进行比较。首先,分类或抽取方法在原始数据集的测试集上实验,获得Acc。然后,使用对比的7种攻击样本生成方法分别对原始数据集的样本生成对抗样本,构成对抗样本数据集,也划分为对应的训练集、验证集和测试集;分类或抽取方法在对抗样本数据集的测试集上实验,获得Acc。最后,针对原始数据训练集和验证集中的每条样本,从其对应的7条对抗样本中随机挑选出1条,与原始样本构成样本对,组成2 100条样本对的训练集和300条样本对的验证集,用于DiffuAdv调参,调参后使用DiffuAdv对原始数据测试集生成对抗样本测试集,供分类或抽取方法实验,获得Acc。

由表 2可以看出,在文本情感分类任务上不同分类方法在原始数据测试集上Acc均超过93%,这说明分类方法在情感分类任务上表现出色。然而,在对抗样本数据测试集上,各分类方法的Acc均明显下降,这表明对抗样本对分类方法产生了显著的干扰。其中,DiffuAdv表现尤为突出,攻击效果显著。

| % | |||||||||||||||||||||||||||||

| 方法 | 原始数据测试集 | 对抗样本数据测试集 | |||||||||||||||||||||||||||

| DiffuSeq | CWC | GA | PGAS | WHD | CWA | BERT-ATTACK | DiffuAdv | ||||||||||||||||||||||

| 文[37] | 94.63 | 81.32 | 72.23 | 63.54 | 64.40 | 62.60 | 69.97 | 72.84 | 59.47 | ||||||||||||||||||||

| 文[27] | 95.37 | 80.09 | 74.49 | 64.80 | 67.35 | 69.55 | 68.04 | 74.58 | 60.09 | ||||||||||||||||||||

| 文[38] | 93.21 | 82.91 | 70.68 | 63.72 | 70.51 | 75.14 | 64.38 | 79.04 | 58.32 | ||||||||||||||||||||

| 文[39] | 94.69 | 79.06 | 69.82 | 72.91 | 68.98 | 68.19 | 73.58 | 72.36 | 59.91 | ||||||||||||||||||||

表 3展示的是在因果关系抽取任务上,不同抽取方法在不同测试集上的Acc。可以发现,包括DiffuAdv在内的8种对抗样本生成方法均会导致4种抽取方法的Acc下降,表明它们能够有效干扰抽取方法的性能。DiffuSeq对4种抽取方法的攻击效果最弱。PGAS和CWC对4种抽取方法的攻击效果相对不稳定。DiffuAdv对文[40]方法Acc的降低比例比对其他3种抽取方法的小,说明对文[40]方法的攻击效果最弱。

| % | |||||||||||||||||||||||||||||

| 方法 | 原始数据测试集 | 对抗样本数据测试集 | |||||||||||||||||||||||||||

| DiffuSeq | CWC | GA | PGAS | WHD | CWA | BERT-ATTACK | DiffuAdv | ||||||||||||||||||||||

| 文[28] | 90.32 | 79.64 | 62.64 | 61.69 | 67.26 | 62.60 | 62.33 | 70.08 | 63.06 | ||||||||||||||||||||

| 文[40] | 94.25 | 85.21 | 74.31 | 67.40 | 69.45 | 65.02 | 74.42 | 73.66 | 68.55 | ||||||||||||||||||||

| 文[41] | 92.07 | 83.06 | 62.91 | 64.88 | 65.80 | 62.77 | 61.92 | 73.21 | 61.92 | ||||||||||||||||||||

| 文[42] | 93.61 | 87.09 | 61.81 | 73.95 | 72.42 | 62.78 | 63.07 | 72.49 | 64.37 | ||||||||||||||||||||

表 4展示了在情感原因对抽取任务上,不同抽取方法在不同测试集上的Acc。可以发现,各抽取方法在不同对抗样本测试集上的Acc比在原始数据测试集上均下降。PGAS对文[43]方法导致的Acc下降比例最大,而对其他3种抽取方法的攻击效果均弱于DiffuAdv。从不同抽取方法的Acc下降比例来看,CWA和PGAS的攻击效果相对稳定,其他方法的攻击效果相对不稳定,其中WHD最不稳定。DiffuAdv对4种抽取方法上的攻击稳定性仅比CWA和PGAS稍弱,这表明该方法不仅能够有效实施攻击,也能保持较好的鲁棒性。

| % | |||||||||||||||||||||||||||||

| 方法 | 原始数据测试集 | 对抗样本数据测试集 | |||||||||||||||||||||||||||

| DiffuSeq | CWC | GA | PGAS | WHD | CWA | BERT-ATTACK | DiffuAdv | ||||||||||||||||||||||

| 文[43] | 94.13 | 76.55 | 59.65 | 71.08 | 58.01 | 70.36 | 69.32 | 79.42 | 59.55 | ||||||||||||||||||||

| 文[44] | 92.55 | 82.13 | 64.05 | 66.28 | 59.31 | 68.92 | 65.03 | 72.84 | 57.34 | ||||||||||||||||||||

| 文[45] | 93.25 | 73.68 | 70.02 | 70.21 | 69.70 | 69.51 | 65.94 | 69.77 | 62.91 | ||||||||||||||||||||

| 文[46] | 94.38 | 77.94 | 64.36 | 69.32 | 70.73 | 71.36 | 73.04 | 74.52 | 64.08 | ||||||||||||||||||||

3.4 消融实验

DiffuAdv方法在3个任务上的攻击实验验证了其有效性,但无法确定其效果是否由攻击引导模块产生,为此设置消融实验进行验证。实验依旧在3个任务上进行。消融实验结果见表 5,表中实验结果均选取各个任务中多种分类或抽取方法的最优值。

| % | |||||||||||||||||||||||||||||

| 方法 | 文本情感分类 | 因果关系抽取 | ECPE | ||||||||||||||||||||||||||

| DiffuAdv w/o attack-guided | 85.28 | 84.07 | 88.16 | ||||||||||||||||||||||||||

| DiffuAdv | 58.32 | 61.92 | 57.34 | ||||||||||||||||||||||||||

由表 5可知,添加了攻击引导模块后,所有3个任务领域的分类或抽取方法的性能都显著下降。这种性能下降表明,攻击引导模块能够有效地利用所生成文本中的干扰信息,通过识别并放大这些干扰信息,使得生成的对抗样本能够更强地干扰分类、抽取方法的预测结果,从而对原任务的结果产生更大影响。结果证明了DiffuAdv在生成高质量对抗样本方面的有效性。

3.5 样本生成质量度量为了更好地衡量对抗样本生成的质量,将DiffuAdv与其他几种生成方法进行PPL比较。表 6给出了不同方法在3个任务上各生成1 000条对抗样本的平均PPL。

| 方法 | 平均PPL |

| WHD | 0.632 |

| CWA | 0.613 |

| DiffuSeq | 0.524 |

| GA | 0.654 |

| PGAS | 0.536 |

| BERT-ATTACK | 0.539 |

| CWC | 0.583 |

| DiffuAdv | 0.518 |

从表 6可以看出,不同方法生成的对抗样本的平均PPL存在一定差异。平均PPL越低,表示模型生成的文本越接近自然语言文本,合理性和可读性越高。DiffuAdv生成的对抗样本平均PPL值最低,说明其生成的对抗样本在合理性和可读性方面优于其他方法,在语言流畅性和自然度上更接近真实文本。

总体来看,DiffuAdv能够为下游任务提供更具挑战性且自然的对抗样本。虽然各方法的平均PPL相差不大,但在对抗样本生成的背景下,细微的平均PPL差异也可能带来显著的性能提升和更自然的文本体验。

4 结论本文提出了基于攻击引导扩散的中文对抗样本生成方法DiffuAdv。通过利用原始样本与对抗样本之间的渐变梯度作为引导条件,来指导扩散模型生成新的对抗样本。实验结果表明,DiffuAdv相比已有方法,不仅攻击成功率高,生成样本可读性也强。该方法拓宽了扩散模型在文本生成领域的应用方向,为对抗样本生成提供了新的技术思路,但由于扩散模型的复杂性,依旧存在生成对抗样本速度较慢的缺陷。下一步将根据样本的复杂性动态调整生成过程中的计算负荷,以加快对抗样本生成的速度。

| [1] |

ALMIANI M, ABUGHAZLEH A, JARARWEH Y, et al. Resilient back propagation neural network security model for containerized cloud computing[J]. Simulation Modelling Practice and Theory, 2022, 118: 102544. DOI:10.1016/j.simpat.2022.102544 |

| [2] |

SAGU A, GILL N S, GULIA P. Hybrid deep neural network model for detection of security attacks in IoT enabled environment[J]. International Journal of Advanced Computer Science and Applications, 2022, 13(1): 120-127. |

| [3] |

XIONG Z B, CAI Z P, HU C Q, et al. Towards neural network-based communication system: Attack and defense[J]. IEEE Transactions on Dependable and Secure Computing, 2023, 20(4): 3238-3250. DOI:10.1109/TDSC.2022.3203965 |

| [4] |

RADFORD A, WU J, CHILD R, et al. Language models are unsupervised multitask learners[EB/OL]. (2019-06-11)[2024-04-18]. https://cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pdf.

|

| [5] |

DEVLIN J, CHANG M W, LEE K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Minneapolis, USA: NAACL-HLT, 2019: 4171-4186.

|

| [6] |

OPENAI. ChatGPT (GPT-4 turbo version)[Large language model][R/OL]. (2022-11-30)[2024-03-22]. https://chat.openai.com/chat.

|

| [7] |

ZHANG J P, HUANG J T, WANG W X, et al. Improving the transferability of adversarial samples by path-augmented method[C]//Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver, Canada: IEEE, 2023: 8173-8182.

|

| [8] |

张顺香, 吴厚月, 朱广丽, 等. 面向中文文本分类的字符级对抗样本生成方法[J]. 电子与信息学报, 2023, 45(6): 2226-2235. ZHANG S X, WU H Y, ZHU G L, et al. Character-level adversarial samples generation approach for Chinese text classification[J]. Journal of Electronics & Information Technology, 2023, 45(6): 2226-2235. (in Chinese) |

| [9] |

韩子屹, 王巍, 玄世昌. 多约束引导的中文对抗样本生成[J]. 中文信息学报, 2023, 37(2): 41-52. HAN Z Y, WANG W, XUAN S C. Chinese adversarial example generation guided by multi-constraints[J]. Journal of Chinese Information Processing, 2023, 37(2): 41-52. (in Chinese) |

| [10] |

夏倪明, 张洁. 基于自适应集束搜索算法的中文对抗样本生成[J/OL]. 计算机工程. (2024-05-29)[2024-06-20]. https://link.cnki.net/doi/10.19678/j.issn.1000-3428.0069348. XIA N M, ZHANG J. Chinese text adversarial examples generation based on adaptive beam search[J/OL]. Computer Engineering. (2024-05-29)[2024-06-20]. https://link.cnki.net/doi/10.19678/j.issn.1000-3428.0069348. (in Chinese) |

| [11] |

SONG X F, XU D H, PENG C, et al. A two-stage frequency-domain generation algorithm based on differential evolution for black-box adversarial samples[J]. Expert Systems with Applications, 2024, 249: 123741. DOI:10.1016/j.eswa.2024.123741 |

| [12] |

HOOGEBOOM E, NIELSEN D, JAINI P, et al. Argmax flows and multinomial diffusion: Learning categorical distributions[C]//Proceedings of the 35th International Conference on Neural Information Processing Systems. Virtual Event: Curran Associates Inc., 2021: 12454-12465.

|

| [13] |

AUSTIN J, JOHNSON D D, HO J, et al. Structured denoising diffusion models in discrete state-spaces[C]//Proceedings of the 34th Annual Conference on Neural Information Processing Systems. Virtual Event: Curran Associates Inc., 2021: 17981-17993.

|

| [14] |

CHEN S F, SUN P Z, SONG Y B, et al. DiffusionDet: Diffusion model for object detection[C]//Proceedings of the 2023 IEEE/CVF International Conference on Computer Vision. Paris, France: IEEE, 2023: 19773-19786.

|

| [15] |

HO C J, TAI C H, LIN Y Y, et al. Diffusion-SS3D: Diffusion model for semi-supervised 3D object detection[C]//Proceedings of the 37th International Conference on Neural Information Processing Systems. New Orleans, LA, USA: Curran Associates Inc., 2024: 2134.

|

| [16] |

GONG S S, LI M K, FENG J T, et al. DiffuSeq: Sequence to sequence text generation with diffusion models[C]//Proceedings of the 11th International Conference on Learning Representations (ICLR). Kigali, Rwanda: ICLR, 2023.

|

| [17] |

GONG S S, LI M K, FENG J T, et al. DiffuSeq-v2: Bridging discrete and continuous text spaces for accelerated seq2seq diffusion models[C] //Findings of the Association for Computational Linguistics: EMNLP. Singapore: ACL, 2023: 9868-9875.

|

| [18] |

LIANG B, LI H C, SU M Q, et al. Deep text classification can be fooled[C]//Proceedings of the 27th International Joint Conference on Artificial Intelligence. Stockholm, Sweden: AAAI Press, 2018: 4208-4215.

|

| [19] |

EBRAHIMI J, RAO A Y, LOWD D, et al. HotFlip: White-box adversarial examples for text classification[C]//Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics. Melbourne, Australia: ACL, 2018: 31-36.

|

| [20] |

LIU M X, ZHANG Z H, ZHANG Y M, et al. Automatic generation of adversarial readable Chinese texts[J]. IEEE Transactions on Dependable and Secure Computing, 2023, 20(2): 1756-1770. DOI:10.1109/TDSC.2022.3164289 |

| [21] |

CHEN M S, MEI S, FAN J Q, et al. An overview of diffusion models: Applications, guided generation, statistical rates and optimization[EB/OL]. (2024-04-16)[2024-05-18]. https://doi.org/10.48550/arXiv.2404.07771.

|

| [22] |

DHARIWAL P, NICHOL A. Diffusion models beat GANs on image synthesis[C]//Proceedings of the 35th International Conference on Neural Information Processing Systems. Virtual Event: Curran Associates Inc., 2021: 8780-8794.

|

| [23] |

AJAY A, DU Y L, GUPTA A, et al. Is conditional generative modeling all you need for decision making?[C]//Proceedings of the 11th International Conference on Learning Representations. Kigali, Rwanda: ICLR, 2023: 4940.

|

| [24] |

胡忠义, 秦维, 吴江. 基于改进扩散模型的电商营销文本的自动生成研究[J/OL]. 数据分析与知识发现. (2024-04-16)[2024-04-20]. http://kns.cnki.net/kcms/detail/10.1478.G2.20240415.1125.002.html. HU Z Y, QIN W, WU J. Automatic generation of e-commerce marketing text based on improved diffusion model[J/OL]. Data Analysis and Knowledge Discovery. (2024-04-16)[2024-04-20]. http://kns.cnki.net/kcms/detail/10.1478.G2.20240415.1125.002.html. (in Chinese) |

| [25] |

陈子民, 关志涛. 基于条件扩散模型的图像分类对抗样本防御方法[J/OL]. 计算机工程. (2024-03-26)[2024-04-19]. https://link.cnki.net/doi/10.19678/j.issn.1000-3428.0068512. CHEN Z M, GUAN Z T. Image classification adversarial defense based on classifier-free diffusion model[J/OL]. Computer Engineering. (2024-03-26)[2024-04-19]. https://link.cnki.net/doi/10.19678/j.issn.1000-3428.0068512. (in Chinese) |

| [26] |

何琨, 佘计思, 张子君, 等. 基于引导扩散模型的自然对抗补丁生成方法[J]. 电子学报, 2024, 52(2): 564-573. HE K, SHE J S, ZHANG Z J, et al. A guided diffusion-based approach to natural adversarial patch gen-eration[J]. Acta Electronica Sinica, 2024, 52(2): 564-573. (in Chinese) |

| [27] |

徐瑞, 曾诚, 程世杰, 等. 基于双三元组网络的易混淆文本情感分类方法[J]. 中文信息学报, 2024, 38(1): 135-145. XU R, ZENG C, CHENG S J, et al. Double triplet network for confusing text sentiment classification[J]. Journal of Chinese Information Processing, 2024, 38(1): 135-145. (in Chinese) |

| [28] |

朱广丽, 许鑫, 张顺香, 等. PosNet: 基于位置的因果关系抽取网络[J]. 计算机科学, 2022, 49(12): 305-311. ZHU G L, XU X, ZHANG S X, et al. PosNet: Position-based causal relation extraction network[J]. Computer Science, 2022, 49(12): 305-311. (in Chinese) |

| [29] |

SU X X, HUANG Z, ZHAO Y X, et al. Recent trends in deep learning-based textual emotion cause extraction[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2023, 31: 2765-2786. |

| [30] |

SHANG X C, CHEN C X, CHEN Z P, et al. Modularized mutuality network for emotion-cause pair extraction[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2023, 31: 539-549. |

| [31] |

何天文, 王红. 基于语义语法分析的中文语句困惑度评价[J]. 计算机应用研究, 2017, 34(12): 3538-3542, 3546. HE T W, WANG H. Evaluating perplexity of Chinese sentences based on grammar & semantics analysis[J]. Application Research of Computers, 2017, 34(12): 3538-3542, 3546. (in Chinese) |

| [32] |

李相葛, 罗红, 孙岩. 基于汉语特征的中文对抗样本生成方法[J]. 软件学报, 2023, 34(11): 5143-5161. LI X G, LUO H, SUN Y. Adversarial sample generation method based on Chinese features[J]. Journal of Software, 2023, 34(11): 5143-5161. (in Chinese) |

| [33] |

OU H X, YU L, TIAN S W, et al. Chinese adversarial examples generation approach with multi-strategy based on semantic[J]. Knowledge and Information Systems, 2022, 64(4): 1101-1119. |

| [34] |

王文琦, 汪润, 王丽娜, 等. 面向中文文本倾向性分类的对抗样本生成方法[J]. 软件学报, 2019, 30(8): 2415-2427. WANG W Q, WANG R, WANG L N, et al. Adversarial examples generation approach for tendency classification on Chinese texts[J]. Journal of Software, 2019, 30(8): 2415-2427. (in Chinese) |

| [35] |

仝鑫, 王罗娜, 王润正, 等. 面向中文文本分类的词级对抗样本生成方法[J]. 信息网络安全, 2020, 20(9): 12-16. TONG X, WANG L N, WANG R Z, et al. A generation method of word-level adversarial samples for Chinese text classiifcation[J]. Netinfo Security, 2020, 20(9): 12-16. (in Chinese) |

| [36] |

LI L Y, MA R T, GUO Q P, et al. BERT-ATTACK: Adversarial attack against Bert using Bert[C]//Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP). Virtual Event: ACL, 2020: 6193-6202.

|

| [37] |

张千锟, 韩虎, 郝俊. 基于双注意力融合知识的方面级情感分类[J]. 计算机工程与科学, 2023, 45(10): 1866-1873. ZHANG Q K, HAN H, HAO J. Aspect-level sentiment classification based on dual attention fusion knowledge[J]. Computer Engineering and Science, 2023, 45(10): 1866-1873. (in Chinese) |

| [38] |

MAO X L, CHANG S, SHI J J, et al. Sentiment-aware word embedding for emotion classification[J]. Applied Sciences, 2019, 9(7): 1334. |

| [39] |

周艳玲, 兰正寅, 张 , 等. 融合交替归一化的细粒度情感分类研究[J]. 中文信息学报, 2023, 37(9): 140-149. ZHOU Y L, LAN Z Y, ZHANG Y, et al. Fine-grained sentiment classification based on alternating normalization[J]. Journal of Chinese Information Processing, 2023, 37(9): 140-149. (in Chinese) |

| [40] |

崔仕林, 闫蓉. 基于SoftLexicon和注意力机制的中文因果关系抽取[J]. 中文信息学报, 2023, 37(4): 81-89. CUI S L, YAN R. Chinese causality extraction based on SoftLexicon and attention mechanism[J]. Journal of Chinese Information Processing, 2023, 37(4): 81-89. (in Chinese) |

| [41] |

邓金科, 段文杰, 张顺香, 等. 基于提示增强与双图注意力网络的复杂因果关系抽取[J/OL]. 计算机应用. (2024-01-30)[2024-04-18]. http://kns.cnki.net/kcms/detail/51.1307.tp.20240129.0903.002.html. DENG J K, DUAN W J, ZHANG S X, et al. Complex causal relationship extraction based on prompt enhancement and bi-graph attention network[J/OL]. Journal of Computer Applications. (2024-01-30)[2024-04-18]. http://kns.cnki.net/kcms/detail/51.1307.tp.20240129.0903.002.html. (in Chinese) |

| [42] |

张顺香, 张镇江, 朱广丽, 等. 基于Bi-LSTM与双路CNN的金融领域文本因果关系识别[J]. 数据分析与知识发现, 2022, 6(7): 118-127. ZHANG S X, ZHANG Z J, ZHU G L, et al. Identifying financial text causality with Bi-LSTM and two-way CNN[J]. Data Analysis and Knowledge Discovery, 2022, 6(7): 118-127. (in Chinese) |

| [43] |

代建华, 邓育彬. 基于情感膨胀门控CNN的情感—原因对提取[J]. 数据分析与知识发现, 2020, 4(8): 98-106. DAI J H, DENG Y B. Extracting emotion-cause pairs based on emotional dilation gated CNN[J]. Data Analysis and Knowledge Discovery, 2020, 4(8): 98-106. (in Chinese) |

| [44] |

张思阳, 魏苏波, 孙争艳, 等. 基于多标签Seq2Seq模型的情绪—原因对提取模型[J]. 数据分析与知识发现, 2023, 7(2): 86-96. ZHANG S Y, WEI S B, SUN Z Y, et al. Extracting emotion-cause pairs based on multi-label Seq2Seq model[J]. Data Analysis and Knowledge Discovery, 2023, 7(2): 86-96. (in Chinese) |

| [45] |

LI C B, HU J, LI T R, et al. An effective multi-task learning model for end-to-end emotion-cause pair extraction[J]. Applied Intelligence, 2023, 53(3): 3519-3529. |

| [46] |

CHEN F, SHI Z W, YANG Z L, et al. Recurrent synchronization network for emotion-cause pair extraction[J]. Knowledge-Based Systems, 2022, 238: 107965. |