2. 贵州大学 公共大数据国家重点实验室, 贵阳 550025

2. State Key Laboratory of Public Big Data, Guizhou University, Guiyang 550025, China

随着人工智能的快速发展和智慧法院建设的深入,司法领域的智能化辅助成为当前研究的热点领域之一。裁判文书作为司法领域的重要文本,承载详细的人民法院的审理过程以及判决结果,涵盖刑事、民事、行政、赔偿以及执行案件等多种司法案件类型[1],是体现法官审判依据的重要载体。近年来,围绕裁判文书的数据挖掘研究已经逐渐多元化,涵盖了类案检索[2]、文书摘要生成[3]和要素抽取[4]等下游任务。在司法需求日益增加的背景下,法院日常需要处理大量的裁判文书,法官、律师等法律从业者也需要在众多案例中迅速检索到指导性案例,因此简洁明了的裁判文书摘要能帮助法院和法律从业者高效、精准地掌握案件信息。裁判文书的摘要生成已经逐渐成为司法数字化转型的核心要素之一,对推进审判体系的现代化、促进司法数字化与智能化的发展具有至关重要的作用。

在司法领域,裁判文书摘要的生成旨在对裁判文书内容进行归纳总结,以得到语言流畅、结构严谨且能完整反映案件审理过程的关键信息。目前,裁判文书摘要的生成方法多种多样,借鉴于文本摘要任务,主要可分为抽取式摘要(extractive summarization)和生成式摘要(abstractive summarization) 2种[5]。在先前的研究中,大多数学者倾向于采用先抽取后生成的策略。然而,在抽取阶段,可能会忽略关键信息;而在生成阶段,上下文的限制可能造成文本被截断,从而导致信息丢失。其他一些方法则利用结构信息进行分段摘要,生成的摘要按序拼接,但这可能导致最终摘要内容不连贯,并且段落间的语义逻辑关系丢失。这些方法的使用可能会误导后续的司法工作,造成不小的损失。如今,诸如ChatGPT[6]等大语言模型日益成熟,大语言模型基于丰富的知识库内容,以其出色的语言理解能力和文本生成能力为文本摘要任务带来了新的机遇并取得了显著的成效,尽管如此,大语言模型在司法领域的文本摘要任务,即裁判文书摘要任务上的研究仍存在空白和不小的挑战,这是因为将大语言模型应用到裁判文书摘要任务上面临以下2个问题:1) 缺乏司法领域专业知识。目前的大语言模型聚焦于通用文本分析的研究,对垂直领域的探索略显不足,极少涉及司法领域的任务如裁判文书等的摘要生成任务。相比通用文本,裁判文书具有独特的法律术语和专业词汇。目前新兴大语言模型多基于通用数据库进行训练,缺乏对司法领域专业知识的学习,因此在将其迁移到司法裁判文书摘要任务时,常常暴露出专业领域适配性不足的弊端,主要体现在模型难以理解任务目标,生成的内容容易偏离实际或产生“幻觉”。虽然通过RAG(retrieval-augmented generation)[7]策略结合如法条、类案等司法领域知识库能增强大语言模型对司法领域专业的感知,但是知识库需频繁依据最新司法动态更新维护,构建成本高,且检索匹配耗时长。裁判文书摘要任务复杂,检索匹配内容的拼接会增加输入长度,且匹配内容难以确保给裁判文书摘要生成带来正向反馈,从而进一步加剧大语言模型的幻觉与错误。2) 难以理解裁判文书结构与逻辑。如表 1下划线部分所示,裁判文书不仅遵循司法领域的特定规范,而且具备严格的逻辑结构,语言风格严谨、正式。裁判文书的摘要生产需要模型具备更强的文本理解能力和逻辑推理能力,以确保能够准确捕捉文本中的关键信息。然而,当前大语言模型对于文书内在的结构信息和各结构间复杂逻辑关系的感知能力显得较为薄弱,这是因为其缺乏对司法逻辑的理解和裁判文书结构的学习,导致在生成摘要或进行其他相关任务时,可能无法准确反映裁判文书的核心结构内容和法律逻辑,从而制约了其在司法领域的应用效果。

| 裁判文书 | 标准摘要 | 段落类型 |

| xxx股份有限公司与xxx、xxx借款合同纠纷]]>一审民事判决书 | 原被告系借款合同]]>关系 | 案件类型 |

| 原告向本院提出诉讼请求]]>:1. 依法判令被告xxx归还原告借款本金xx万元······被告辩称]]>:原告在诉状中所述情形是虚假的······ | 原告提出诉求]]>:被告xxx归还原告借款本金xx万元及利息,xxx承担连带清偿责任。被告辩称]]>······ | 原被告诉请 |

| 事实与理由]]>:被告xxx由xxx担保于20xx年xx月xx日向xxx银行营业部借款······ | 经依法查明]]>贷款合同和保证合同均是双方真实意思表示,合法有效,被告未按约定履行自己的义务已构成违约,应承担违约责任,保证人承担连带清偿责任······ | 案件事实 |

| 综上所述,依照]]>《中华人民共和国合同法》第一百零七条、第二百零五条《中华人民共和国民事诉讼法》第一百四十四条之规定,判决如下]]>:一、被告xxx于本判决生效之日起十五日内返还原告xxx股份有限公司借款······ | 依照]]>《中华人民共和国合同法》第一百零七条、第二百零五条、《中华人民共和国担保法》第十八条、第二十一条、第三十一条、《中华人民共和国民事诉讼法》第一百四十四条规定,判决]]>······ | 判决结果 |

本文提出结合提示学习与大语言模型的裁判文书摘要生成方法,通过提示学习的方法将结构信息引入裁判文书摘要任务中。首先针对模型缺乏司法领域专业知识的问题,采用数据驱动方式,使用大量裁判文书及其关键信息以问答对形式驱使大语言模型对齐裁判文书摘要任务,从而增强大语言模型对司法领域特定术语、概念及法律逻辑的理解。同时,针对难以理解裁判文书结构及逻辑问题,本文受提示学习启发,在SFT技术的基础上设计包含结构信息与角色指令的提示模板,来增强大语言模型对裁判文书结构及逻辑关系的感知,引导模型更准确捕捉文中关键信息,从而更好生成反映裁判文书内在逻辑和结构信息的裁判文书摘要。

1 相关工作1958年,Luhn[8]首次提出了基于词频来评估文本中句子重要性的词语显著性(word significance) 算法,通过抽取被认为重要的句子来构建摘要。2004年,Mihalcea等[9]引入了文本排名(textrank)算法,该算法借鉴了基于分数的页面排名(pagerank)[10]算法,通过对句子进行排序,并选取排名较高的句子来形成摘要。2019年,Xiao等[11]针对长文档摘要的挑战,提出了一种综合考虑文档全局上下文和当前主题上下文的模型,以判断哪些句子应被选入摘要。这些方法均采用了抽取式摘要的策略,虽然此策略规避了复杂的自然语言生成挑战,但生成的摘要常常面临表述不清晰和信息冗余的问题。相比抽取式摘要,生成式摘要的发展历程较短。2015年,Rush等[12]首次将序列到序列(seq2seq)模型应用于生成式文本摘要任务,相比传统方法展现出显著的性能提升。2016年,Kim等[13]提出了一种分段方法,将源文档划分为多个段落,并从每个段落中选取关键句作为该段的目标摘要,通过构建(段落,关键句)对的数据集,使用序列到序列模型进行训练。2017年,See等[14]进一步提出了指针生成网络模型,该模型在注意力机制基础的序列到序列模型上,增加了复制(copy)和覆盖(coverage)机制,有效地缓解了OOV(out-of-vocabulary)问题,为生成式摘要技术的发展贡献了重要的理论与实践基础。这些模型通常由于输入和输出的长度限制而受到限制。当处理较长文本时,模型可能无法充分捕获文本的语义信息,从而导致生成的摘要不够准确或完整。此外,这些模型主要聚焦于对文本信息的分析,而忽略了文本内部的逻辑结构关系。

文本摘要技术应用于司法领域经历了多次尝试和实践。2004年,Farzindar等[15]开发了Letsum系统,将法律文档细分为引言、主体内容、判决分析和结论4部分,并对各部分内的句子进行了分类和评估,以筛选出最具有代表性的句子构成摘要。2006年,Hachey等[16]对英国上议院的XML语料库进行研究,通过预测句子的修辞状态来挑选重要句子,从而实现有效的摘要生成。2016年,Polsley等[17]提出了一种基于案例的摘要生成方法,依托词频分析及额外的领域特定知识,通过预处理、句子相关性评估和领域特定处理3个阶段来生成摘要。这些研究不仅体现了文本摘要技术在司法领域的应用潜力,也展示了通过结合领域知识和技术创新来提高摘要质量和效率的可能性。

随着近期研究突显出大语言模型在文本摘要任务中所具有的巨大潜力,探索这些模型在不同领域中对于多样化摘要任务的适应性和表现成为了一个关键课题。在此背景下,众多学者对利用大型语言模型进行文本摘要的方法进行了深入研究。Brown等[18]以大语言模型为基础,探究了其在文本摘要中的应用;Goyal等[19]发现,尽管使用大语言模型生成的摘要在ROUGE分数上略显不足,但却更受人类评估者的青睐;Zhang等[20]指出,大语言模型在新闻领域生成的摘要与人类编写的相差无几;Yang等[21]探讨了将ChatGPT在处理基于查询以外的一般性摘要任务中的性能极限。然而,由于司法领域的独特性,大语言模型通用性的能力在用于裁判文书摘要任务等司法领域垂直任务时仍然存在缺乏司法领域专业知识和难以理解裁判文书结构与逻辑的问题。

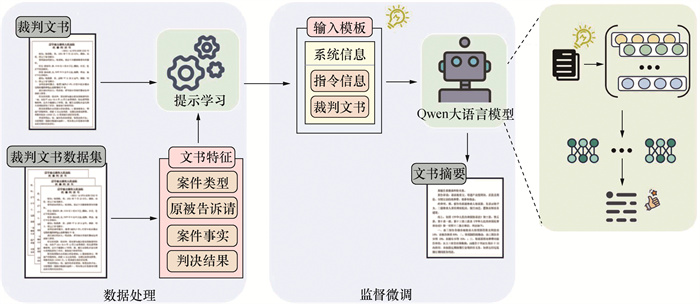

2 方法设计在本节中将详细介绍本文提出的结合提示学习和大语言模型的裁判文书摘要方法。在使用裁判文书数据使大语言模型对齐裁判文书摘要任务的同时,使用包含结构信息等指令的提示模板一同微调大语言模型,进而生成更加准确、简洁且严谨的裁判文书摘要。方法流程如图 1所示。

|

| 图 1 方法流程示意图 |

2.1 问题定义

本文使用的数据集以(文本,摘要)对的形式呈现,具体可表示为:

在司法裁判文书摘要领域,多数学者采用先抽取后生成方法,但在抽取阶段和生成时上下文的限制会导致关键信息的缺失;或者按照裁判文书的逻辑结构分段进行摘要,但往往因无法有效整合各段之间的语义逻辑信息,导致生成内容不连贯以及忽略各段之间语义逻辑信息。大语言模型以其超强的上下文处理能力,为裁判文书摘要提供了新的解决方案。

裁判文书摘要任务对齐旨在通过利用裁判文书数据,对大语言模型进行微调,以实现对裁判文书摘要任务的精准对齐。具体来说,基于大语言模型预训练阶段数据特点,将裁判文书和关键信息以问答对形式构建数据集,这种问答对的形式不仅便于模型理解并学习裁判文书的内在逻辑与结构,同时也有助于提升模型在生成摘要时的准确性和连贯性。

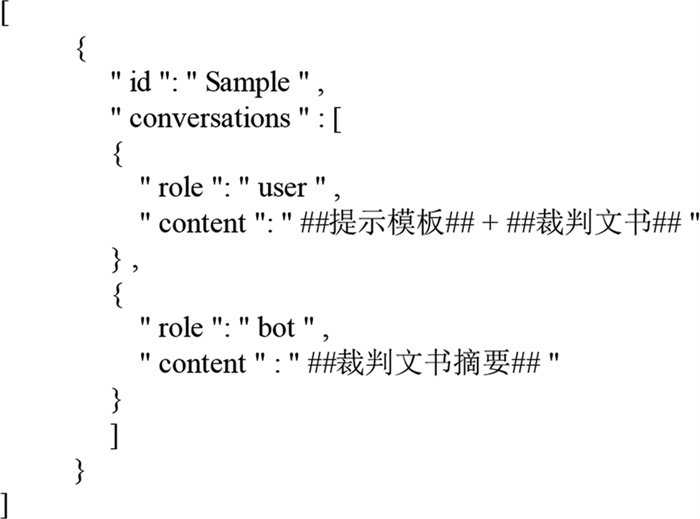

本文遵循上述数据集构建原则,在微调阶段,将裁判文书原文镶嵌在包含提示信息的提示模板中作为用户输入,而将裁判文书原文的标准摘要作为大语言模型的输出;推理阶段,沿用相同形式,即将裁判文书原文嵌入至相同的提示模板中,作为模型处理的用户输入。通过这样的数据集构建方式和模型微调方法,可以将大语言模型在对话方面所展现出的通用性能力限制集中在裁判文书摘要这一专有任务上,提高语言模型的处理能力,并为模型提供了丰富而高质量的训练数据,以使其更好地适应裁判文书摘要任务的特点和需求。具体的数据集示例格式如图 2所示。

|

| 图 2 数据格式示意图 |

2.3 提示学习模块 2.3.1 裁判文书结构信息

裁判文书及其摘要的编纂严格按照最高人民法院的相关规定进行,涵盖了丰富的结构信息,并在其不同组成部分之间展现了明确的逻辑因果联系。在现有研究中,Dan等[22]通过识别裁判文书内的结构信息,将文书划分为3个主要部分,并采用不同的方法生成最终的摘要。与Dan的方法不同,本文提出一篇裁判文书可以细分为案件类型、原被告的诉请、案件事实、判决结果4个关键部分,每个部分都呈现出明显的逻辑性和层次结构,如表 2所示。由加粗部分可以看到,“合同”一词作为这篇裁判文书的主旨贯穿整篇;而下划线部分表示各部分的内容之间存在具体的逻辑关系,详细说明如表中最右列所示。

| 文书结构 | 内容 | 关系 |

| 案件类型 | 本案系合同纠纷 | 案件类型与原被告诉请、案件事实以及法律依据相关 |

| 原被告诉请 | 原告xx诉请:被告xx按照合同约定支付货款x万元,并赔偿违约金x万元。被告辩称货物存在质量问题······ | 判决结果为原被告诉请的回应,且诉请是在事实基础之上提出 |

| 案件事实 | 本院认为,双方签订购销合同,被告xx未按约定时间支付货款,原告xx要求支付货款并赔偿损失······ | 案件事实与相关法律为判决理由提供了审判基础,决定最终判决结果 |

| 相关法律 | 根据《合同法》第107条,当事人应按照约定履行义务,不履行或不完全履行义务的,应承担违约责任 | |

| 判决结果 | 判决 被告xx支付原告xx货款10万元,并赔偿违约金2万元 |

通过对数据集的深入分析,本文不仅识别出了文书的逻辑性和层次性,同时也揭示了它们之间存在着复杂而清晰的因果逻辑关系。例如,案件的事实描述为审理过程提供了基础,而这一审理过程又直接决定了判决的结果。该结构化信息及其内在的逻辑关系对于自动生成裁判文书摘要的过程具有至关重要的意义。它们能够辅助大语言模型高效地识别文书的核心内容,减缓大语言模型推理时的幻觉与错误,从而促使生成既准确又符合逻辑的摘要内容。

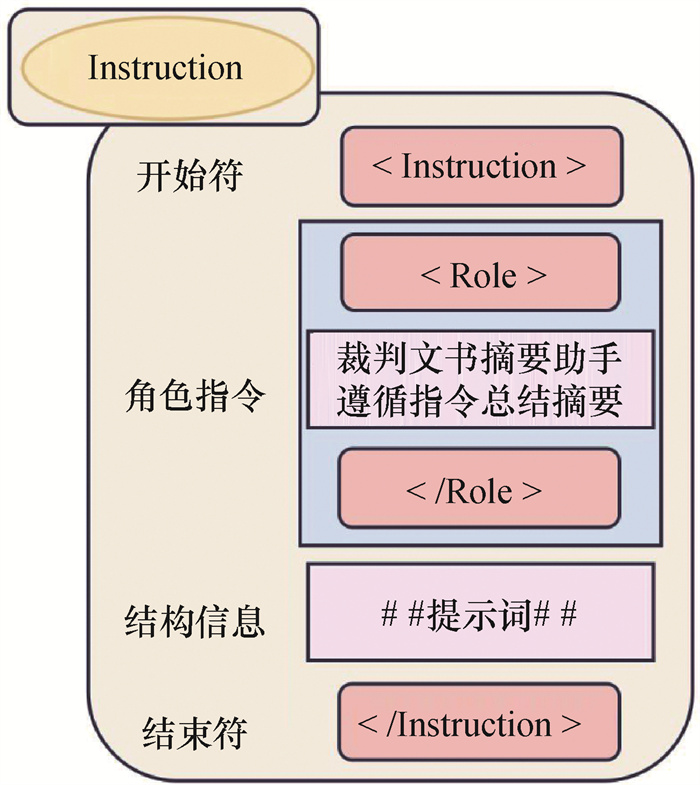

2.3.2 提示模板如文[23]所述,精心设计的提示词与构建恰当的提示模板能显著提升大语言模型解决问题的能力,本文亦观察到同样的实验结果。图 3中,基于裁判文书的独特属性,在构建裁判文书摘要任务的提示模板时,本文综合考虑了4个关键方面,具体包括:1) 角色定义,为大语言模型指派一个具体角色,仿照现实世界中的专业人士或技术职能;2) 明确主要任务,向大语言模型提供一项明确的指令(Instruction),引导模型完成特定任务;3) 声明结构信息,通过这一“思维框架”,大语言模型能更易于理解指令的意图和焦点,从而减轻其理解任务及推理输出时的负担;4) 指定约束,确保大语言模型在尽可能贴近裁判文书任务目标的同时输出精确且无害的裁判文书摘要。

|

| 图 3 指令示意图 |

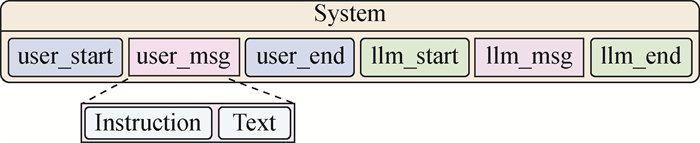

表 3详细定义了提示模板的具体构成。在模板的System部分,明确声明了角色信息与任务约束;同时,该模板还规定了大语言模型的类型以及其相对应输入输出的界定符。

| 参数名 | 参数值 |

| System | “你是{Name},遵循指令为用户提供无害的摘要任务······” |

| user_start | < |im_start|>user\n |

| user_end | < |im_end|>\n |

| llm_start | < |im_start|>assistant\n |

| llm_end | < |im_end|>\n |

经过提示模板封装处理后,整体Prompt的构成如图 4所示。其中,user_msg包括 < Instruction>与<Text>2部分,分别代表包含文书结构信息的指令及裁判文书文本;llm_msg是大语言模型的回复。在<Instruction>中,向大语言模型明确指出裁判文书所具备的结构信息,要求模型基于4部分的结构信息进行摘要任务。此过程中,模型需捕捉各部分内在的逻辑关系,从而生成既保留语义完整性又符合文书逻辑结构的摘要。

|

| 图 4 Prompt示意图 |

3 实验及分析 3.1 数据集

本文所使用的数据集为中国法律智能技术评测(challenge of AI in law,CAIL)2020年司法摘要赛道比赛数据集(http://cail.cipsc.org.cn/Attend.html),该数据集由赛事主办方提供,数据来源于“中国裁判文书网”的真实开源裁判文书。该数据集涵盖了继承纠纷、侵权责任纠纷、借款合同纠纷、劳动合同纠纷、租赁合同纠纷等多种类型的民事案件,包含9 484条数据,每条数据以(ID,专家摘要,裁判文书)的形式存在。裁判文书的正文包含了原被告信息、涉案缘由、事实经过、法院意见、涉及法条、判决结果及法律解释等描述。与其他中文领域如新闻和艺术不同,裁判文书中包含大量法律术语。这些领域特定的词汇对文书摘要的生成有着显著影响。为了解决这一问题,并减少因司法领域特征导致的精度损失,本文根据Bai等[24]在Qwen技术报告中所述,增加了200条通用领域对话数据、200条类案检索数据和200条司法问答数据。这些数据的加入有助于大语言模型更好地理解司法领域的语言风格,增强其对裁判文书摘要任务的感知,同时保持优良的对话功能。

为实现有效的模型训练和评估,本文将数据集按照80%、10%和10%的数据量比例分别划分为训练集、验证集和测试集。数据集中文本长度最长为13 060字,最小为866字,其中90%以上的裁判文书数据超过4 000字;标准摘要平均为283字,最长为474字,由此可见,裁判文书摘要属于长文本摘要任务。

3.2 评价方法摘要生成的质量评估采用了文本摘要任务中最为广泛使用的ROUGE[25]方法。本文选择ROUGE评价体系中的ROUGE-1、ROUGE-2和ROUGE-L的F1值来对Yi和生成摘要Zi进行评估,并基于词的方法来计算。

ROUGE-1关注Zi中的单词和Yi中的单词之间的重合度,计算的是单词级别的重叠率。召回率R1、精确率P1和两者的调和平均F1值F1的计算方式如下:

| $ R_1=\frac{\sum\limits_{s \in S} \operatorname{count}_{\text {match }}(s)}{\sum\limits_{s \in S} \operatorname{count}(s)}, $ | (1) |

| $ P_1=\frac{\sum\limits_{s \in S} \operatorname{count}_{\text {match }}(s)}{\sum\limits_{s^{\prime} \in S^{\prime}} \operatorname{count}\left(s^{\prime}\right)}, $ | (2) |

| $ F_1=\frac{2 R_1 P_1}{R_1+P_1} \times 100 \% $ | (3) |

其中:S是Yi中的单词集,S′是Zi中的单词集,countmatch(s)是指单词s在Yi和Zi中都出现的次数,而count(s)和count(s′)分别是单词在Yi和Zi中的出现次数。

ROUGE-2计算2个连续单词(即二元组)的重叠度,计算方式与ROUGE-1类似,但关注的是二元组的匹配情况。召回率R2、精确率P2和两者的调和平均F1值F2的计算方式如下:

| $ R_2=\frac{\sum\limits_{k \in K} \operatorname{count}_{\text {match }}(k)}{\sum\limits_{k \in K} \operatorname{count}(k)}, $ | (4) |

| $ P_2=\frac{\sum\limits_{k \in K} \operatorname{count}_{\mathrm{match}}(k)}{\sum\limits_{k^{\prime} \in K^{\prime}} \operatorname{count}\left(k^{\prime}\right)}, $ | (5) |

| $ F_2=\frac{2 R_2 P_2}{R_2+P_2} \times 100 \%. $ | (6) |

其中K和K′分别表示Yi和Zi中的二元组集合。

ROUGE-L使用最长公共子序列(longest common subsequence, LCS)来评价2个句子的相似度。LCS是一种序列相似度的度量,它衡量在不考虑顺序的情况下2个序列共有元素的最大长度。ROUGE-L特别适用于评估自然语言生成的结果如摘要和翻译,因为它在一定程度上考虑了句子结构的连贯性。召回率RL、精确率PL和两者的调和平均F1值FL的计算方式如下:

| $ R_{\mathrm{L}}=\frac{\operatorname{LCS}\left(Y_i, Z_i\right)}{\operatorname{len}\left(Y_i\right)}, $ | (7) |

| $ P_{\mathrm{L}}=\frac{\operatorname{LCS}\left(Y_i, Z_i\right)}{\operatorname{len}\left(Z_i\right)}, $ | (8) |

| $ F_{\mathrm{L}}=\frac{2 R_{\mathrm{L}} P_{\mathrm{L}}}{R_{\mathrm{L}}+P_{\mathrm{L}}} \times 100 \% . $ | (9) |

其中:LCS(Yi, Zi)表示Yi和Zi之间的最长公共子序列的长度,和len(Yi)和len(Zi)分别是Yi和Zi的长度。

此外,为了进一步验证大型语言模型在裁判文书摘要领域的整体性能,本文还采用了人工评测方法,从完整性、流畅性、一致性和逻辑性4个维度对模型生成的摘要质量进行综合评估。

3.3 实验设置 3.3.1 模型选择Qwen-7B-Chat[26]是阿里云研发的通义千问大模型系列的70亿参数规模的模型,是基于Transformer的大语言模型, 在超大规模的预训练数据上进行训练得到,赋予了它强大的表达能力和学习能力。在Qwen-7B的基础上,使用对齐机制打造了Qwen-7B-Chat。此外,Qwen-7B-Chat在预训练阶段采用了多样化的数据类型,这些数据类型不仅丰富了模型的训练素材,还增强了其应对各种自然语言现象的能力。因此,在对话系统中,Qwen-7B-Chat能够展现出自然、流畅的语言交互,提供高质量的对话体验。

本文针对裁判文书摘要这一特定任务选取了Qwen-7B-Chat作为基础生成模型,原因是Qwen-7B-Chat在处理中文语料方面的独特优化,以及其在自然语言生成任务中所展现的稳定性与高效性。此外,作为一个开源模型,Qwen-7B-Chat提供了较高的可访问性和灵活性,为本研究提供了一个实验和探索的平台。

3.3.2 参数设置本文通过采用融合结构信息的提示模板来辅助大型语言模型生成裁判文书摘要。实验在NVIDIA RTX A6000显卡上利用Pytorch框架进行,采用了Lora训练方法,设置最大文本长度为4 096,学习率定为1×10-4,训练轮次(Epochs)为3,推理时温度系数为0.2,Deepspeed优化等级为3。

3.4 对比模型为了证明本文方法改进的Qwen的有效性,选取LEAD-3模型作为本文的基线模型,并选取了若干具有代表性的对比模型进行分析比较:

1) LEAD-3 [27]: 摘录文件的前3句话作为摘要。但由于裁判文书与新闻稿有差异,其关键信息一般不在开头,所以本文根据裁判文书数据特征做出了小幅调整。

2) TextRank [28]: 将句子作为节点,并使用句子之间的相似度来构造无向加权边。边上的权重用于迭代更新节点值。最终,选取得分最高的N个节点作为摘要。

3) BERTSUM+Classifier [29]: 用BERT作为编码器来获取句子向量。此外,在BERT输出顶部增加了一个简单的分类层,以捕获文档级特征用于提取摘要。

4) UniLM [30]: 基于Transformers,并通过3种具有不同目标函数的无监督语言模型进行预训练,这使其适用于自然语言理解和生成任务。

5) PGN [31]: 基于编码器-解码器(encoder-decoder)架构的生成式摘要模型,在序列到序列(seq2seq)+ 注意力(attention)基线模型的基础上增加了复制机制和覆盖机制。

6) PGN +Law [32]: 对于裁判文书原文部分, 利用经典的指针生成网络构建一个编码器-解码器框架的抽取式摘要生成模型; 然后基于注意力机制构建一个关于法条的外部知识编码器; 最后将2个模型进行融合输出, 通过外部知识来辅助生成最终的司法摘要。

7) BERT [33] + PGN: 2段式模型。将原始文档首先被输入到BERT中进行抽取式摘要,然后,将抽取出的关键句子输入到生成式摘要模型PGN中,以生成最终的摘要。

8) BSLT+LPGN [34]: 使用Lawformer作为编码器,构造抽取模型被命名为BSLT,而生成模型被命名为LPGN。并根据法律文档的特定结构,将文档分段后分别应用提取式和生成式摘要模型,从而提高了整体摘要的质量。

3.5 实验结果及分析 3.5.1 对比实验结果分析表 4为本文方法改进的Qwen和对比模型在CAIL2020测试数据集上的ROUGE指标中的F1值。可以看到,Qwen-7B-Chat性能最差,但本文方法改进的Qwen在ROUGE的F1值上均超越了所有的对比模型。特别地,与BSLT+LPGN模型相比,本文方法改进的Qwen在ROUGE-1、ROUGE-2和ROUGE-L的F1值上分别取得了7.58%、14.87%和12.11%的提升,这充分验证了本文方法改进的Qwen在裁判文书摘要领域的有效性。结果表明,该模型生成的摘要包含了更丰富的结构信息和更完整的语义信息。

| % | |||||||||||||||||||||||||||||

| 模型 | F1 | F2 | FL | ||||||||||||||||||||||||||

| LEAD-3 | 46.30 | 22.84 | 35.31 | ||||||||||||||||||||||||||

| TextRank | 54.40 | 28.55 | 40.06 | ||||||||||||||||||||||||||

| BERTSUM+Classifier | 52.36 | 29.11 | 45.95 | ||||||||||||||||||||||||||

| UniLM | 49.70 | 24.91 | 43.79 | ||||||||||||||||||||||||||

| PGN | 54.74 | 29.87 | 47.39 | ||||||||||||||||||||||||||

| PGN+Law | 58.43 | 36.17 | 56.04 | ||||||||||||||||||||||||||

| BSLT+LPGN | 60.16 | 36.47 | 52.17 | ||||||||||||||||||||||||||

| Qwen-7B-Chat | 3.63 | 0.38 | 0.30 | ||||||||||||||||||||||||||

| 本文方法改进的Qwen | 67.74 | 51.34 | 64.28 | ||||||||||||||||||||||||||

在与BERTSUM和UniLM等输入长度受限的模型相比时,本文方法改进的Qwen能够完整处理文本,避免了由于文本过长而导致的编码截断问题,从而减少了信息遗漏的风险。并且,在BSLT+LPGN中,原始文档被分为3部分,通过先抽取后生成的方式分别得到各部分摘要,再将这些摘要按原始顺序拼接形成最终摘要。这种方法可能在抽取阶段丢失关键信息,影响生成阶段的质量,并且分段后的直接合并可能会降低生成内容的可读性。同样,PGN+Law采用的抽取加生成方法也存在类似问题,且未能充分考虑法条间的关联关系。与上述模型相比,本文方法改进的Qwen在质量和可读性方面表现更优,提供了更精确的结构信息和因果逻辑信息。

3.5.2 消融实验为了验证本文提出方法的有效性,本文除了与其他模型进行整体性能比较外,还在CAIL2020提供的司法摘要数据集上进行了消融实验。

表 5中,Qwen-7B-Chat +Template是指Qwen-7B-Chat仅使用提示模板增强模型对裁判文书结构信息的感知;Qwen-7B-Chat +SFT是指Qwen-7B-Chat仅通过SFT技术进行微调。可以看出,使用Qwen-7B-Chat进行裁判文书摘要任务时,其性能显著低于其他3种方法。这表明在缺乏专门的司法领域知识情况下,Qwen-7B-Chat无法有效地完成任务;Qwen-7B-Chat +Template比Qwen-7B-Chat性能有所提升,说明包含结构信息的提示模板能显著增强Qwen对裁判文书结构和逻辑的理解;Qwen-7B-Chat +SFT方法虽然高于上面2种方法,但仍低于本文方法改进的Qwen,进一步说明了本文提出的方法能有效提升Qwen在裁判文书摘要任务上的性能,同时也表明包含结构信息的提示模板能增强Qwen捕获裁判文书中结构与逻辑等关键信息的能力。

| % | |||||||||||||||||||||||||||||

| 模型 | F1 | F2 | FL | ||||||||||||||||||||||||||

| Qwen-7B- Chat | 3.63 | 0.38 | 0.30 | ||||||||||||||||||||||||||

| Qwen-7B-Chat +Template | 7.94 | 2.13 | 6.30 | ||||||||||||||||||||||||||

| Qwen-7B-Chat+ SFT | 67.11 | 50.73 | 63.69 | ||||||||||||||||||||||||||

| 本文方法改进的Qwen | 67.74 | 51.34 | 64.28 | ||||||||||||||||||||||||||

3.5.3 泛化性研究

为了验证本文提出的方法在裁判文书摘要任务上改进大模型的泛化性,本文也在零一万物开源的Yi-6B-Chat[35]模型上进行了实验。

表 6中,Yi-6B-Chat+Template是指Yi-6B-Chat仅使用提示模板增强大语言模型对裁判文书结构信息的感知;Yi-6B-Chat+SFT是指Yi-6B-Chat仅通过SFT技术进行微调;Yi-6B-Chat +SFT+Template是指Yi-6B-Chat通过SFT技术进行微调,并使用提示模板增强大语言模型对裁判文书结构信息的感知。可以看出,Yi-6B-Chat +SFT+Template的性能明显高于其他3种方法,证明本文提出的方法具有很好的泛化性,能对不同的大语言模型在裁判文书摘要任务上的性能产生积极的效果。

| % | |||||||||||||||||||||||||||||

| 模型 | F1 | F2 | FL | ||||||||||||||||||||||||||

| Yi-6B-Chat | 17.47 | 4.33 | 12.34 | ||||||||||||||||||||||||||

| Yi-6B-Chat+ Template | 27.11 | 9.38 | 20.27 | ||||||||||||||||||||||||||

| Yi-6B-Chat+ SFT | 55.86 | 36.23 | 51.04 | ||||||||||||||||||||||||||

| Yi-6B-Chat+SFT+Template | 60.32 | 40.94 | 56.00 | ||||||||||||||||||||||||||

3.5.4 参数分析

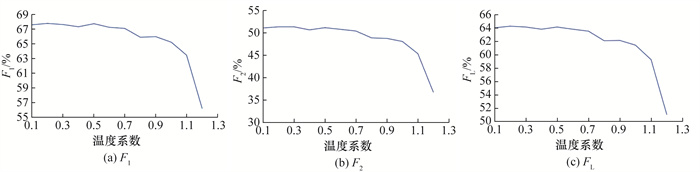

本文在CAIL2020提供的司法摘要数据集上进行了参数分析实验,来分析温度系数对大语言模型生成摘要性能的影响。

图 5中,随着温度系数的增大,本文方法改进的Qwen性能在温度系数为0.1~0.7时小幅振荡,在温度系数为0.2时达到顶峰。随着温度系数的进一步增加,模型的性能大幅度降低。这表明温度系数的选择严重影响了大语言模型生成裁判文书摘要的性能。较低的温度系数会使模型更加专注和确定,更倾向于选择概率较高的标记;而随着温度系数的增加,模型则更加倾向于选择具有创造性的答案。然而,裁判文书及其摘要需要严格遵循司法领域的语言风格特点,并且裁判文书摘要必须与原文的逻辑结构关系相符。因此,这也解释了在低温度系数状态下自动生成的摘要评估性能会更高的原因。

|

| 图 5 本文方法改进的Qwen的ROUGE指标F1值与温度系数的关系 |

3.5.5 提示词探究实验

本文基于3.3.2节的实验设置,以Qwen-7B-Chat作为基座模型,根据5条不同的提示词(见表 7)分别构建了5个提示模板。其中,提示词1和2来自大语言模型在进行通用领域摘要时常用的提示内容;提示词3的设计基于文[36]提出的裁判文书划分结构;提示词4则是通过Chat-GPT4[37]分析100篇裁判文书及其标准摘要后得出;提示词5为本文提出的提示词。具体的提示词内容及自动摘要评价结果如表 7所示。可以看出,提示词5在各项指标中均表现最佳。与提示词1、2相比,提示词5包含了更多司法领域具体性与指向性,并有清晰的角色设定,增加了任务的明确性和聚焦度;与提示词3相比,提示词5更加细化了裁判文书结构,增强了Qwen对裁判文书结构信息的感知能力;与提示词4相比,提示词5能够精准描述具体要求和裁判文书结构信息,从而避免了提示词过长导致Qwen在处理长文本时丢失提示词引导的问题。

| % | |||||||||||||||||||||||||||||

| 提示词编号 | 提示词内容 | F1 | F2 | FL | |||||||||||||||||||||||||

| 1 | 请为下面的文章做总结。##裁判文书## | 57.81 | 40.74 | 54.13 | |||||||||||||||||||||||||

| 2 | 请总结下面的文章。##裁判文书## | 57.29 | 40.44 | 52.77 | |||||||||||||||||||||||||

| 3 | 你现在是一个裁判文书摘要助手,我有一篇裁判文书,详细描述了案件信息、案情描述和法院意见,请根据这个结构信息总结我给你的裁判文书,文书为:##裁判文书## | 67.36 | 50.80 | 63.82 | |||||||||||||||||||||||||

| 4 | 你现在是一个裁判文书摘要助手,根据下述的裁判文书文本,提取案件的基本背景、原告的诉讼请求、被告的辩称和法院的判决依据。在摘要案件事实时,突出关键事实,保持事实完整性,清晰表达时间线,使用准确的描述,并简化复杂信息。然后简化和概括这些信息,使用正确的法律术语组织成一个结构清晰、简洁明了的摘要。##裁判文书## | 67.47 | 50.94 | 63.98 | |||||||||||||||||||||||||

| 5 | 你现在是一个裁判文书摘要助手,我有一篇裁判文书,详细描述了案件类型、原告与被告的诉讼请求、案件事实的经过,以及法庭最终做出的判决结果,请根据这个结构信息总结我给你的裁判文书,文书为:##裁判文书## | 67.74 | 51.34 | 64.28 | |||||||||||||||||||||||||

3.5.6 人工评测

本文通过人工评测来进一步评估摘要的质量,为了提高人工评测的准确性,本文采用了与Dong等[38]类似的方法设置了人工评测实验,主要从摘要的完整性、流畅性、一致性和逻辑性4个维度进行衡量。完整性是指摘要是否全面反映了案件的关键信息;流畅性指摘要的语言表达是否清晰、通顺,且语法正确连贯;一致性指裁判文书在事实认定、法律适用和判决结果等方面的表述是否一致,无自相矛盾之处;逻辑性则是指摘要的结构安排和内容表达是否符合裁判文书的逻辑方法,正确地基于案件事实和法律条文解释来应用法律,进而形成合理的裁决结果。

为了量化这些评估标准,本文执行了人工评估实验。从测试集中随机抽取了100个样本,每个样本由3名评估人员进行评审。评审人员对本模型生成的摘要以及PGN、BART模型生成的摘要在完整性、流畅性、一致性和逻辑性4方面进行打分,其中3分代表优秀,2分代表中等,1分代表较差,单项评估的满分为900分,表 8中为3名评审人员评估完成后的总分。可以看出,本文方法改进的Qwen在各个评估维度上均优于PGN和BART模型。

| 模型 | 完整性 | 流畅性 | 一致性 | 逻辑性 |

| PGN | 653 | 833 | 431 | 427 |

| BART | 694 | 851 | 462 | 475 |

| 本文方法改进的Qwen | 791 | 883 | 826 | 630 |

3.5.7 提示学习必要性研究

表 9分别展示了标准摘要(专家标注)、Qwen-7B-Chat+SFT生成的摘要和本文方法改进的Qwen生成的摘要。由表中下划线部分可以明确发现,在引入提示学习后,本文方法改进的Qwen生成的裁判文书摘要在语言风格上更趋近于标准裁判文书摘要的规范,显著提高了准确性与专业性。同时,如表中加粗部分所示,未引入提示学习的Qwen-7B-Chat+SFT在处理裁判文书时,明显遗漏了若干关键信息,这直接导致了其生成的裁判文书摘要在内容上造成了信息丢失的问题。引入提示学习使大语言模型在感知和呈现裁判文书关键信息方面表现更为出色。具体原因归纳如下:

| 标准摘要 | Qwen-7B-Chat+SFT | 本文方法改进的Qwen |

| 原被告系劳动合同纠纷。原告诉求被告支付工资、解除劳动合同的经济补偿。被告未作答辩。原告提供的离职交接手续表中未注明辞职理由,且为复印件,原告又未能提供其他证据以证明其于辞职之时已经向被告明示其解除的理由。因此,本院难以确认原告系因被告未按时足额支付工资或缴纳社保为由提出解除劳动合同,故原告要求被告支付其解除劳动合同的经济补偿之请求缺乏依据,难以支持。现又因被告未提供证据证明其已经足额支付原告工资,故支持工资之请求中的合理部分。依照《中华人民共和国劳动合同法》第二条第一款之规定,判决被告支付工资;驳回原告余诉讼请求 | 原被告系劳动合同关系。原告提出诉求:1. 被告支付原告工资;2. 被告支付原告解除劳动合同的经济补偿。被告未作答辩。经查明原告提供的离职交接手续表中未注明辞职理由,且为复印件,原告又未能提供其他证据以证明其于辞职之时已经向被告明示其解除的理由,难以确认原告系因被告未按时足额支付工资或缴纳社保为由提出解除劳动合同。依照《中华人民共和国劳动合同法》第二条第一款之规定,判决如下:1. 被告于本判决生效之日起十日内支付原告工资;2. 驳回原告其余诉讼请求。如果未按期间履行给付金钱义务,应当加倍支付迟延履行期间的债务利息 | 原被告系劳动合同纠纷。原告诉求被告支付工资、解除劳动合同的经济补偿。被告未作答辩。本案中,原告提供的离职交接手续表中未注明辞职理由,且为复印件,原告又未能提供其他证据以证明其于辞职之时已经向被告明示其解除的理由。因此难以确认原告系因被告未按时足额支付工资或缴纳社保为由提出解除劳动合同,故原告要求被告支付其解除劳动合同的经济补偿之请求缺乏依据;现又因被告未提供证据证明其已经足额支付原告工资,故原告要求被告支付其工资之请求中的合理部分予以支持。依照《中华人民共和国劳动合同法》第二条第一款,判决被告支付原告工资;驳回原告其余诉讼请求 |

1) 裁判文书通常包含案件类型、原被告诉请、案件事实和判决结果等多个部分。模板中的结构信息能够指导模型专注于这些特定部分,精准识别和提取关键信息,从而提高摘要生成的速度和准确度。

2) 遵循裁判文书的结构生成摘要能够使摘要更加符合法律文档的标准格式。这种结构性也有助于确保文本之间的逻辑性和连贯性,使得摘要更加条理清晰。

3) 结构化的提示模板确保摘要不仅聚焦于某一特定部分,而是全面覆盖裁判文书的所有关键要素。这种全面性对于生成准确、全面且逻辑一致的摘要至关重要。

4 结论本文提出了结合提示学习和Qwen大语言模型的裁判文书摘要方法。通过将裁判文书及其摘要构建成问答对的形式,作为SFT技术对大语言模型微调的输入,使大语言模型具备司法领域专业知识;同时,利用包含结构信息的提示模板增强大语言模型对裁判文书结构和逻辑的感知能力,辅助模型生成裁判文书的摘要,使得模型能够聚焦于裁判文书的关键信息,并有效捕捉到更深层次的语义和逻辑关系。同时,本文设计了对比实验以验证所提方法的有效性。结果显示,本文方法改进的Qwen在生成裁判文书摘要的质量上取得了显著的提升。

| [1] |

最高人民法院. 最高人民法院关于人民法院在互联网公布裁判文书的规定(2016修订)[EB/OL]. (2016-10-01)[2024-07-30]. https://pkulaw.com/en_law/e9ea61f2aaa98dfabdfb.html. Supreme People's Court. Provisions of the supreme people's court on the publication of judgments on the internet by the people's courts (2016 revision)[EB/OL]. (2016-10-01)[2024-07-30]. https://pkulaw.com/en_law/e9ea61f2aaa98dfabdfb.html. (in Chinese) |

| [2] |

SUN Z X, YU W J, SI Z H, et al. Explainable legal case matching via graph optimal transport[J]. IEEE Transactions on Knowledge and Data Engineering, 2024, 36(6): 2461-2475. DOI:10.1109/TKDE.2023.3321935 |

| [3] |

余帅, 宋玉梅, 秦永彬, 等. 基于审判逻辑步骤的裁判文书摘要生成方法[J]. 计算机工程与应用, 2024, 60(4): 113-121. YU S, SONG Y M, QIN Y B, et al. Method for generating summary of judgment documents based on trial logic steps[J]. Computer Engineering and Applications, 2024, 60(4): 113-121. (in Chinese) |

| [4] |

李锦烨, 黄瑞章, 秦永彬, 等. 基于反绎学习的裁判文书量刑情节识别[J]. 计算机应用, 2022, 42(6): 1802-1807. LI J Y, HUANG R Z, QIN Y B, et al. Recognition of sentencing circumstances in adjudication documents based on abductive learning[J]. Journal of Computer Applications, 2022, 42(6): 1802-1807. (in Chinese) |

| [5] |

WIDYASSARI A P, RUSTAD S, SHIDIK G F, et al. Review of automatic text summarization techniques & methods[J]. Journal of King Saud University-Computer and Information Sciences, 2022, 34(4): 1029-1046. DOI:10.1016/j.jksuci.2020.05.006 |

| [6] |

BROWN T B, MANN B, RYDER N, et al. Language models are few-shot learners[C]//Proceedings of the 34th International Conference on Neural Information Processing Systems. Vancouver, Canada: Curran Associates Inc., 2020: 1877-1901.

|

| [7] |

LEWIS P, PEREZ E, PIKTUS A, et al. Retrieval-augmented generation for knowledge-intensive NLP tasks[C]//Proceedings of the 34th International Conference on Neural Information Processing Systems. Vancouver, Canada: Curran Associates Inc., 2020: 9459-9474.

|

| [8] |

LUHN H P. The automatic creation of literature abstracts[J]. IBM Journal of Research and Development, 1958, 2(2): 159-165. DOI:10.1147/rd.22.0159 |

| [9] |

MIHALCEA R, TARAU P. Textrank: Bringing order into text[C]//Proceedings of 2004 Conference on Empirical Methods in Natural Language Processing. Barcelona, Spain: ACL, 2004: 404-411.

|

| [10] |

PAGE L, BRIN S, MOTWANI R, et al. The pagerank citation ranking: Bringing order to the web[R]. Palo Alto: Stanford InfoLab, 1999.

|

| [11] |

XIAO W, CARENINI G. Extractive summarization of long documents by combining global and local context[C]//Proceedings of 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP- IJCNLP). Hong Kong, China: ACL, 2019: 3011-3021.

|

| [12] |

KIM Y, RUSH A M. Sequence-level knowledge distillation[C]//Proceedings of 2016 Conference on Empirical Methods in Natural Language Processing. Austin, USA: ACL, 2016: 1317-1327.

|

| [13] |

KIM M, SINGH MOIRANGTHEM D, LEE M. Towards abstraction from extraction: Multiple timescale gated recurrent unit for summarization[C]//Proceedings of the 1st Workshop on Representation Learning for NLP. Berlin, Germany: ACL, 2016: 70-77.

|

| [14] |

SEE A, LIU P J, MANNING C D. Get to the point: Summarization with pointer-generator networks[C]//Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Vancouver, Canada: ACL, 2017: 1073-1083.

|

| [15] |

FARZINDAR A, LAPALME G. LetSum, an automatic legal text summarizing system[M]//GORDON T F. Legal Knowledge and Information Systems: JURIX 2004: The Sevententh Annual Conference. Berlin, Germany: IOS Press, 2004, 120: 11-18.

|

| [16] |

HACHEY B, GROVER C. Extractive summarisation of legal texts[J]. Artificial Intelligence and Law, 2007, 14(4): 305-345. DOI:10.1007/s10506-007-9039-z |

| [17] |

POLSLEY S, JHUNJHUNWALA P, HUANG R H. Casesummarizer: A system for automated summarization of legal texts[C]//Proceedings of the COLING 2016, the 26th International Conference on Computational Linguistics: System Demonstrations. Osaka, Japan: ACL, 2016: 258-262.

|

| [18] |

BROWN T B, MANN B, RYDER N, et al. Language models are few-shot learners[C]//Proceedings of the 34th International Conference on Neural Information Processing Systems. Vancouver, Canada: Curran Associates Inc., 2020: 1877-1901.

|

| [19] |

GOYAL T, LI J J, DURRETT G. News summarization and evaluation in the era of GPT-3[EB/OL]. (2023-05-26)[2024-07-30]. https://arxiv.org/pdf/2209.12356.

|

| [20] |

ZHANG T Y, LADHAK F, DURMUS E, et al. Benchmarking large language models for news summarization[J]. Transactions of the Association for Computational Linguistics, 2024, 12: 39-57. DOI:10.1162/tacl_a_00632 |

| [21] |

YANG X J, LI Y, ZHANG X L, et al. Exploring the limits of ChatGPT for query or aspect-based text summarization[EB/OL]. (2023-02-16)[2024-07-30]. https://arxiv.org/pdf/2302.08081.

|

| [22] |

DAN J P, HU W X, WANG Y M. Enhancing legal judgment summarization with integrated semantic and structural information[J/OL]. Artificial Intelligence and Law, (2023-11-26)[2024-07-30]. https://link.springer.com/article/10.1007/s10506-023-09381-8.

|

| [23] |

CHEN B H, ZHANG Z F, LANGRENÉ N, et al. Unleashing the potential of prompt engineering in large language models: A comprehensive review[EB/OL]. (2024-06-18)[2024-07-30]. https://arxiv.org/pdf/2310.14735.

|

| [24] |

BAI J Z, BAI S, CHU Y F, et al. Qwen technical report[EB/OL]. (2023-09-28)[2024-07-30]. https://arxiv.org/pdf/2309.16609.

|

| [25] |

LIN C Y. Rouge: A package for automatic evaluation of summaries[C]//Proceedings of the Text Summarization Branches Out. Barcelona, Spain: ACL, 2004: 74-81.

|

| [26] |

BAI J Z, BAI S, CHU Y F, et al. Qwen technical report[EB/OL]. (2023-09-28)[2024-07-30]. https://arxiv.org/pdf/2309.16609.

|

| [27] |

ZHU C G, LIU Y, MEI J, et al. MediaSum: A large-scale media interview dataset for dialogue summarization[C]//Proceedings of 2021 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Online: ACL, 2021: 5927-5934.

|

| [28] |

MIHALCEA R, TARAU P. Textrank: Bringing order into text[C]//Proceedings of 2004 Conference on Empirical Methods in Natural Language Processing. Barcelona, Spain: ACL, 2004: 404-411.

|

| [29] |

LIU Y. Fine-tune BERT for extractive summarization[EB/OL]. (2019-09-05)[2024-07-30]. https://arxiv.org/pdf/1903.10318.

|

| [30] |

DONG L, YANG N, WANG W H, et al. Unified language model pre-training for natural language understanding and generation[C]//Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver, Canada: Curran Associates Inc., 2019: 32.

|

| [31] |

SEE A, LIU P J, MANNING C D. Get to the point: Summarization with pointer-generator networks[C]//Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Vancouver, Canada: ACL, 2017: 1073-1083.

|

| [32] |

魏鑫炀, 秦永彬, 唐向红, 等. 融合法条的司法裁判文书摘要生成方法[J]. 计算机工程与设计, 2023, 44(9): 2844-2850. WEI X Y, QIN Y B, TANG X H, et al. Method of abstracting judgement document combined with law[J]. Computer Engineering and Design, 2023, 44(9): 2844-2850. DOI:10.16208/j.issn1000-7024.2023.09.037 (in Chinese) |

| [33] |

DEVLIN J, CHANG M W, LEE K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding[C]//Proceedings of 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1(Long and Short Papers). Minneapolis, USA: ACL, 2019: 4171-4186.

|

| [34] |

DAN J P, HU W X, WANG Y M. Enhancing legal judgment summarization with integrated semantic and structural information[J/OL]. Artificial Intelligence and Law, (2023-11-26)[2024-07-30]. https://link.springer.com/article/10.1007/s10506-023-09381-8.

|

| [35] |

YOUNG A, CHEN B, LI C, et al. Yi: Open foundation models by 01. AI[EB/OL]. (2024-03-07)[2024-07-30]. https://arxiv.org/pdf/2403.04652.

|

| [36] |

DAN J P, HU W X, WANG Y M. Enhancing legal judgment summarization with integrated semantic and structural information[J/OL]. Artificial Intelligence and Law, (2023-11-26)[2024-07-30]. https://link.springer.com/article/10.1007/s10506-023-09381-8.

|

| [37] |

OpenAI, ACHIAM J, ADLER S, et al. Gpt-4 technical report[EB/OL]. (2024-03-04)[2024-07-30]. https://arxiv.org/pdf/2303.08774.

|

| [38] |

PU D Q, WANG Y F, DEMBERG V. Incorporating distributions of discourse structure for long document abstractive summarization[C]//Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Toronto, Canada: ACL, 2023: 5574-5590.

|